Ach, was bin ich froh, das mein Gaming Leben nicht durch und von RT bestimmt wird. Das ganze rumgehype kann ich ganz entspannt von aussen betrachten und spiele derweil meine oldskool Raster Games. Bis es das Wing Commander des Raytracing gibt, wird noch etliche Zeit vergehen. So long and goodbyeKlever schrieb:Gravierend schlecht ist die reine RT Leistung der großen Navis gar nicht, die 6800XT hat im Prinzip dieselbe RT Rohleisung wie die 2080 Ti/3070, aber DLSS wurde im Test auch nicht berücksichtigt und beeinflusst die FPS im Test bei Ampere nicht.

Wenn es gelaufen wäre, würde eine 2070 Non-Super schon mehr FPS haben, als eine 6800 XT. Als gesonderten Vergleich würde ich deswegen DLSS auch aufführen, weil es durchaus für den Kunden relevant sein kann, im Direktvergleich dann wenn die AMD Variante erschienen ist.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Grafikkarten 2021 Q2 im Test: GeForce RTX und Radeon RX mit rBAR im Benchmark-Duell

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 5.091

Du hast vollkommen Recht, alles Andere wäre ja auch verwunderlich@dumb MAXED.(x)DaHell63 schrieb:WOW hat nur RT Schatten und trotzdem ist die RTX 3080 ~48% schneller...wenn man jetzt nicht gerade deine 720p Auflösung nimmt.

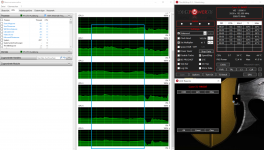

Mich hat in dem speziellen Fall der CPU-Impact interessiert, weil ich nur ne kleine 6c/6t-CPU habe.

(reicht normalerweise für SP aus)

(x) mit ner RDNA2 würde ich nur auf "Shadows fair" gehen, kann man sich die 3080 eigentlich sparen

(wieso mit Shadows high die minFps bei der 3080 besser werden kann eigentlich nur mit nem vergamemurksten "reduzierten" LOD einhergehen, die 6800XT benimmt sich Da erwartungsgemäß mit vermutlich nichtreduziertem LOD)

Anhänge

Zuletzt bearbeitet:

- Registriert

- Mai 2011

- Beiträge

- 22.482

Hast du meinen Post gelesen? Das ist ein Fehler bei der Beschriftung, der wert der mit fair betitelt ist, ist high(der im übrigen nicht nur schlechtere mins sondern auch schlechtere avg hat)GerryB schrieb:(wieso mit Shadows high die minFps bei der 3080 besser werden kann eigentlich nur mit nem vergamemurksten "reduzierten" LOD einhergehen, die 6800XT benimmt sich Da erwartungsgemäß mit vermutlich nichtreduziertem LOD)

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 5.091

Danke für die Info!

Komisch, das der Fehler net korrigiert wurde.

Im zug. Diskussionthread findet sich übrigens kein Hinweis auf Deine Vermutung!?

Eher schütteln Alle, mit Brille, den Kopf über das Wunder.

Insofern ist mir CB 3x lieber, weil Wolfgang ordentlich auf Fragen im Thread eingeht.

Komisch, das der Fehler net korrigiert wurde.

Im zug. Diskussionthread findet sich übrigens kein Hinweis auf Deine Vermutung!?

Eher schütteln Alle, mit Brille, den Kopf über das Wunder.

Insofern ist mir CB 3x lieber, weil Wolfgang ordentlich auf Fragen im Thread eingeht.

Zuletzt bearbeitet:

- Registriert

- Mai 2011

- Beiträge

- 22.482

Dabei ist es eigentlich opffensichtich. Direkt im Text von PCGH unter den Graphen heißt es, dass sich Fair und Good in der Testszene nichts nehmen in der Leistung. Die beiden, die sich im Graphen nichts nehmen, sind aber Good und High, während Fair als schwächste Lösung am schlechtesten laufen soll.GerryB schrieb:Komisch, das der Fehler net korrigiert wurde.

Im zug. Diskussionthread findet sich übrigens kein Hinweis auf Deine Vermutung!?

Auch steht im Test, dass die 3080 23% durch RT High ggü RT Off verliert, was genau dem entspricht, was in der Tabelle für RT Fair steht.

Und in deinem verlinkten 720p Test hat die 3080 70fps mit RT High gemacht, es ist also ausgeschlossen, dass sie in 4K plötzlich 74fps schaffen könnte, das müssen also die 67fps sein.

Ich hab den Thread nicht gelesen und hätte ja gesagt es haben dann wohl einfach alle so hingenommen, weil es ersichtlich ist, dass man die zwei Werte tauschen muss, aber wenn sich im Thread wirklich Leute wundern über die Zahlen.... naja mit etwas Verständnis von der Materie hätte man spätestens bei dem 70fps 720p und 74fps 4K Ergebniss drauf kommen müssen, dass eines von beiden nicht stimmen kann^^

Zuletzt bearbeitet:

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 5.091

oderTaxxor schrieb:Und in deinem verlinkten 720p Test hat die 3080 70fps mit RT High gemacht, es ist also ausgeschlossen, dass sie in 4K plötzlich 74fps schaffen könnte, das müssen also die 67fps sein.

Wie subjektiv von mir vermutet ändert sich mit höherem RT das LOD für verschiedene Dinge.

(=Entlastung der CPU... kann man u.U. auch am AF sehen... bei CP wars dann kein AF16x auf den Straßen+Wegen)

subjektiv gedacht: RT kann net performand overall geschehen, deswegen wird ne Art Box festgelegt, die dann

mit RT in der festgelegten Qualität bearbeitet wird.

Und außerhalb der Box wird gespart.

- Registriert

- Mai 2011

- Beiträge

- 22.482

@GerryB

Wie im Artikel geschrieben

Ein Fehler in der Tabelle ist also unter Berücksichtigung der sonstigen Äußerungen im Artikel, am wqhrscheinlichsten.

Wie im Artikel geschrieben

Also ist Gut nur minimal bis gar nicht langsamer als Mittel, und in der Tabelle ist bei der 3080 sowohl Gut als auch Hoch deutlich schneller als Mittel? Passt nicht zum Text, der dann wie folgt weiter geht"Gut" lässt auch lokale Lichtquellen wie Fackeln entsprechende Schatten werfen, allerdings spielen diese zur Benchmarkzeit in Stormwind offenbar keine Rolle, diese Qualitätsstufe gibt es fast kostenlos.

Und was sind die 86,7fps der 3080 ohne RT minus rund 23%? Genau die 67,1fps die in der Tabelle mit Mittel beschriftet sind. Die 74,3fps die in der Tabelle mit High beschriftet sind, wären nur -14%.Deutlichere Auswirkungen auf Optik und Bildrate hat die höchste Stufe: "Hoch" senkt die Bildrate auf einer Radeon RX 6800 XT um beinahe 28 Prozent und die Fps einer Geforce RTX 3080 um rund 23 Prozent

Ein Fehler in der Tabelle ist also unter Berücksichtigung der sonstigen Äußerungen im Artikel, am wqhrscheinlichsten.

Zuletzt bearbeitet:

Klever

Lt. Commander

- Registriert

- Dez. 2020

- Beiträge

- 1.393

foo_1337 schrieb:https://www.pcgameshardware.de/Rayt...cials/ART-Mark-Raytracing-Benchmarks-1371125/

Bei dem PCGH Test sieht man auch, dass Ampere ggü. Turing im Hinblick auf RT dazugewonnen hat. Und anhand der 2060s wie wichtig DLSS / FFS sein kann, wenn es um RT geht.

Mit Sicherheit eine interessante Machbarkeitsstudie, wie die zukünftige allumfassende Raytracing Implementation aussehen kann, aber ich finde der Artikel hat da schon recht wenn die anmerken, dass derart hochkomplexe Berechnungen in Spielen erst gegen Ende des Jahrzehnts erwartet werden, wenn die jetzige Harware schon locker mindestens 7-8 Jahre auf dem Buckel hat. Bis dahin wird es mit Sicherheit zig neue Gens sowohl bei AMD wie auch Nvidia geben, die diese Berechnungen besser stemmen können sei es mit unterschiedlichen Ansätzen oder mit dem gleichen.

Ampere hat gegenüber Turing in der Tat durch RT-Cores der zweiten Gen und Tensor-Kernen der dritten Gen (ab der Volta-Gen mit der ersten Implementation) dazugewonnen, da die Spiele aber selbst unter hoher RT-Implementation weiterhin auf Hybrid-Rasterisierung setzen, sieht man ja trotzdem an den RT-Benchmarks wo eine 2080 Ti auch in RT Spielen auf dem Level einer 3070 liegt bzw je nach Spiel ein klein wenig langsamer oder schneller ist und die RDNA2 Karten der höchsten Ausbaustufe (6800XT/6900XT) auch bei RT Spielen bis auf DLSS eine passable Figur machen. So kann in diesem Benchmark die 6900XT die 2080 Ti in Ultra RT Einstellungen leicht schlagen (welche von den Einstellungen wohl trotzdem umgemünzt auf Spiele unspielbar für beide Karten sind), in spielbarem RT High ist gar die 2080 Ti schneller als die 6900 XT und die 6800 XT.

VRAM-Größe wird da auch in Zukunft trotzdem eine Rolle spielen imo, wie man an manchen Titeln jetzt schon sieht (bei weitem nicht allen, aber 8 GB ist imo mittlerweile das Minimum was man bei neuen Titeln haben sollte).

Meiner Meinung nach hätten sie der 3070 die 10 GB der 3080 verpassen sollen, dann wäre das eine viel rundere Karte, die sich auch vor den Konsolen die ca. 10 GB an VRAM zur Verfügung haben, nicht zu verstecken bräuchte. So wird es denke ich so sein, dass die 3070 trotz ihren 8 GB mit der 2080 Ti durch mögliche Verbesserungen bei Spieleengines bei RT Implementierung locker mithalten kann bzw auch ein wenig schneller sein wird, die 2080 Ti wird aber nicht zurückfallen bedingt durch mehr VRAM der je nach Spiel ausgiebiger benutzt wird, in den Szenarien etwas schneller sein.

Auf jeden Fall aber ein interessanter Benchmark zum Vergleich, hab es bei mir auch mal laufen lassen, komme da schon auf bessere Ergebnisse als die bei PCGH mit der 2080 Ti, liegt aber wahrscheinlich daran dass die eine FE benutzen und ich eine Custom habe, die generell schneller ist. Deren 5950X sollte aber in 1080p mehr Rechenpower haben, als mein 9900K inklusive Single Core (was ja auch eine Rolle spielen kann da wie einige in Kommentaren da anmerken, die Karte da bei RT Szenarien nur bezüglich RT Pipelines ausgelastet ist und es nicht zu voller Auslastung kommt).

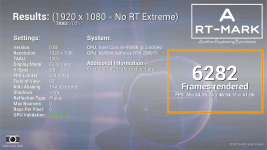

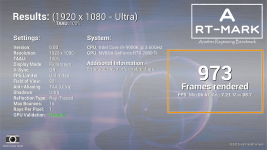

Habe da bei Preset No_RT_Extreme 6282 gerenderte Frames mit der 2080 Ti im Vergleich zu 5429 bei der 6900 XT im PCGH Test, 5821 bei der 2080 Ti, 5511 bei der 3060 Ti und 3353 bei der 6700 XT (da ist meine 2080 Ti bei dem Preset ohne RT wohl fast doppelt so schnell).

Bei Preset RT_High kommt meine 2080 Ti auf 4666 Frames, die 6900 XT kommt bei PCGH auf 3911, die 2080 Ti auf auf 4073, die 3060 Ti auf 4829 und die 6700 XT liegt bei 2265 Frames.

Mit Preset RT_Ultra liegt meine 2080 Ti bei 973 Frames, bei PCGH liegt die 6900 XT bei 1091, die 2080 Ti bei 887, die 3060 Ti bei 1351 und die 6700 XT bei 627 Frames.

Da sieht man imo auch gut, welchen Unterschied die Ergebnisse mit Bezug auf die einzelnen individuell konfigurierte Systeme haben können.

Anhänge

Zuletzt bearbeitet:

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 5.091

Das ist net die Frage und das Problem bei minFPS, sondern:Taxxor schrieb:@GerryB

Durch die deutlich höhere theoretische FP32 Leistung ..

"Die Raytracing-Schatten verursachen in jedem Fall einen Overhead, einen stets zu stemmenden Mindestaufwand. Dieser geht, so unsere Beobachtungen, zulasten des Prozessors, sodass Raytracing in WoW stets geringere Bildraten in CPU-lastigen Szenarien zur Folge hat als ohne Raytracing."

Anscheinend ist der Overhead bei NV außerdem noch größer als bei AMD.

-->größere CPU erf.!

Das soll erstmal reichen von meiner Seite aus. Wg. ein paar % mehr oder weniger in Game XYZ werde ich mich net verrückt machen, Dafür gibts Regler, um die Fps passend zum Freesync-Moni zu erreichen.(34-60fps)

Zuletzt bearbeitet:

- Registriert

- Mai 2011

- Beiträge

- 22.482

Ja, in 720p/CPU Limit.GerryB schrieb:Anscheinend ist der Overhead bei NV außerdem noch größer als bei AMD.

-->größere CPU erf.!

In deinem Post ging es aber doch darum, dass Control und Cyberpunk Sonderfälle sein sollten und WoW als "neutraler" Titel ganz normal funktioniert, dabei liegt doch auf der Hand, dass der Unterschied hier nur kleiner ist, weil außer performancemäßig günstigen Schatten nicht viel RT genutzt wird.

Das wird selbst im Beispiel WoW gezeigt, wo der Vorsprung der 3080 größer wird, je weiter man die Qulität jener RT Schatten erhöht -> je mehr RT, desto weiter fällt RDNA2 zurück.

Das gleiche zeigt sich auch in Metro Exodus Enhanced, wo der Abstand zwischen 6800XT und 3080 ebenfalls immer größer wird, je weiter man die Qualität der Global Illumination aufdreht.

Hast du auch Zahlen zu 6800XT und 3080 in Control oder Cyberpunk in 720p?

Dort dürfte sich das gleiche Verhalten zeigen und die 6800XT stärker zulegen und näher an die 3080 herankommen. Für die Praxis, bei der diese Karten in 1440p+ betrieben werden, ist das aber nicht sonderlich relevant.

Zuletzt bearbeitet:

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 5.091

Eigentlich wollte ich net mehr das Thema vertiefen, aber bei 4k@fairTaxxor schrieb:Ja, in 720p/CPU Limit.

siehst Du doch ganz genau, das die 3080 nur die selben minFps schafft wie die 6800xt.

Ende von dem Schwachsinn...für mich!

btw.

https://www.pcgameshardware.de/Metro-Exodus-Spiel-62179/News/Enhanced-Release-1371140/

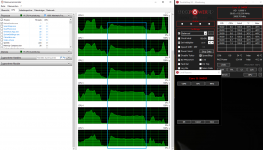

Um das bevorstehende ME-RT-Special mal mit der alten Version zu vgl., nur mal kurz den Startpunkt

mit 1440p@60fps angeschaut: CPU-Last liegt bei ca. 50%allcore.

(mal schauen wie die RTonly Version dann die CPU-Last ändert)

edit: RE-Village ist noch ein mue schonender für die CPU (im Schloss)

edit2: D5-high Benchmark kostet in 4k ungefähr soviel wie ME in 1440p an CPU-Last

Anhänge

Zuletzt bearbeitet:

- Registriert

- Mai 2011

- Beiträge

- 22.482

Ja, wenn du weiterhin ignorierst, dass das was dort bei der 3080 als Fair betitelt ist, eben in Wirklichkeit High ist, die Belege dafür hab ich doch jetzt schon mehrfach ausführlich beschrieben.GerryB schrieb:Eigentlich wollte ich net mehr das Thema vertiefen, aber bei 4k@fair

siehst Du doch ganz genau, das die 3080 nur die selben minFps schafft wie die 6800xt.

Somit schafft die 3090 mit RT High 49 min FPS und die 6800XT 40

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 5.091

Schreib doch in dem pcgh-Thread nen "gescheiten" Post, vllt. wirds geändert, wenn Deine Vermutung stimmt.

Was soll die Diskutiererei im falschen Forum?

btw.

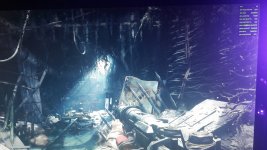

Review zu RE-Village:

https://www.overclock3d.net/reviews...llage_pc_port_report_and_performance_review/8

(für die 6800 kann man ruhig auf Performance gehen, sieht bei mir OK aus)

Was soll die Diskutiererei im falschen Forum?

btw.

Review zu RE-Village:

https://www.overclock3d.net/reviews...llage_pc_port_report_and_performance_review/8

(für die 6800 kann man ruhig auf Performance gehen, sieht bei mir OK aus)

Anhänge

Zuletzt bearbeitet:

- Registriert

- Mai 2011

- Beiträge

- 22.482

Da sehen die Bilder von CB aber ganz anders aus und auch das Fazit ist eindeutigGerryB schrieb:Review zu RE-Village:

https://www.overclock3d.net/reviews...llage_pc_port_report_and_performance_review/8

(für die 6800 kann man ruhig auf Performance gehen, sieht bei mir OK aus)

https://www.computerbase.de/artikel..._shading_reduziert_sichtbar_die_bildqualitaet

VRS ist keine Empfehlung

Bereits die Ausgeglichen-Option lässt viele Details verschwinden, was auch den gesamten Bildbereich betrifft.

Bei overclock3d steht allerdings, dass bei Nvidia Grafikfehler in Verbindung mit VRS aufgetreten sind, möglicherweise stimmt hier noch was nicht. Mal schauen was Wolfgang im Thread dazu sagt, vielleicht hat man hier ja nur mit einer Nvidia GPU genauer hingeschaut und die Bilder gemacht.

Edit: Ja, wurden mit einer Nvidia GPU gemacht

Zuletzt bearbeitet:

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 5.091

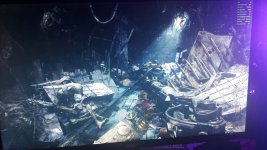

Dann könntest Du mal bitte VRS... normal schreiben bis zur Klärung.

https://www.forum-3dcenter.org/vbulletin/showpost.php?p=12671841&postcount=2174

(k.A., obs NV-spezifisch ist)

Ich persönlich würde Integer net verwenden, scheint etwas schlechter beim AA zu sein.

Was ich net verstehe, Du postest in jedem Thread nen Haufen Vermutungen, aber lädts die Games net mal schnell runter, um selber nachzuschauen!? ....Bist Du Journalist oder Gamer?

Die RE-Village-Demo hat nur 9,5GB.(mach mal ne Kaffeepause)

Bei mir funzt VRS@Performance wunderbar! (übrigens auch in D5)

Das Problem von Wolfgang mit dem Feuer sehe ich net bei mir, habe allerdings 21.4.1 WHQL und net den

komischen Presse 21.5.1beta.

https://www.forum-3dcenter.org/vbulletin/showpost.php?p=12671841&postcount=2174

(k.A., obs NV-spezifisch ist)

Ich persönlich würde Integer net verwenden, scheint etwas schlechter beim AA zu sein.

Was ich net verstehe, Du postest in jedem Thread nen Haufen Vermutungen, aber lädts die Games net mal schnell runter, um selber nachzuschauen!? ....Bist Du Journalist oder Gamer?

Die RE-Village-Demo hat nur 9,5GB.(mach mal ne Kaffeepause)

Bei mir funzt VRS@Performance wunderbar! (übrigens auch in D5)

Das Problem von Wolfgang mit dem Feuer sehe ich net bei mir, habe allerdings 21.4.1 WHQL und net den

komischen Presse 21.5.1beta.

Anhänge

Zuletzt bearbeitet:

MMIX

Lieutenant

- Registriert

- Dez. 2020

- Beiträge

- 551

Also so schlecht wie manche hier (und im RE Village Thread) meinen, ist eine RDNA2 GPU mit Raytracing in Metro Exodus Enhanced nicht:

https://www.hardwareluxx.de/index.p...tion-ein-blick-in-die-raytracing-zukunft.html

Klar, eine GeForce bleibt schneller plus Möglichkeit DLSS 2.1, aber spielbar mit guten Fps ist es mit RDNA2

https://www.hardwareluxx.de/index.p...tion-ein-blick-in-die-raytracing-zukunft.html

Klar, eine GeForce bleibt schneller plus Möglichkeit DLSS 2.1, aber spielbar mit guten Fps ist es mit RDNA2

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 5.091

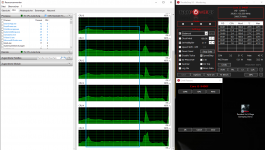

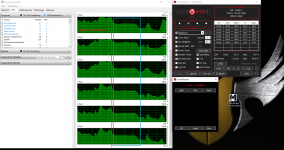

Jo,

mit High + RT normal ist ne 6800nonXT in WQHD ganz vernünftig vom Verbrauch her.

High + RT high kostet bis zu 40W mehr. Ultra hab ich dann gar net mehr probiert.

Übrigens war VRS=4x. (Treiber 21.4.1)

(Enhanced funzt Allonestanding)

edit: mal noch die CPU@RTnormal ...ist wie in der Standard Edition.(ca. 35W)

(damit GPU185W+CPU35W=220W gesamt ... passt für 24/7)

https://www.amd.com/en/support/kb/release-notes/rn-rad-win-21-5-1

(erstmal abwarten, obs Probleme mit dem Beta gibt)

mit High + RT normal ist ne 6800nonXT in WQHD ganz vernünftig vom Verbrauch her.

High + RT high kostet bis zu 40W mehr. Ultra hab ich dann gar net mehr probiert.

Übrigens war VRS=4x. (Treiber 21.4.1)

(Enhanced funzt Allonestanding)

edit: mal noch die CPU@RTnormal ...ist wie in der Standard Edition.(ca. 35W)

(damit GPU185W+CPU35W=220W gesamt ... passt für 24/7)

https://www.amd.com/en/support/kb/release-notes/rn-rad-win-21-5-1

(erstmal abwarten, obs Probleme mit dem Beta gibt)

Anhänge

Zuletzt bearbeitet:

F

foo_1337

Gast

Die neuesten Gerüchte zu FSR: https://videocardz.com/newz/coreteks-amd-fidelityfx-super-resolution-fsr-to-launch-in-june

Nach dem Interview mit Herkelman und Azor letztens eher unglaubwürdig, aber wer weiß.. Mich würde es freuen.

Nach dem Interview mit Herkelman und Azor letztens eher unglaubwürdig, aber wer weiß.. Mich würde es freuen.

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 5.091

Hier mal ein Video mit der 6900@1440p Full-RT.

(muss Jeder selbst wissen, ob Ultra@RDNA2 sinnvoll ist ...mit h2o evtl. erträglich)

(muss Jeder selbst wissen, ob Ultra@RDNA2 sinnvoll ist ...mit h2o evtl. erträglich)

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

MMIX

Lieutenant

- Registriert

- Dez. 2020

- Beiträge

- 551

foo_1337 schrieb:Die neuesten Gerüchte zu FSR: https://videocardz.com/newz/coreteks-amd-fidelityfx-super-resolution-fsr-to-launch-in-june

Nach dem Interview mit Herkelman und Azor letztens eher unglaubwürdig, aber wer weiß.. Mich würde es freuen.

Da ist mir AMD wieder einmal "zu nett", weil das ja laut Artikel auch auf Nvidia GPUs laufen soll (gab ja vorher auch schon solche Gerüchte) Ist zwar wieder einmal löblich von AMD einen offenen Standard zur Verfügung zu stellen, aber dann hat Nvidia zukünftig einfach das bessere Paket weil sowohl DLSS wie FFX SR dort funktioniert. Zwar wird wegen den Konsolen FFX SR meiner Meinung breitere Unterstützung in Zukunft finden, kann dann den Nvidia Usern ja egal sein.

Ähnliche Themen

- Antworten

- 356

- Aufrufe

- 122.155

- Antworten

- 691

- Aufrufe

- 223.087