@Fighter1993

Es gibt zumindest Fidelity FX CAS seit Release.

Ansonsten muss gesagt sein, dass Cyberpunk wohl bisher das mit abstand fordernste RT Game ist. (abgesehen von Pathtracing Spielen)

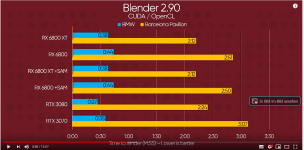

Die RTX 3080 verliert in 1440p mit Full RT in Dying Light 2 41% an performance, während die Karte in Cyberpunk 55% einbüßt.

Die 6800XT verliert in Dying Light 2 64% an Performance und in Cyberpunk 76% an Performance.

In Cyberpunk kostet RT also sowohl auf einer Geforce als auch einer Radeon mehr Leistung, weil einfach mehr bzw. aufwändigere RT Effekte genutzt werden. Ich sehe da jetzt nichts, was sonderlich Nvidia optimiert wäre oder ein Indiz dafür wäre.

Zudem ist nunmal bekannt, dass RDNA2 einzelne RT Effekte ganz gut beschleunigen kann, jedoch eine hohe Bandbreite an Effekten dazu führt, dass die Performance drastisch einbricht, eben stärker als bei Nvidia.

Man kann also für RDNA2 primär dahingehend optimieren, dass man weniger Effekte einsetzt bzw. sehr sparsam mit RT umgeht. Dann ist RDNA2 auch im Vergleich zu Geforce ganz okay. Wenns aber in die "Breite" geht ist RDNA2 massiv im Nachteil.

Das ist doch seit Anfang an bekannt gewesen.

Man sieht ja in DL2 auch auf den Konsolen, dass der RT Mode nur in 1080p mit 30 FPS läuft und dazu noch ohne Global Illumination. Ich denke die Entwickler hätten schon dafür gesorgt, dass RT auf den Konsolen besser läuft, wenn das machbar gewesen wäre, haben sie aber nicht. Ich hoffe, dass qualitätsstufen für die einzelnen Effekte reingepatcht werden und die könnte man dann natürlich auch auf den Konsolen nutzen. Aber das wäre ja auch wieder ein Indiz dafür, dass nicht die Programmierung oder Optimierung für Nvidia schuld an der schlechten Performance ist, sondern einfach nur die hohe RT Last.

Letztendlich wird Cyberpunk in seiner Next-Gen Version ein interessanter Fall, denn dann wird wahrscheinlich Raytracing auf die Konsolen gebracht. Da wird sich dann ja zeigen, ob die Effekte plötzlich nur auf RDNA2 viel besser laufen, weil sie zuvor so stark Nvidia optimiert waren, ob die Konsolen genauso performen, wie das aktuell zu erwarten wäre aufgrund der RDNA2 performance auf dem Desktop oder ob die Effekte generell entschlackt wurden und auf allen Karten schneller laufen werden, weil man z.B. allgemein weniger Rays nutzt.

Was auch immer getan wird, es wird aufschlussreich.