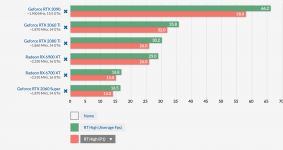

@GerryB Beim Vergleich mit WoW ist doch auch wieder zu beachten, dass WoW einzig RT Shadows nutzt, wie im Artikel auch beschrieben ist

Wenn es um Raytracing geht, stellen Schatten den ressourcenschonendsten Effekt dar. Die düsteren Zeitgenossen kommen selten bildfüllend vor, brechen kein Licht und sind daher relativ günstig zu haben.

Durch die deutlich höhere theoretische FP32 Leistung von Ampere, setzen sie sich vor allem deutlicher vor RDNA2, wenn RT großflächiger genutzt wird, was in CP und Control eben der Fall ist.

Dazu ist dein Screenshot aus dem CPU Test, wo RDNA2 durch DX12 profitiert und die CPU entlastet, die durch RT ebenfalls mehr gefordert wird.

Im GPU Limit ist die 3080 immer noch schneller, auch wenn nur RT Schatten genutzt werden. Und je mehr zusätzliche RT Effekte neben den Schatten dazu kommen, desto größer wird auch der Abstand.

DaHell63 schrieb:

Dein Beispiel WOW hat nur RT Schatten und trotzdem ist dei RTX 3080 ~48% schneller...wenn man jetzt nicht gerade deine 720p Auflösung nimmt.

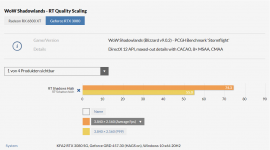

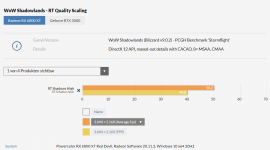

Die 74,3fps die bei der 3080 mit RT High stehen, halte ich übrigens für einen Fehler in der Tabelle, da im Text darunter von 23% Differenz bei der 3080 gesprochen wird, die genau auf die 67,1fps passen, die dort mit RT Mittel betitelt sind und es auch keinen Sinn macht, dass RT Mittel als niedrigste Stufe langsamer sein sollte als Good und High(und im CPU Test in 720p nur 70fps mit RT High erreicht wurden, wie sollen da 74fps in 4K möglich sein?).

Und allgemein muss man beachten, dass die 3080 ja auch ohne RT schon 24% schneller als die 6800XT ist, man sollte sich also lieber den relativen Unterschied anschauen:

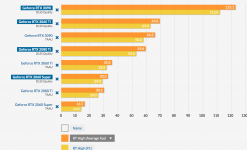

3080 RT Off vs RT High = 86,7fps / 67,1fps -> Differenz : -23%

6800XT RT Off vs RT High = 69,6fps / 50,2fps -> Differenz : -28%

Der Einfluss auf die Performance ist nur durch RT Schatten also gar nicht so verschieden, aber trotzdem geringer bei Ampere und man sieht im Test auch, dass die Differenz größer wird, je höher man die Qualität der RT Schatten stellt.

Mit RT Off liegen sie 24% auseinander, mit RT Mittel 26% und mit RT High 34%, das ist schon ein Indiz, dass mehr RT mehr Abstand bedeutet, selbst wenn es nicht mehr verschiedene Effekte sondern nur ein Effekt ist, der aber stärker genutzt wird.