Test GTX 1080 Ti vs. RX Vega 64 (2024): Wie steht es um „fine wine“ im Duell Pascal gegen Vega?

SH4DOWtheFOX

Ensign

- Registriert

- Dez. 2018

- Beiträge

- 166

Danke schöner Artikel!

pseudopseudonym

Fleet Admiral

- Registriert

- Mai 2017

- Beiträge

- 10.177

3x 1920x1200 mit Eyefinity auf einer RX480. Das ist deutlich über FHD.0x8100 schrieb:warum den test in wqhd machen? jeder, der diese karten noch einsetzt, wird das wohl in fullhd machen.

Tuetensuppe

Admiral

- Registriert

- Juli 2008

- Beiträge

- 7.535

Der eigentliche Sieger dieses Vergleichs ist ganz klar die RTX 2080 Ti.

Erstaunlich gut gealtert, kann man sie auch 5,5 Jahre nach Verkaufsstart problemlos für WQHD einsetzen.

Gebraucht auch heute noch mit einem guten P/L-Verhältnis, man bekommt sie immer öfters für ca. 250 Euro.

Erstaunlich gut gealtert, kann man sie auch 5,5 Jahre nach Verkaufsstart problemlos für WQHD einsetzen.

Gebraucht auch heute noch mit einem guten P/L-Verhältnis, man bekommt sie immer öfters für ca. 250 Euro.

Beitrag

Fleet Admiral

- Registriert

- Nov. 2011

- Beiträge

- 10.816

Ich hab ne 1080 ohne Ti und nutze WQHD.0x8100 schrieb:warum den test in wqhd machen? jeder, der diese karten noch einsetzt, wird das wohl in fullhd machen. ein vergleich mit linux wäre auch interessant gewesen, immerhin gibt es dort noch entwicklung für vega.

Wieso sollte ich die Auflösung mit der Zeit runterstellen? Die bleibt so. Werden in neueren Spielen halt paar Regler nach links geschoben und dann passt das.

0x8100

Fleet Admiral

- Registriert

- Okt. 2015

- Beiträge

- 10.183

aber sicherlich nicht in spielen, die über solitaire hinaus gehen. ist jetzt schon der dritte oder vierte post, wo jemand kund tut, dass er wqhd oder höher auf ner 1080 fährt, aber das wohl kaum mit den im test genannten spielen und settings macht.pseudopseudonym schrieb:3x 1920x1200 mit Eyefinity auf einer RX480. Das ist deutlich über FHD.

ruthi91

Captain

- Registriert

- Nov. 2007

- Beiträge

- 4.090

Ja durchaus, realitätsnahe Settings sehen anders aus. Hätte man vllt anpassen sollen für ein Duell mit so alten Karten. Oder eben auch die Spiele von damals wiederverwenden. Im Prinzip ist ja nur Anno1800 ähnlich alt mit Launch Q2-2019.0x8100 schrieb:ja was meinst du, was ich mir hier gewünscht habe...

Letztendlich hatten die Vegas aber eher das Problem, dass man sie während der Hauptphase ihres Zyklus quasi nicht kaufen konnte, weil es wegen Mining keine gab oder viel zu teuer waren. Beim Ref-Design wurde man taub bzw. die Karte hat geglüht, das Problem hatten 1070 und 1080 nicht.

Erst nach dem Mininghype waren es gute Last-Gen Alternativen wenn einem der Stromverbrauch nicht so wichtig war.

Die FineWine Thematik hätte ich lieber im Duell RX480/580 vs 1060 gesehen oder zumindest in diesem Test zusätzlich mit einer 5700XT. Auch der eigentliche Konkurrent in Form der 1080 fehlt ja. Der 4090 Vergleich hilft hier nicht wirklich weiter.

Eigentlich war der FineWine Begriff ja mal mit besserer Treiberentwicklung besetzt, dieser Test zielt aber darauf ab wie die Architektur altert. Und GTX1000 Pascal war halt eine super DX9/11 Architektur, als RTX2000 rauskam war der Vorsprung auch eher mau, vergleicht man mit Spielen von heute ist der Vorsprung größer + man kann DLSS nutzen bzw. hat überhaupt die RT Möglichkeit.

@DevPandi Also jetzt mal unabhängig von dem ansich interessanten Artikel, der mal (zumindest von der Idee jer) auf Metaebene die Performance betrachten will, eine harte Kritik an die Statistik in diesem Artikel:

Was hier gerechnet wurde war in etwa nämlich folgendes: ein Buggy der zwischen Dschungel und Wüste durchschn. 30kmh schneller fuhr als sonst, fährt zwischen Steppe und Stadt durchschn. 45kmh schneller als üblich. Damit hat der Buggy 50% mehr PS hinzubekommen.

Wozu soll denn dieses Prozentangabenchaos eigentlich gut sein? 52% Zuwachs, 36% mehr.. Ja Angaben wie "52% mehr" klingen imposant, diese Werte der prozentualen.. Prozentsteigerung sind aber völlig belanglos, da sie nicht untereinander vergleichbar sind und von jeweils anderen baselines ausgehen.

Von 1 auf 3 fps hat man auch 200% Zuwachs was nach viel mehr klingt als 10% von 120 auf 132fps. Ohne diese unnötigen Prozentangaben erstpart man sich zudem soviel Ärger (siehe oben). Einfach weglassen!

Es gab ja immer mal wieder kleinere statistische Entgleisungen im einen oder anderen Artikeln aber jetzt muss ich echt mal sagen: das war Murks, nicht kleinkariert sondern inhaltich und methodisch. Damit sind leider auch alle darauf aufbauenden Schlussfolgerungen hinfällig geworden, was einfach vermieden werden könnte.

Vor allem aber ist das am Ende ein Vertrauensverlust (für mich) ob all die anderen Berechnungen dann auch noch stimmen.

Das stimmt nicht, es kann so keine Aussage getroffen werden wieviel schneller RDNA im Unterschied geworden ist. Denn es kann keine einfache Differenz zwischen diesen Zuwächsen, welche auf Mittelwertsunterschieden unterschiedlicher stichproben und Faktoren beruhen, gebildet werden, da sie auf völlig anderen Stichproben (Spielen) beruhen. Das wäre nur möglich wenn die Parkours die exakt selben gewesen wären. Ansonsten bräuchte man weitere statistische Tests um diese Mittelwertszuwächse vergleichen zu können (am ehesten mit Effektstärken) aber selbst dann ist unklar ob diese Rechenakrobatik so noch gültig wäre.Beim Release konnte sich die 5700 XT von der Vega 56 um knapp 29 Prozent absetzen, im Generationenvergleich waren es etwas bessere 37 Prozent. RDNA ist damit 28 Prozent schneller als 2019.

Was hier gerechnet wurde war in etwa nämlich folgendes: ein Buggy der zwischen Dschungel und Wüste durchschn. 30kmh schneller fuhr als sonst, fährt zwischen Steppe und Stadt durchschn. 45kmh schneller als üblich. Damit hat der Buggy 50% mehr PS hinzubekommen.

Auch hier, Äpfel mit Birnen.Turing und Pascal verhalten sich anders. Eine RTX 2070 konnte sich 2018 im Mittel um knapp 31 Prozent absetzen, im Generationenvergleich sind es deutlich schnellere 47 Prozent, das sind 52 Prozent Zuwachs. Ähnlich verhält es sich mit der 60er-Serie: Im initialen Test waren es 58 Prozent und nun sind es 79 Prozent, was 36 Prozent mehr entspricht.

Wozu soll denn dieses Prozentangabenchaos eigentlich gut sein? 52% Zuwachs, 36% mehr.. Ja Angaben wie "52% mehr" klingen imposant, diese Werte der prozentualen.. Prozentsteigerung sind aber völlig belanglos, da sie nicht untereinander vergleichbar sind und von jeweils anderen baselines ausgehen.

Von 1 auf 3 fps hat man auch 200% Zuwachs was nach viel mehr klingt als 10% von 120 auf 132fps. Ohne diese unnötigen Prozentangaben erstpart man sich zudem soviel Ärger (siehe oben). Einfach weglassen!

Es gab ja immer mal wieder kleinere statistische Entgleisungen im einen oder anderen Artikeln aber jetzt muss ich echt mal sagen: das war Murks, nicht kleinkariert sondern inhaltich und methodisch. Damit sind leider auch alle darauf aufbauenden Schlussfolgerungen hinfällig geworden, was einfach vermieden werden könnte.

Vor allem aber ist das am Ende ein Vertrauensverlust (für mich) ob all die anderen Berechnungen dann auch noch stimmen.

Zuletzt bearbeitet:

Es macht jetzt keinen Unterschied mehr.Poati schrieb:Macht jetzt im Endeffekt keinen großen Unterschied.

Zu Release hätte es einen Unterschied gemacht.

Die Karten sind alle Uralt. Ja schon quasi "Ancient".

Ich finde es dennoch beeindruckend, dass diese Karten heute, bald 8 Jahre nach Release so eine Leistung haben um meistens aktuelle Titel mit FSR o.ä. noch flüssig (also >30-35FPS) abzuspielen, wenn nicht sogar mehr und von E-Sports müssen wir nicht reden da läuft eh alles noch.

Das ist beeindruckend, davor kann man nur seinen Hut ziehen.

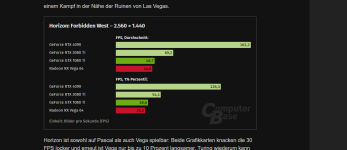

Einfach mal diesen Horizon Forbidden West als Random Beispiel rauspicken.

Was ist das, das ist ein super Spielerlebnis für die Leute, die noch solche Karten besitzen.40 FPS in WQHD.

Ich hab selber von den RX Vega Karten nix gehalten, hatte selber eine GTX 1080 und war mehr als zufrieden.

Neben der 2080Ti vermutlich die langlebigsten Karten die es von NV bisher überhaupt gab.

Um die Karten die nächsten 2 Jahre tot zu kriegen muss NV die ja schon fast aus dem Treibersupport killen.....

Anhänge

Chismon

Admiral

- Registriert

- Mai 2015

- Beiträge

- 9.262

Ja, in einer idealen Welt (wo nVidia nicht das Quasi-Monopol ausspielen kann und Leute nVidia beim Kauf der Grafikkarte nicht überwiegend hinterher rennen, siehe Marktanteile) wären 24 GB nächstes Jahr wohl angebracht für eine RTX 5070, aber ich fände auch schon ein 320Bit Speicherinterface und 20 GB dafür sehr fair und das dürfte nicht einmal eine RTX 5080 bekommen in 2025, wenn die Gerüchte sich bewahrheiten sollten.berntzahltnull4 schrieb:Eine RTX 5070 sollte 24 gbt Ram haben oder die nächst höhere Technik und wenigstens 16 gbt.

16 Gbt im Jahr 2025! Und wetten die 5070 wird 1000 kosten. Aber fix.

Das war ja genau so mit der rtx 4060 ti-- mit einer 256 Schnittstelle wäre die halt die kleine 4080ger

geworden.

Wenigstens ist bei den 80er Karten vorausssichtlich nicht die Kernezahl weiter reduiziert worden im Vergleich zur Vorgeneration und die Kluft einer RTX 5070 zur RTX 5090 ist schon ziemlich lächerlich, was man am Ende bekommen dürfte für das Geld und ja, ich rechne auch eher mit Preisen um 700 bis 800 Euro für die 70er Karte und die wohl noch letzte lohnend konfigurierte, beschnittene GB203 Karte in Form einer RTX 5070Ti (16 GB) dürfte evt. schon arg an der 1000 Euro Marke kratzen.

Diese Preisexplosionen sind ein Witz für das von nVidia Gebotene und in weniger als einer Handvoll gesponsorter Titel ausgfereizter Leistung dann, aber es gibt genügend Leute die das nicht kratzen wird und die weiterhin "treudoof" bei nVidia die Grafikkarte kaufen und deren (Preis-)Monopol stützen werden, auch wenn mit Blackwell die 70er Serie (wie unter Ada Lovelace schon die 60er Serie) dann erstmalig zur Chip-Resterampe werden dürfte.

- Registriert

- Juli 2021

- Beiträge

- 3.187

Ach, daran muss man sich gewöhnen. Aber auf der anderen Seite: So ein bisschen Beef ist gut. Wäre ja langweilig, wenn man immer nur das macht, was alle gut finden.MoinWoll schrieb:Ergebnis des Tests: Die AMD-Karte ist signifikant besser gealtert als die NVIDIA-Karte = AMD-Bashing.

Every bodies darling, is not bodies friend.

Ist auch so nicht ganz richtig. Ich habe es aber korrigiert, weil hier das "mehr" falsch war. Es sind jetzt eben 26 Prozent weniger als damals, die Vega ist aber nicht 26 schneller als damals.MoinWoll schrieb:Zum Fazit eine Korrekturanmerkung: Pascal war 31% und ist jetzt 23% voraus, daher wäre m. E. "Vega lag im Mittel 24 Prozent [(1-1/1,31)*100%] zurück [...] aktuell liegt der Rückstand nur noch bei 19 Prozent [(1-1/1,23)*100%]" korrekt

Ich weiß, worauf du hinaus möchtest und kann dir in bestimmten Punkten durchaus zustimmen, wobei das aber in dem Fall auf die Sichtweise ankommt. Deine Kritik würde ich bei einer wissenschaftlichen Arbeit oder Artikel, der auf einer der Fachseiten für Informatik veröffentlicht wird, gelten lassen - auch da kann man über Punkte streiten.CyrionX schrieb:auf Metaebene die Performance betrachten will, eine harte Kritik an die Statistik in diesem Artikel

Hier in dem Fall allerdings nicht, weil es sich überwiegend an die Leser richtet und die Fragen des Artikekls benannt werden: Wie gut schneidet Vega und Pascal bei modernen Spielen ab. Der Artikel macht in diesem Zusammenhang genau das, was viele Leser machen: Man sieht sich die Zahlen von 2017 und 2018 an und nimmt dann die Zahlen von heute und setzt diese in Relation. Diese Arbeit hab ich den Lesern in diesem Fall abgenommen und die Werte gleich aufbereitet.

Und natürlich ist es statistisch sauber - du erwähnst es bereits - auch auf Metaebene entsprechende Zahlen zu liefern und auch das wird in der Wissenschaft Tag täglich gemacht:

"Test A, Gruppe A schließt 31 % besser ab." "Test B, Gruppe A schließt 23 % besser ab" ⇾ Der Rückstand von Gruppe B hat sich um 26 % verringert.

Und nichts anderes passiert an dieser Stelle. Zudem solltest du dir überlegen, wie du die "Kritik" versuchst zu untermauern, auf diese Weise funktioniert es nicht:

Nein, genau diese Aussage wurde hier nämlich nicht getroffen und damit schadest du deiner eigenen Kritik, der man in Punkten zustimmen könnte - auch wenn man darüber vortrefflich streiten könnte, da es auf den Standpunkt ankommt, weil du absichtlich ein vollkommen falschen Schluss am Ende ziehst.CyrionX schrieb:Was hier gerechnet wurde war in etwa nämlich folgendes: ein Buggy der zwischen Dschungel und Wüste durchschn. 30kmh schneller fuhr als sonst, fährt zwischen Steppe und Stadt durchschn. 45kmh schneller als üblich. Damit hat der Buggy 50% mehr PS hinzubekommen.

Dass du von km/h nun direkt auf PS gehst, disqualifiziert dein Beispiel und ehrlich gesagt disqualifiziert es in weiten Teilen auch deine Kritik, weil du hier ein vollkommen falsches Beispiel anbringst und damit eine Aussage unterstellst, die nicht getroffen wurde.

Es wird hier angeben, dass der Rückstand zwischen den Testparcours durch Vega verringert wurde.

Auta A fährt in Dchungel 50 km/h in der Wüste 45 km/h, während Auto B im Dschungel 40 km/h fährt und in der Wüste 38 km/h.

Einmal ist Auto A 20 % schneller und das zweite mal 15 %. Auto B konnte damit den Rückstand in der Wüste um 25 % verringern.

Und genau das wird hier gemacht.

W

w0wka

Gast

Habe meiner Nichte im Dezember eine 1080 non ti eingebaut damit sie Sims 4 spielen kann. Für das Spiel in Fhd reicht es grad noch aus.

- Registriert

- Mai 2011

- Beiträge

- 21.563

Speziell zum "durstig sein", ne 3080 brauchte 320W, ne 6800XT brauchte 300W, das sind ~7% mehr.SweetOhm schrieb:Exklusivmeinung ?!? Zu spät kam Vega !! Waren auf Augenhöhe (FPS, siehe Anhang #173), günstiger (FPS/€),

sehr durstig (Watt). Das war Ampere allerdings auch, nur da hat´s auf einmal niemanden mehr gejuckt ...

Hier mal die Leistungsaufnahme der Vega64 vs der gleich schnellen 1080FE

300W vs 157W, das sind ja nur schlappe 91% mehr.

natürlich jucken 7% mehr Leistungsaufnahme nicht so viel wie 91% mehr. Zumal Ampere auch nur in Raster-Titeln ineffizienter war.

- Registriert

- Juli 2021

- Beiträge

- 3.187

Die Effizienz wollen wir doch galant mal unter den Tisch fallen lassen. ☺️Taxxor schrieb:natürlich jucken 7% mehr Leistungsaufnahme nicht so viel wie 91% mehr. Zumal Ampere auch nur in Raster-Titeln ineffizienter war.

Meine extrem laute AMD Hawaii Karte konnte ich zum Neupreis gebraucht verkaufen und bin so aufs Mining aufmerksam geworden. Die Vega Karten waren damals schwer zu bekommen und haben sich guts fürs Mining geeignet. Soweit ich weiß habe nie mit solchen Karten gezockt, sondern gleich damit Ethereum geschaufelt. Das hat sich damals nicht gelohnt, war aber auch kein Verlust, für mich ohnehin nicht. Bin dann allerdings schnell auf die Pascal Karten umgestiegen( einfacher, mehr Softwareauswahl) , die mir bis zum Merge unfassbar viel Kohle gemacht haben. Damals waren die Preise auch schon verrückt und man musste UVP bezahlen, knapp über 300€ für die 1060 6GB (bestes Custom Modell) und 800€ für die 1080TI. AMD hat damals den Mining Zug verpasst, die Karten hatten extremes Potentential, aber Nvidia hat letztlich den Elfmeter mitgenommen.

pseudopseudonym

Fleet Admiral

- Registriert

- Mai 2017

- Beiträge

- 10.177

F1 22 ist das neuste, Multiplayer. Natürlich mit runtergeschraubten Settings, aber eben mit deutlich mehr als FHD.0x8100 schrieb:aber sicherlich nicht in spielen, die über solitaire hinaus gehen

Flyerdommo

Lieutenant

- Registriert

- Jan. 2017

- Beiträge

- 681

Die GTX 1080Ti war wirklich eine hervorragende Grafikkarte, die ich bis letztes Jahr im Rechner hatte. Mittlerweile ist mir klar geworden, dass ich für meine Anwendungsszenarios die mittlerweile im Rechner verbaute RTX 4080 FE gar nicht wirklich brauche. Eine RTX 4070 Super hätte völlig ausgereicht. Möglicherweise ändert sich das allerdings bei Erscheinen des MSFS 2024.

Schinken42

Commander

- Registriert

- März 2021

- Beiträge

- 2.608

Ist doch Quark. Cyberpunk, Metro Exodus und Watchdogs Legion sind keine Beispiele, sondern waren ein, zwei Jahre die einzig nennenswerten Spiele mit RT.MoinWoll schrieb:Zum bzw. kurz nach dem Start von Ampere gab es schon einiges, z. B. Cyberpunk, Metro Exodus und Watchdogs Legion. Und da die meisten Leute sich Grafikkarten für 4-8 Jahre Nutzungszeit kaufen, wird auf die möglichst gute Unterstützung von halbwegs neuen Grafikfeatures eben Wert gelegt.

(...)

Und mit welcher Karte kann man RT bitte nach 4-8 Jahren noch nutzen? Auf der 2080ti kann man in neuesten RT Spielen kaum mal wirklich RT einschalten. Immerhin geht's mit der aberanchmal noch, mit allem darunter kann man das vergessen. Gerade der Hunger nach RT Leistung wächst doch immer mehr.

vinacis_vivids

Ensign

- Registriert

- Juli 2004

- Beiträge

- 134

Vega 64 kann 4:4:4 10bit pro Kanal HDR Rendering ohne Leistungsverluste. Bitte die Messwerte von CB hier nicht ernst nehmen. Die wurden wieder wie bei PCGH mit 8bit 4:2:2 durchgeführt, also in minderwertiger Qualität um Nvidia gut dastehen zu lassen.

Mir ist die Grafikkarte am Wochenende abgeraucht und zur Überbrückung bis zur 5000er Serie habe ich mir eine gebrauchte GTX 970 für 30€ gekauft. Karte ist top. Klar, es geht nur Full HD und es sollten nicht die neusten Games sein, aber mit der Karte kommt man noch überraschend gut "über die Runden"