DevPandi schrieb:

An der Titelauswahl kann man immer etwas machen und auch in dem Fall ist die Auswahl auch nur ein "kleines" Fenster.

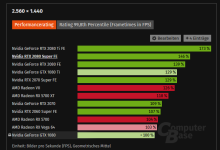

Das Ding ist halt, wenn du Titel wählst, wo unspielbar niedrige FPS Raten raus kommen, dann spielt das einer Vega GPU in der Form zumindest pauschal in die Karten, dass die Last auch in aller Regel entsprechend hoch ausfällt.

Natürlich kann man über die Titelauswahl streiten - wenn allerdings zumindest durch Titel, wo keine 20 FPS in der Messung stehen, dann Fragezeichen über bleiben, wie aussagekräftig sowas ist? Dann ist das doch eher ungünstig gewählt?

-> wenn du darauf dann "

Unterschiede zwischen Vega, Pascal und Turing heraus arbeiten" möchtest, kommt am Ende aber nur raus, das die Last so hoch ist, dass Vega sehr gut skaliert - was ist ja hinlänglich bekannt, dass die GPUs besser abschneiden um so mehr Last man da drauf legt. Aber was bringt die Erkenntnis in der Praxis? Bei niedrigerer Last (Auflösung runter, Details runter, weniger AA, ...) würde Vega womöglich ähnlich den damaligen Titeln/Benches weniger der Rohleistung auf die Straße bringen, während Pascal bzw. Turing das tut. Ich denke das ist ein valider Punkt zu kritisieren.

DevPandi schrieb:

Ich hätte die Auswahl auch so treffen können, dass Vega noch stärker dasteht und noch näher an der 1080 Ti ist und an manchen auch überholt und umgekehrt. Ich nehm aber gerne auch mal Wünsche für die Zukunft mit.

Dagegen ist man ja nie geschützt - pauschal wären um so mehr um so besser. Weil damit Ausreißer unter gehen und Cherry Picking im Schnitt verschwindet. Was ja im Endeffekt das ist, was so ein Baseline Test dann auch sein möchte. Nämlich in der Basis vergleichbar zu sein. -> da wo du die Prozente zu relativen Zuwächsen ansetzt.

DevPandi schrieb:

Das geht so in dem Fall besser.

Wie gesagt, bedingt, weil die Last halt so hoch ist, dass es zumindest Fragezeichen über lässt, ob man sowas real praktisch überhaupt erreichen kann.

Auch FSR ist da ein gutes Beispiel. FSR, je nach dem, welches, wird ja bei der Messung, wo keine 20 FPS stehen, nicht auf einmal 60+ FPS hinzaubern.

-> Tendentiel sinkt die Leistungsskalierung der GPUs etwas, wenn man mit der Renderauflösung runter geht. Alte GPUs haben das Verhalten analog. Nur ist dort die Schwelle wo das wirklich stark nachlässt mit der Leistungsskalierung einfach viel niedriger als bei aktuellen GPUs.

DevPandi schrieb:

Ich werde aber mal sicher auch einen Test machen, bei dem es dann um die Spielbarkeit geht. Versprochen!

Kannst du ja direkt in einen Skalierungszusammenhang stellen mit den GPUs jetzt hier? Bzw. den Ergebnissen?

Dann räumt man da auch direkt mit Orakeln auf. Auch nett sind bei sowas immer Frameverlaufsdiagramme. Also ein Diagramm mit den Frametimes übereinander (anstatt den FPS Wert als Balken) -> weil gerade zwischen NV und AMD im Vergleich kann das gut anders ausfallen.

-> wichtig ist dabei nur, diese Diagramme müssen auf die Zeit - nicht auf den Framecount! - konsolidiert werden. Sonst sind schnellere GPUs einfach schneller fertig und die Kurve ist kürzer.

DevPandi schrieb:

Den GPU-Load kann ich dir liefern, den Verbrauch wird es in Zukunft geben, wenn die Werkzeuge da sind. Ich will hier nicht nur mit den Verbräuchen aus dem Softwaremonitoring wiedergeben.

GPU Load wie auch (selbst der Software) Verbrauch liefern einen guten Indikator ob die GPU einfach nicht richtig rund läuft oder wo es klemmen könnte.

Was halt zumindest hier etwas erschwerend hinzukommt - soll natürlich keine Ausrede sein - NV hat drei vollständige Lineups nach Pascal geliefert und AMD nur zwei und ein bisschen - und diese sind auch noch vom Prinzip und Aufbau ähnlich, genau so wie AMD weiterhin die Vega Technik als solches aktuell pflegt, weil es nach wie vor aktiv vertriebene APUs mit Vega gibt.

Für NV gibt es keinerlei Gründe mehr, Pascal weiter zu supporten. Die sind drei Generationen weiter... Und mit Turing und dem RT Fokus gabs nen stärkeren Bruch bei der Technik. Ebenso ist NV als Markt Leader der, der vorgibt, wann sich neue Technik am Markt durchsetzt. Das ist für neues ein Vorteil - für alles alte aber ein Nachteil. Denn ist der Punkt überschritten, wo der alte Kram aus dem Raster fällt, dann kommt dafür auch nix mehr rum.

Pascal auf DX12 Titel zu testen ist perse irgendwie nur bedingt sinnig - weil das war nie der Entwicklungsfokus für den Kram. AMD hat mit Hawaii ja Mantle gebracht, was am Ende in Vulcan aufgegangen ist, weil sie unter DX11 anders als NV ihre Leistung nicht auf die Straße bekommen haben. Ist ja logisch, dass damit die Lücke schwindet bis sich umkehrt, wenn man jetzt voll auf Lower Level APIs geht. Jetzt wo das Zeug auch verfügbar ist - was früher halt nicht der Fall war. Da kann man AMD weitsicht nachsagen - durchaus möglich, wird ja in den Foren auch gern getan. Andererseits könnte man ihen aber auch einfach unfähigkeit nachsagen, weil sie das zur damaligen Zeit notwendige nicht anständig abliefern konnten. Sie hatten mit Hardware auf ein Problem geschossen (im Kompromuss durch mehr Rohleistung, mehr Verbrauch und schlechtere Effizienz) -> natürlich lebt das hintenraus einfach länger. Aber wer hat was davon? -> bei unter 20 FPS wahrscheinlich Niemand.