@VaniKa ich hatte auch bereits die Vermutung das der Slider auf 0 eine Feste Nitwert irgentwo zwischen 100 und 150 nit hat,

Wärend 100% wahrscheinlich 2 fach diesen wert entspricht..

Sprich du erhöchst ja um 100%

sagen wir es sind 100Nits (hypothetisch) dann würde der Slider auf 100% wahrscheinlich 200Nits entsprechen. (eine erhöhung um 100%)

Das Problem ist halt das viele LCD Monitore auf höhere Nitwerte Kalibriert sind.. ich zb muss auf 100% gehen was irgentwo zwischen 200 und 300 Nits sein müsste.. auch gehen viele LCDs nicht wirklich Tiefer von der helligkeit weil dann der Kontrast ( IPS PANEL) total abkackt

Was windows eigentlich fehlt ist das man anstatt des Sliders einen Festen wert eingibt für die genaue SDR Nit helligkeit.. und zwar von 100-400 Nits

Beim OLed ist das wieder anders.. der hat ja keine Probleme mit der Helligkeit soweit runter zu gehen, geschweige denn das der wahrscheinlich sowieso irgentwo bei 100-200 Nits kalibriert ist aufgrund der Fullframe helligkeit und dabei in der Lage ist den Kontrast zu bewahren.

Ich gehe auch davon aus das diese Helligkeit fest hinterlegt ist und den SMPTE ST-2084 Perceptual Quantizer (PQ).. Also die Punktgenaue Helligkeitssteuerung von HDR anspricht.

Möglich das Statistisches oder Dynamisches Tonemapping einen unterschied macht.. aber wenn nur Minimal

übrigens hat Dolby Vision einen weiteren Vorteil laut Wikipedia

es benutz als einzige HDR Klasse die Dynamischen Metadaten SMPTE ST 2094-10

.... ist in der Lage, dynamische Metadaten an das Ausgabegerät zu übertragen. Diese können beispielsweise Farbkalibrierungen abhängig von der Szene enthalten, was eine originaltreuere Wiedergabe zur Folge hat..

die anderen HDR standarts (HDR10/HDR10+) können das wiederrum nicht!

Sprich wenn ein Bild zb im SRGB getaggt ist versucht dolby vision es originalgetreu in SRGB farbraum einzubinden

...Die Dolby-Vision-Metadaten SMPTE ST 2094-10 werden in einem HLG-Signal mitgeliefert und sind zudem abwärtskompatibel zum Standard HDR der HLG-Spezifikation...

Sprich Dolby Vision (bzw die Metadaten 2094-10 auf denen Dolby aufbaut) ist dadurch als einziger Standart Abwärtskompatibel zu HDR/HDR10/HDR10+ und in der lage content im Original Farbraum darzustellen

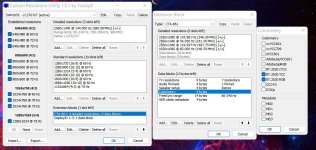

Ich habe bei mir mittlerweile nur noch die Dynamischen Metadaten 2094-10 aktiviert und alles andere bei CRU gelöscht, und das Bild sieht 1 zu 1 aus wie SDR auf dem Desktop. ich hab das ganze sogar mit diversen Kalibrierungsseiten grob gegen gecheckt. es ist für mich auch das Optisch beste Bild mit tiefen Schwarz und schönen hellen highlights in Film und Spiel.

Theoretisch habe ich damit Dolby Vision global erzwungen auser das mein Monitor natürlich keine zertifizierung dafür hat