Legalev schrieb:

Wieviel Kohle hat AMD und wieviel Nvidia?

Irrelevant an der Stelle. AMDs Problem ist Geld "heute" nur noch bedingt, das galt von 2011 bis 2019.

Interessant ist aber, dass AMD in der Zeit 2011 - 2017 bei Grafikkarten wesentlich mutiger war, was Technologie anging. Ich sage nur Primitive Shaders, Compute-Shaders und Co. Das sind alles Technologien, die AMD als erstes entwickelt hat. Primitive Shaders scheiterten leider, sind aber der Grundstein für die Mesh-Shader, Compute-Shaders sind heute allgegenwärtig.

5hred schrieb:

Da muss AMD mit deutlich weniger Geldmitteln irgendwie mit genialen Ideen dagegenwirken...

Nur das AMD genau das bedauerlicherweise verloren hat. Bis Vega hat man versucht, mit neuen Ideen gegen Nvidia anzukommen, hat sich aber oft entweder die Pfoten verbrannt oder später kam die Technik wurde aber durch "MS" noch mal so angepasst, dass die ursprüngliche Implementierung für die Tonne war.

TruForm als frühes Tesselation, wurde von ATi dann für DirectX 10 angepasst, dann fliegt Tesselation aus DirectX 10 und kommt erst mit 11 noch verändert.

FireStream wird 2006 für HPC vorgestellt, auch die Close-to-Metal-API dafür - X1900 XTX war quasi die erste "HPC"-Karte. Nvidia kommt mit CUDA erst später (hat aber das durchdachtere System und auch den Willen das effektiv durchzuziehen)

Compute Shaders gehen auf Mantle zurück, ebenso die Asynchronen Shader, Nvidia hatte quasi bis Turing damit Probleme, hat die Technik dahinter aber auch nur "kopiert".

Primitive Shaders als erste Iteration der Mesh-Shader - ja die waren kaputt.

DirectStorage ist euch eine Technik, die mit MS für XBox Series entwickelt wurde und als Antwort auf Sony gedacht war.

ATi und später auch AMD waren bis Vega darum bemüht, die Grafik wirklich voranzubringen. Das ist mit RDNA leider verloren gegangen.

bad_sign schrieb:

AMD hat genug Geld, aber ihr Schwerpunkt sind CPU/Server, APUs (auch im HPC/AI Kontext)

AMD hat aktuell hier den Mut verloren bei Radeon, das finde ich persönlich schade. Ich kann es aber verstehen. ATi und auch AMD haben viel Forschung betrieben, am Ende hat aber sowohl der Markt als ganzes als auch Mircosoft gerne mal den Mittelfinger gezeigt und die Ideen übernommen, die Spezifikationen und technischen Details aber so angepasst, dass ATi/AMD aus ihrer Arbeit keinen Profit schlagen konnten.

MrHeisenberg schrieb:

Und wieder ne Nvidia-Technologie kopiert.

Wollen wir mal all die Technologien aufzählen, die Nvidia von ATi und AMD kopiert hat in den Jahren 2000 - 2018? Darunter ist sowas Wichtiges wie CUDA, dass heute die Marktmacht von Nvidia ausmacht. Auch Compute- als auch Asynchrone-Shader sind Techniken, die AMD seit GCN 1.0 verfolgt und Mantel, die Nvidia kopiert hat und erst als Nvidia es mit Turing wirklich unterstützt, Erfolg feiert. Wie wäre es mit der Idee hinter den Mesh-Shader, die Mircosoft in Zusammenarbeit mit Nvidia von AMD kopiert hat für DirectX 12 Ultimate.

Wir können mal an der Stelle weiter gehen: Selbst Nvidias RT-Ansatz ist nichts weiter als eine Kopie. Da war

Caustic Graphics vorher da, Imagination Technologies haben die sich geschnappt und entsprechende Papers da auch veröffentlicht, die stark nach dem Aussehen, was Nvidia später bei Turing vorstellten.

Oder wie wäre es mit den Tensor-Kernen, da stellte Google die ersten Produkte auch 2015 vor, Nvidia kam da erst 2017 mit Volta.

Wir können ja auch mal auf den Patentstreit zwischen 3dfx und Nvidia verweisen, da hat Nvidia die Schlacht verloren, den Krieg aber gewonnen, da wurde Nvidia allerdings nachgewiesen, dass sie hier Patente von 3dfx verletzt haben.

Selbst die Techniken, die man halbwegs auf Nvidia zurückführen können, sind quasi Kopien, weil entsprechende Ideen bereits in Standards vorhanden waren, nur nicht genutzt wurden. Die Basis für Adaptiv-Sync war bereits vor G-Sync vorhanden, nur eben im eDP-Standard für Notebooks, damit die Grafikkarten dort die Bildwiederholrate dynamisch zum Stromsparen anpassen kann. Im eDP-Standard ist Adaptiv-Sync seit 2009. G-Sync kam mit Kepler auf dem Markt, das war 2012, also 3 Jahre nachdem das Ganze in einen offiziellen Standard eingezogen ist. Entsprechend schnell konnte AMD ja auch reagieren, in dem man einfach den Standard nimmt.

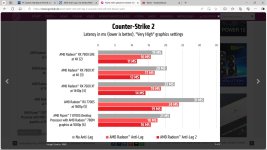

Und das mit Nvidia Reflex ist auch so ein Ding, denn eine wirkliche Nvidia-Technik ist das auch nicht, sondern im Endeffekt auch nur eine "einfachere" Möglichkeit all die Stellschrauben anzuziehen, die in den verschiedenen APIs von Windows schlummern, damit die Eingabelatenz sinkt, und was zum Teil auch in entsprechenden Guides beschrieben wird.

Entschuldige, aber was "kopieren" von Technologien angeht, ist Nvidia immer ganz vorne dabei, nur wird das gerne durch das verdammt gute Marketing von Nvidia durch die meisten vergessen.

All das ändert aber auch nichts daran, dass Nvidia verdammt gute Arbeit abliefert und vieles auch oft weit durchdachter und reifer wirkt, als bei anderen, was ja auch dazu führt, dass solche Lösungen wie G-Sync am Anfang deutlich besser funktionieren. Genauso mit CUDA und Co.

Nur sollte man die Vorwürfe von "AMD kopiert von Nvidia" lieber außen vor lassen, das heizt nur sinnlos die Stimmung an und ist am Ende auch weitgehend falsch. Selbst Nvidia ist, wenn man es streng nimmt, oft eine Copycat.