Apfelorange schrieb:

Danke!

HW Ausfälle können zu Datenverlust führen.

Von "nicht nur HW Ausfälle können zu Datenverlust führen" nur den Teil oben zu zitieren, finde ich schon ein wenig sinnentstellend.

Apfelorange schrieb:

durch das ständige ausdehnen und zusammenziehen das Material irgendwann kaputt geht/bricht?

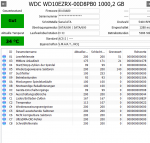

Das weiß ich nicht, glaube es aber eher weniger, es dürfte vor allem Probleme bei der Kopfpositionierung und daher die häufigere Notwendigkeit von Rekalibrierungen gehen. Die Trackdichte der Platte dürfte so etwa bei

wie bei der M8.DVR bei 365kTpI (Kilo-Tracks per Inch), also 25,4mm / 365000 = 70nm, das Trägermaterial ist laut Product Manual Glas (es gibt auch welche mit Aluminium) und der maximale Radius der Platter dürft knapp 3cm betragen. Der Längenausdehnungskoeffizient von Glas (Quarzglas) ist 0,5 *10^-6/K, die äußere Spur dürfte also pro °C Wärmeunterschied ihren Abstand zur der Achse um 1,5nm verändert, bei den 70nm pro Spur klingt das nicht viel, aber die Daten selbst sind ja nur ein Teil der Spurbreite, zwischen den Spuren gibt es auch noch Markierungen und bei 20°C Temperaturunterschied wäre der Kopf überhaupt nicht mehr korrekt positioniert. Bei Aluminium mit einem Längenausdehnungskoeffizient 23,8 wären es 35,7nm pro °C, also sehr, sehr viel bei den heutigen Datendichten.

Apfelorange schrieb:

Ich frage mich, ob es eine Rolle spielt, dass der Anschluss USB3 ist und auf der Platine am SATA-Anschluss "SATA-I" steht.

Die

ST640LM001 selbst hat ein SATA 3Gb/s Interface, der USB-SATA Bridgechip kann aber vermutlich nur SATA 1,5Gb/s, aber das sollte die Performance nicht einschränken und damit keinen Einfluss haben.

Apfelorange schrieb:

Das Schrieben von 4GB am Stück, sollte die Platte aber aushalten, oder kann das bereits zu einer zu schnellen Temperaturänderung führen?

Natürlich führt das zu Temperaturänderungen, die Köpfe arbeiten bei der ja auch schon im Teilkontaktbetrieb, anders wäre so eine Kapazität nicht machbar.

Apfelorange schrieb:

Vielleicht immer nach dem Einschalten und vor dem Ausschalten und zwischen den Schriebvorgängen etwas ruhen lassen?

Das kann nicht schaden, ja nachdem wie warm sie vorher ist und wie warm sie dann hinterher bei den Schreibvorgängen wird, Auch für die M8 sind ja 20°C pro Stunden als maximal Temperaturänderung angegeben.

Apfelorange schrieb:

abgesehen von einer Crucial m4 SSD, die von ein aufs andere Mal nicht mehr lesbar war und auf Garantie getauscht werden konnte

Sowas kann gerade bei einer SSD zwar immer passieren, aber könnte es der 5184 Stunden Bug der m4 gewesen sein?