Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Test: Trinity vs. Ivy Bridge im CPU-Test

- Ersteller Volker

- Erstellt am

- Zum Artikel: Test: Trinity vs. Ivy Bridge im CPU-Test

MountWalker

Fleet Admiral

- Registriert

- Juni 2004

- Beiträge

- 13.997

Da hättest du aber unsinnig gedacht. Drei Gründe:Herdware schrieb:...

Ich hätte gedacht, dass die integrierte GPU automatisch deaktiviert wird, wenn eine dedizierte Grafikkarte eingebaut wird.

...

1. Die GPU sollte, egal wie viele Grafikkarten im PC stecken, für GPGPU verfügbar bleiben.

2. Auf Mac- und Windows-Notebooks kann im laufenden Betrieb umgeschaltet werden, welche Grafikkarte zur Berechnung der Grafik verwendet wird - für die reine Desktop-Darstellung sollte die dedizierte Grafikkarte eben in den Schlafmodus gehen.

3. Wenn auch der Sinn streitbar ist, AMD bietet Crossfire mit unterschiedlich starken Grafikkarten an, dabei rechnet die dedizierte Karte in der Zeit, die die APU für ein Frame braucht, eben an drei Frames.

Herdware

Fleet Admiral

- Registriert

- Okt. 2011

- Beiträge

- 17.898

@ Casi030

Eigentlich ist es ja auch vernünftig, bei einer APU die integrierte GPU zu nutzen und nicht extra eine dedizierte Karte dazu zu kaufen. Das ist doch gerade der große Vorteil der APUs, dass man keine Extra-Grafikkarte braucht.

Und umgekehrt kauft man sich, wenn man doch mehr GPU-Leistung braucht als eine APU bieten kann, zu seiner Grafikkarte dann doch eher eine passende leistungsstärkere CPU. (Sei es eine von Intel oder ein FX.)

Ich habe auch nochmal etwas darüber nachgedacht und irgendwie ergibt es sogar Sinn, dass bei einer APU die integrierte GPU nicht automatisch deaktiviert wird, wenn man eine zusätzliche Grafikkarte einsteckt. AMD sieht die iGPU ja nicht nur als Spezialisten für Grafikwiedergabe, sondern sie soll von den Anwendungen auch wo immer möglich für GP-GPU, also unterstützend bei allgemeinen Berechnungen, genutzt werden.

So gesehen ist es auch sinnvoll, die GPU immer aktiviert zu lassen und die APUs auch so zu testen. Die starke integrierte GPU ist halt ein zweischneidiges Schwert, das einerseits (mit darauf optimierter Software) Vorteile bei GPU-beschleunigten Berechnungen bringen kann, aber dafür auch den Stromverbrauch erhöht.

Wobei ich es wie gesagt nicht für wahrscheinlich halte, dass die integrierte GPU besonders viel Strom braucht, wenn sie nichts zu tun hat. Wenn die dedizierte Karte alle Arbeit übernimmt, geht die iGPU in den Idle-Modus und der ist bei den Trinity-APUs sehr sparsam. Mehr als 1 oder 2 Watt dürften da nicht drin sein, zwischen Idle und per BIOS "hart" deaktiviert, wenn überhaupt.

Eigentlich ist es ja auch vernünftig, bei einer APU die integrierte GPU zu nutzen und nicht extra eine dedizierte Karte dazu zu kaufen. Das ist doch gerade der große Vorteil der APUs, dass man keine Extra-Grafikkarte braucht.

Und umgekehrt kauft man sich, wenn man doch mehr GPU-Leistung braucht als eine APU bieten kann, zu seiner Grafikkarte dann doch eher eine passende leistungsstärkere CPU. (Sei es eine von Intel oder ein FX.)

Ich habe auch nochmal etwas darüber nachgedacht und irgendwie ergibt es sogar Sinn, dass bei einer APU die integrierte GPU nicht automatisch deaktiviert wird, wenn man eine zusätzliche Grafikkarte einsteckt. AMD sieht die iGPU ja nicht nur als Spezialisten für Grafikwiedergabe, sondern sie soll von den Anwendungen auch wo immer möglich für GP-GPU, also unterstützend bei allgemeinen Berechnungen, genutzt werden.

So gesehen ist es auch sinnvoll, die GPU immer aktiviert zu lassen und die APUs auch so zu testen. Die starke integrierte GPU ist halt ein zweischneidiges Schwert, das einerseits (mit darauf optimierter Software) Vorteile bei GPU-beschleunigten Berechnungen bringen kann, aber dafür auch den Stromverbrauch erhöht.

Wobei ich es wie gesagt nicht für wahrscheinlich halte, dass die integrierte GPU besonders viel Strom braucht, wenn sie nichts zu tun hat. Wenn die dedizierte Karte alle Arbeit übernimmt, geht die iGPU in den Idle-Modus und der ist bei den Trinity-APUs sehr sparsam. Mehr als 1 oder 2 Watt dürften da nicht drin sein, zwischen Idle und per BIOS "hart" deaktiviert, wenn überhaupt.

Casi030

Banned

- Registriert

- Feb. 2007

- Beiträge

- 15.687

@Herdware : Genau so ist es.Ich hab auch nur beim Llano ne 5770 zugepackt,weil ich sie übrig hatte.Für das was die Kids Spielen rechte die APU vollkommen aus.

Der Nachteil an der Sache ist,es werden jetzt rund 12Watt im Idle für nix verballer,aber Ich konnte Basteln.

Aber wieviel die GPU verbrauch,muss ich auch mal Testen,meine hab ich in Bios auch Ausgeschaltet.

Der Nachteil an der Sache ist,es werden jetzt rund 12Watt im Idle für nix verballer,aber Ich konnte Basteln.

Aber wieviel die GPU verbrauch,muss ich auch mal Testen,meine hab ich in Bios auch Ausgeschaltet.

oldmanhunting

Admiral

- Registriert

- Nov. 2008

- Beiträge

- 9.457

Ich kann nur sagen wie es bei mir ist

Bei mir im Bios ist die Einstellung iGPU/GPU auf Auto. Beide Monitore hängen an der Grafikkarte.

So eingestellt gibt es im Gerätemanager nur die Grafikkarte. Die iGPU erscheint dort nicht.

Ich habe es getestet und meine iGPU ist aus.

Ich habe im Bios einen Eintrag der heißt iGPU Multi Monitor. Da steht in der Beschreibung, das man den mit Lucid Virtu aktivieren soll.

Fakt ist, dass wenn dieser Eintrag aktiviert ist, dann ist auch die iGPU zusammen mit der Grafikkarte aktiv (auch ohne Lucid Virtu) und die Monitor Ausgänge am MB funktionieren auch.

Das war praktisch mit meiner HD6850, weil die mit 2 Monitoren in den 3D Modus geschaltet hat und direkt einmal 40W-50W mehr verbraucht hat. Da hatte ich den 2. Monitor an der iGPU.

Jetzt mit der HD7770 bleibt die Karte auch mit 2 Monitoren im 2D Modus und die iGPU bleibt aus.

Nur mal so für interessierte:

Die HD7770 braucht in Internet/Office/2 Monitore gerade einmal 3-5W mehr als die iGPU.

Bei mir im Bios ist die Einstellung iGPU/GPU auf Auto. Beide Monitore hängen an der Grafikkarte.

So eingestellt gibt es im Gerätemanager nur die Grafikkarte. Die iGPU erscheint dort nicht.

Ich habe es getestet und meine iGPU ist aus.

Ich habe im Bios einen Eintrag der heißt iGPU Multi Monitor. Da steht in der Beschreibung, das man den mit Lucid Virtu aktivieren soll.

Fakt ist, dass wenn dieser Eintrag aktiviert ist, dann ist auch die iGPU zusammen mit der Grafikkarte aktiv (auch ohne Lucid Virtu) und die Monitor Ausgänge am MB funktionieren auch.

Das war praktisch mit meiner HD6850, weil die mit 2 Monitoren in den 3D Modus geschaltet hat und direkt einmal 40W-50W mehr verbraucht hat. Da hatte ich den 2. Monitor an der iGPU.

Jetzt mit der HD7770 bleibt die Karte auch mit 2 Monitoren im 2D Modus und die iGPU bleibt aus.

Nur mal so für interessierte:

Die HD7770 braucht in Internet/Office/2 Monitore gerade einmal 3-5W mehr als die iGPU.

CD

Rear Admiral

- Registriert

- Mai 2010

- Beiträge

- 5.733

Ja mit dem letzten Treiber hat sich da einiges getan. An meiner 7970 hängen drei Bildschirme und die Grafikkarte hat immer nur auf 500 MHz GPU runtergetaktet und den VRAM auf max laufen lassen. Seit 12.8 taktet sie selbst mit der kompletten Eyefinity-Gruppe auf 150/300 runter (inkl nochmal weniger VCore im Leerlauf). Es hieß ja irgendwie immer, dass es bei mehreren Bildschirmen durch das Runtertakten des VRAMs zu Bildflackern kommen würde, aber offenbar ist dem nicht so, und es hat sich endlich mal jemand angestrengt und den Treiber in der Hinsicht ordentlich geschrieben.

stone1978

Ensign

- Registriert

- Juni 2003

- Beiträge

- 135

Ich kann im BIOS einstellen AUTO - ON - OFF ....

Hänge ich eine zweite Grafikkarte rein und ich wähnle Auto werden die MHz "aktiv" angezeigt. Gehe ich auf OFF kann man diesen Wert nicht mehr ändern da dieser deaktiviert wurde samt Grafikkarte. Also ich gehe davon aus dass sie hier schon was tut.

Ob leerlauf

Standby

etc. es ist mit Sicherheit nicht der Status "deaktiviert" der mir bei diesem Test schon gefallen hätte.

Das ändert natürlich nichts dass die AMD APU mehr Strom braucht dies liegt in erster Linie am Fertigungsprozess in weiterer Folge am Design und der Strategie mit mehr MHz zu fahren (man denke an der Vergleich Athlon 64 vs Pentium 4 - SC)

Mich würde es seitens von Computerbase interessieren ob sie diese Möglichkeit in Betracht gezogen haben und ob diese Werte dann korrekt sind.

Wieviel % der User das nutzt ist reine Spekulation kann nie beantwortet werden.

Über den Sinn von einer Crossfireerweiterung ebenfalls.

Mir gehts es darum ob die Basisaussage für diese 13 Seiten Diskussion im Forum korrekt ist indem der Test auch korrekt durchgeführt wurde.

Denn die interne Grafikkarte von zB einem I3 braucht natürlich deutlich weniger eh klar mit der kann man gerade mal Solidär ruckelfrei spielen

Von dem her würde mich interessieren wo ich das hinterfragen kann oder ihr Kontaktdaten kennt ich würde mir das schon antun dies genauer zu hinterfragen.

lg Stone

Hänge ich eine zweite Grafikkarte rein und ich wähnle Auto werden die MHz "aktiv" angezeigt. Gehe ich auf OFF kann man diesen Wert nicht mehr ändern da dieser deaktiviert wurde samt Grafikkarte. Also ich gehe davon aus dass sie hier schon was tut.

Ob leerlauf

Standby

etc. es ist mit Sicherheit nicht der Status "deaktiviert" der mir bei diesem Test schon gefallen hätte.

Das ändert natürlich nichts dass die AMD APU mehr Strom braucht dies liegt in erster Linie am Fertigungsprozess in weiterer Folge am Design und der Strategie mit mehr MHz zu fahren (man denke an der Vergleich Athlon 64 vs Pentium 4 - SC)

Mich würde es seitens von Computerbase interessieren ob sie diese Möglichkeit in Betracht gezogen haben und ob diese Werte dann korrekt sind.

Wieviel % der User das nutzt ist reine Spekulation kann nie beantwortet werden.

Über den Sinn von einer Crossfireerweiterung ebenfalls.

Mir gehts es darum ob die Basisaussage für diese 13 Seiten Diskussion im Forum korrekt ist indem der Test auch korrekt durchgeführt wurde.

Denn die interne Grafikkarte von zB einem I3 braucht natürlich deutlich weniger eh klar mit der kann man gerade mal Solidär ruckelfrei spielen

Von dem her würde mich interessieren wo ich das hinterfragen kann oder ihr Kontaktdaten kennt ich würde mir das schon antun dies genauer zu hinterfragen.

lg Stone

CD

Rear Admiral

- Registriert

- Mai 2010

- Beiträge

- 5.733

Es würde auch nicht überraschen, dass die IGP über eine Abschaltung verfügt wenn sie nichts berechnen muss (weil zb kein Bildschirm angeschlossen ist). Selbst die dicken 79XX brauchen mit Zero Power im absoluten Leerlauf fast nix mehr, da lässt sich ne IGP denke ich auf die gleiche Art einfach dynamisch im Betrieb abschalten wenn sie nicht gebraucht wird.

stone1978

Ensign

- Registriert

- Juni 2003

- Beiträge

- 135

OK hab ihn angeschrieben mal schaun ob er sich meldet.

Werde noch 2 von meinen Kollegen eine Testaufgabe geben wenn sie die neuen CPU's habe. Die haben nämlich andere Boards als ich.

Sicher ist sicher.

Von der Logik her hätte ich gesagt normal muss er sicher selbst ausschalten korrekt.

Werde noch 2 von meinen Kollegen eine Testaufgabe geben wenn sie die neuen CPU's habe. Die haben nämlich andere Boards als ich.

Sicher ist sicher.

Von der Logik her hätte ich gesagt normal muss er sicher selbst ausschalten korrekt.

maschine

Ensign

- Registriert

- Juli 2008

- Beiträge

- 217

Es wird echt mal wieder Zeit, dass AMD an Land gewinnt.

Keine Konkurrenz schadet nur dem Endkunden. Das wird klar, wenn man sich die Preisentwicklung vom konkurrenzlosen 3570K so anschaut

http://geizhals.at/de/?phist=761856&age=9999

Der Preis ist nach dem üblichen Sprung kurz nach Einführung gleich geblieben. der leichte Nachlass der letzten Wochen ist eher auf den stärkeren Euro zurückzuführen...

Keine Konkurrenz schadet nur dem Endkunden. Das wird klar, wenn man sich die Preisentwicklung vom konkurrenzlosen 3570K so anschaut

http://geizhals.at/de/?phist=761856&age=9999

Der Preis ist nach dem üblichen Sprung kurz nach Einführung gleich geblieben. der leichte Nachlass der letzten Wochen ist eher auf den stärkeren Euro zurückzuführen...

stone1978

Ensign

- Registriert

- Juni 2003

- Beiträge

- 135

http://www.tomshardware.de/a10-5800k-trinity-efficiency,testberichte-241122.html

Ich würde euch bitten diesen Test mal anzuschauen das ist ebenfalls aktuell.

BItte nicht nur das FAZIT sondern wirklich Seite für Seite .... Ich schließe mich der Meinung von TomsHardware an in Summe gesehen ist der Trinity im Vergleich zum i3 Ivy als APU einfach besser.

Da kann man jetzt mit dem Finger auf den Stromverbrauch zeigen. Man kann auch Tests rausholen wo er alt ausschaut aber in Summe gewinnt er durch das bessere P/L Verhältnis. Das kann er natürlich der starken GPU verdanken keine Frage aber das ist halt mal Fakt.

Dafür hat AMD in anderen Bereichen wenn ich mir jene OHNE Grafikkarte anschaue die somit ein ganz anderes Publikum ansprechen eh wenig zu lachen.

Aber der A10 in der Topausführung ist eine gelungene APU.

Wichtig für AMD wäre es endlich den Rückstand im Fertigungsprozess aufzuholen.

lg Stone

Ich würde euch bitten diesen Test mal anzuschauen das ist ebenfalls aktuell.

BItte nicht nur das FAZIT sondern wirklich Seite für Seite .... Ich schließe mich der Meinung von TomsHardware an in Summe gesehen ist der Trinity im Vergleich zum i3 Ivy als APU einfach besser.

Da kann man jetzt mit dem Finger auf den Stromverbrauch zeigen. Man kann auch Tests rausholen wo er alt ausschaut aber in Summe gewinnt er durch das bessere P/L Verhältnis. Das kann er natürlich der starken GPU verdanken keine Frage aber das ist halt mal Fakt.

Dafür hat AMD in anderen Bereichen wenn ich mir jene OHNE Grafikkarte anschaue die somit ein ganz anderes Publikum ansprechen eh wenig zu lachen.

Aber der A10 in der Topausführung ist eine gelungene APU.

Wichtig für AMD wäre es endlich den Rückstand im Fertigungsprozess aufzuholen.

lg Stone

Lübke

Fleet Admiral

- Registriert

- Aug. 2007

- Beiträge

- 21.162

Klar, der Stromverbrauch ist kompletter Bockmist und ich verstehe nicht warum AMD nicht endlich auf 22nm umstellt.

der stromverbrauch ist unter berücksichtigung der hd7550d gar nicht so schlecht. klar wäre der bei 22nm besser, nur wer kann denn in 22nm fertigen? nur intel. und was glaubst du, werden die amd erzählen, wenn die da auch fertigen lassen wollen um intel besser konkurrenz machen zu können?

Lübke

Fleet Admiral

- Registriert

- Aug. 2007

- Beiträge

- 21.162

wäre auch ne möglichkeit^^

aber ob amd überhaupt bei intel fertigen wollen würde? is ja nich so, dass sie intel dann technische details verheimlichen könnten...

vor allem der "bauplan" der hd7660 dürfte bei intel auf großes interesse stoßen

nee, also auf dem gebiet der fertigung hat intel schon nen ganz dicken vorsprung. kombiniert mit der hervoragenden ivy-architektur... da müsste amd schon ne wunderarchitekur bringen, um das wett zu machen.

aber ob amd überhaupt bei intel fertigen wollen würde? is ja nich so, dass sie intel dann technische details verheimlichen könnten...

vor allem der "bauplan" der hd7660 dürfte bei intel auf großes interesse stoßen

nee, also auf dem gebiet der fertigung hat intel schon nen ganz dicken vorsprung. kombiniert mit der hervoragenden ivy-architektur... da müsste amd schon ne wunderarchitekur bringen, um das wett zu machen.

pipip

Fleet Admiral

- Registriert

- Jan. 2011

- Beiträge

- 11.411

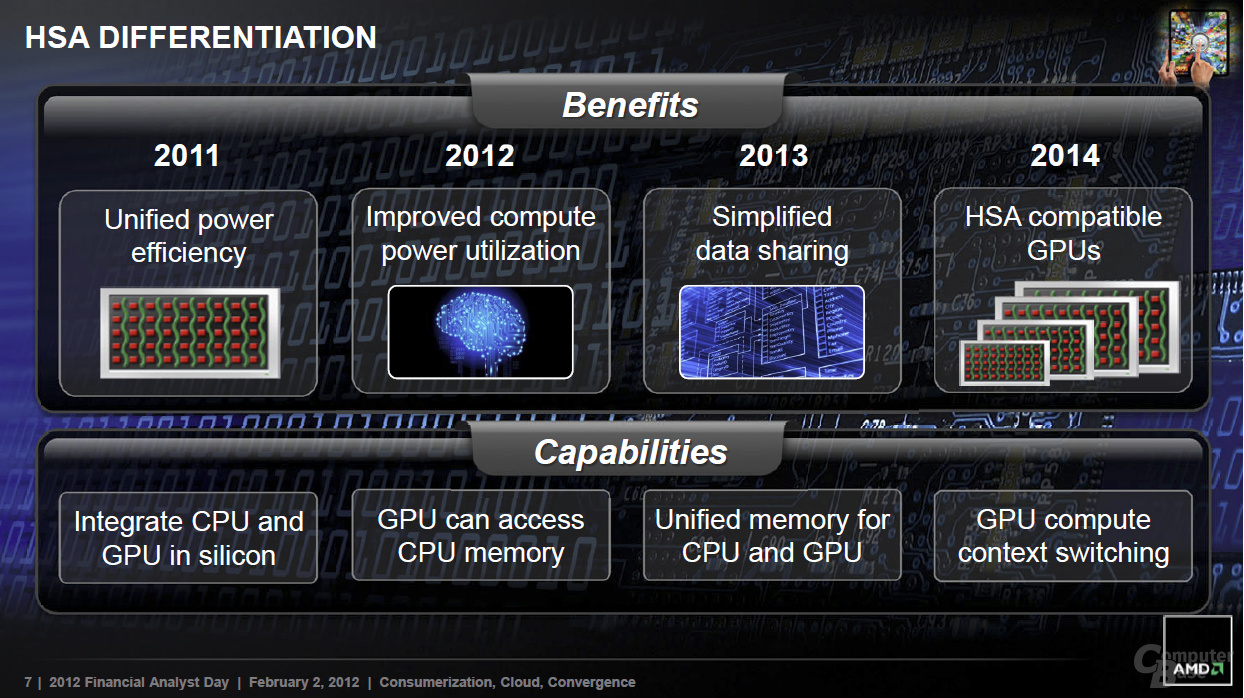

Wobei die Sinnhaftigkeit eigentlich erst mit Kaveri anfangen könnte (und den richtigen Sinn dann erst ab dessen Nachfolger leichter nachvollziehbar sein sollte. Stichwort : GPU compute context switching)AMD sieht die iGPU ja nicht nur als Spezialisten für Grafikwiedergabe, sondern sie soll von den Anwendungen auch wo immer möglich für GP-GPU, also unterstützend bei allgemeinen Berechnungen, genutzt werden.

Denn anders als bei CPU und dgpu muss man die Datein die man bearbeitet nicht zuerst in den Speicher der Grafikkarte laden um die gpu Power nützen zu können, sondern die Daten sind für CPU und igp gleichwertig im Speicher vorhanden.

Trinity hat somit noch nicht die Vorteile einer richtigen vollwertigen APU, die übrigens Intel Prozessoren in einigen Anwendungen dann doch gefährlich werden könnte.

Es stimmt zwar dass oft schleifen verwendet werden doch gibt es ja bei AMD jemanden, der ja daran arbeitet alles zu Parallelserien.

https://www.computerbase.de/2012-08/schoepfer-von-gustafsons-gesetz-verlaesst-intel-in-richtung-amd/

Gustafsons Gesetz: Es besagt, dass ein genügend großes Problem effizient parallelisiert werden kann.

Da immer mehr zur HSA Foundation gehören, würde mich wundern wenn NV da nicht vllt auch mal dazu kommt, könnte es im Mobilen Bereich schon fruchten und irwann effizient in den Desktop Sektor umschwappen, wenn genug Programmierer sich dafür begeistern.

http://www.planet3dnow.de/cgi-bin/newspub/viewnews.cgi?id=1348518657

Tools wurden ja schon vorgestellt. PS4 ect könnte interessant sein, weil man in dem geschlossenen System HSA ausnützen kann. Bsp igp berechnet Physikcs Ki und co.

Wie schon gesagt, gpgpu ist nicht das gleiche, was AMD mit der integration der igp in der CPU vor hat. Man entfernt somit viele Schwierigkeiten. Bsp das Auslagern und verschieben von Daten.Vorteile bei GPU-beschleunigten Berechnungen bringen kann, aber dafür auch den Stromverbrauch erhöht.

Dazu finde ich es interessant das AMD RamDisk aufgreift. Eventuell kann man dann mit einem großen Speicherraum, momentan 64gb, vllt sogar Datein dank schneller Zugriffszeiten über eine APU effizienter bearbeiten. Mal sehen ob das mal eine Rolle spielt.

Lübke,

Ich wage zu behaupten, dass AMD gar nicht mal so schlecht dastehen würde mit Intels 22nm.

Man könnte wesentlich höheren Takt erzieheln. Die DIE-Size wäre wesentlich kleiner, doch overclocking könnte besser ausfallen (Weniger Hitzeprobleme vllt ?)

http://www.golem.de/news/14nm-xm-gl...ozent-laengere-akkulaufzeiten-1209-94727.html

Bin gespannt ob GF seine vorhaben halten kann. 20 nm doch 2013 auf den Markt bringt und 14nm mit finfet schneller auf den Markt bringt als erwartet wurde.

Wenigsten würde man Intels Vorsprung etwas verringern.

Sicherlich hat Intel die chips auseinander genommen und untersucht. Das ist bei vielen Firmen ja nix untypisches. Sache ist nur, es gibt ja sowas wie Patente ect.vor allem der "bauplan" der hd7660 dürfte bei intel auf großes interesse stoßen

Auch ein Grund wieso Intel von NV Lizenzen geholt hat.

Ja und das machen die meisten eben nicht. Lieber spalten sie es dann auf CPU und igp auf und deshalb ist es eben schwer gegen cpu und dgpu anzukommen.in Summe gesehen ist der Trinity im Vergleich zum i3 Ivy als APU einfach besser.

Die Unterschiede zwischen APU und CPU+dgpu wird sich erst in 1-2 Jahren zeigen, wenn die Ressourcen dann auch sinnvoll geteilt werden können.

Im Endeffekt kann ich AMD verstehen wieso man immer Zwischenschritte auf den Markt bringt. Würde man den Fertigen Fusion schon auf den Markt werfen, könnte der sowieso nicht seine Power ausnützen, sie FX und deren Instruction sets, die noch kaum genutzt werden (Bsp nutzen der FPU).

Lieber dann eine zeit lang ein Mischenmarkt bedienen, den family-Pc zum bsp.

Noch ein schönes Bild um den Unterschied vom gpgpu und HSA zu verdeutlichen

http://www.tomshardware.de/fusion-hsa-opencl-Geschichte-APU,testberichte-241088-9.html

Zuletzt bearbeitet:

oldmanhunting

Admiral

- Registriert

- Nov. 2008

- Beiträge

- 9.457

Ich denke nicht, das es erstrebenswert ist auf 22nm zu gehen um mehr Takt zu erzielen. Die Effizienz muss besser werden, damit AMD auf Augenhöhe mit Intel ist.

Das 22nm also umso kleiner auch umso schwerer zu kühlen bedeutet, hat ja Ivy schon gezeigt. Warum sollte das bei AMD anders sein?

Ich lese ja nun schon ein paar Jahre mit und wenn man etwas zurück blättert, dann gab es immer etwas wo man bei AMD drauf gewartet hat, was den entscheidenden Performance Sprung bringen sollte. Wie hoch waren die Erwartungen mit Bulldozer, wo man bis zum Schluss schon die Antwort auf Sandy gesehen hat.

Das letzte große Schlagwort war Piledriver, der es richten wird.

Hier ein Artikel au dem Luxx, bevor Trinity raus kam: Piledriver ohne nennenswerten Performance-Zuwachs und gleichzeitig AMDs letzte High-End-CPU?

Jetzt ist es HSA, was bis 2014 den großen Schub bringen soll und man ist echt der Meinung, das Intel 2014 dann ganz erstaunt feststellt, das AMD jetzt die besseren CPU´s baut und Intel bis 2016 darauf reagieren wird um den verlorenen Terrain zurück zu gewinnen? Das ist doch Traumdenken. Intel schaut sich heute schon sehr genau an wie es um HSA steht und hat dann zeitgleich die Antwort dafür. Allerdings in 14nm.

AMD muss CPU´s für heute bauen, die auch heute verkauft werden und aufhören seine Kunden auf die Zukunft zu vertrösten. Es gibt genügend Leute, die noch einen Phenom oder einen X6 haben und liebend gerne auf einen schnelleren besseren AMD updaten würden.

Das 22nm also umso kleiner auch umso schwerer zu kühlen bedeutet, hat ja Ivy schon gezeigt. Warum sollte das bei AMD anders sein?

Ich lese ja nun schon ein paar Jahre mit und wenn man etwas zurück blättert, dann gab es immer etwas wo man bei AMD drauf gewartet hat, was den entscheidenden Performance Sprung bringen sollte. Wie hoch waren die Erwartungen mit Bulldozer, wo man bis zum Schluss schon die Antwort auf Sandy gesehen hat.

Das letzte große Schlagwort war Piledriver, der es richten wird.

Hier ein Artikel au dem Luxx, bevor Trinity raus kam: Piledriver ohne nennenswerten Performance-Zuwachs und gleichzeitig AMDs letzte High-End-CPU?

Jetzt ist es HSA, was bis 2014 den großen Schub bringen soll und man ist echt der Meinung, das Intel 2014 dann ganz erstaunt feststellt, das AMD jetzt die besseren CPU´s baut und Intel bis 2016 darauf reagieren wird um den verlorenen Terrain zurück zu gewinnen? Das ist doch Traumdenken. Intel schaut sich heute schon sehr genau an wie es um HSA steht und hat dann zeitgleich die Antwort dafür. Allerdings in 14nm.

AMD muss CPU´s für heute bauen, die auch heute verkauft werden und aufhören seine Kunden auf die Zukunft zu vertrösten. Es gibt genügend Leute, die noch einen Phenom oder einen X6 haben und liebend gerne auf einen schnelleren besseren AMD updaten würden.

Zuletzt bearbeitet:

pipip

Fleet Admiral

- Registriert

- Jan. 2011

- Beiträge

- 11.411

Ich denke nicht, das es erstrebenswert ist auf 22nm zu gehen um mehr Takt zu erzielen. Die Effizienz muss besser werden, damit AMD auf Augenhöhe mit Intel ist.

Wo hab ich das auch geschrieben ? es ging eher Vergleich vom jetzigen FX Vishera zum IB zum bsp

Ja das ist reine Spekulation, aber Bulldozer zu mindestens, scheint nicht "zusammengekürzt" zu sein wie bsp SB verglichen zum SB-Extreme. Also wundert es mich nicht wenn man mit einem IB-Extreme besser OC könnte :O Aber ja vllt lehne ich mich da zu weit aus dem Fenster. Ist sehr oberflächig.Warum sollte das bei AMD anders sein?

Blödsinn, jetzt ist es Steamroller, denn scheinbar hat man die Pläne geändert und gleich Steamroller weiter entwickelt und da weiter Geld reingesteckt. Das sieht man ja dass der eigentliche Nachfolger von FX ja durch Vishera ausgetauscht worden ist.Jetzt ist es HSA

Klar wenn man das Know-How hat, siehe SB, IB HSW igp ect. Intel versucht ja ihr Magny-Core Projekt weiter voranzubringen um hier eine Alternative mal marktreif zu machen.Intel schaut sich heute schon sehr genau an wie es um HSA steht und hat dann zeitgleich die Antwort dafür. Allerdings in 14nm.

Also Antwort setzt man ja extra auf AVX2 um gegen HSA etwas zu haben ect.

Wusste gar nicht dass das ein Beratungsthread ist. Dachte eher es geht um Trinity. Ich hab lediglich Herdware's Gedanke und Ziel der APU aufmerksam gemacht.AMD muss CPU´s für heute bauen, die auch heute verkauft werden und aufhören seine Kunden auf die Zukunft zu vertrösten

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 228

- Aufrufe

- 54.525