DerRico schrieb:

Stimmt nicht. Die ersten Monate lief bei AL bei Intel überhaupt gar nichts rund bei Spielen das war viiiiiiiiel schlimmer als die paar kleinen Problemen hier beim x3d-Scheduler, der schon sehr gut funktioniert. Jetzt haben Intel und MS das für Intel gefixt und alles ist gut, der Frühkäufer zahlt hat bei jeder der beiden Firmen mehr für weniger Reife - ist so, weiss man.

Du sprichst von der Vergangenheit, ich denke eher an die Gegenwart und die Zukunft.

Natürlich gibt es Probleme, wenn spezielle Hardware verbaut ist und die Software nicht darauf abgestimmt ist. Das ist eher ein generelles Problem und liegt nicht daran, dass Intels Ansatz in irgendeiner Weise schlechter wäre.

Bei AMDs Ansatz sehe ich aber ein viel größeres mögliches Problem auf uns zukommen, eben weil gar keine entsprechende Hardware verbaut ist und sich stattdessen komplett auf die Xbox Game Bar verlassen wird, die nicht in jedem Game funktioniert, zumal manch ein Spiel vielleicht mit höherem Takt besser läuft als mit dem zusätzlichen Cache. Wie soll die Software das entscheiden? Das schreit förmlich nach zusätzlichem Konfigurationsaufwand für den User.

Bei Intel hingegen ist es ganz simpel: Schnelle Kerne und langsame Kerne. Bei AMD sind die einen Kerne mal schneller und mal sind es die anderen.

DerRico schrieb:

Der 7900x3d hat - man muss es scheinbar mehrfach sagen - genau so viele Kerne wie der 7900/x. Und jeder von denen kann spielen ;-). Ihm gehen nur schneller die Kerne mit Zusatzcache aus und dann wird es mit dem Scheduler interessant.

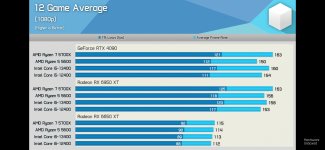

In jedem Fall erreicht er bei einem Spiel, welches mehr als 8 Kerne verwenden würde aber immer mindestens die Leistung eines 7900/x. In diesem aktuell theoretischen Szenario sind dann aber dem 13700k und dem 7800x3d auch schon längst die Kerne ausgegangen.

Hat das schon jemand tatsächlich getestet, ob der 7900X3D mehr als 6 Kerne verwendet, wenn ein Spiel es unterstützt? Bei den Benchmarks, die ich bisher gesehen habe (und bei denen es ersichtlich war, welche Kerne ausgelastet werden), wurden bisher immer 6 Kerne genutzt. Kann aber natürlich an den jeweiligen Spielen gelegen haben.

Ich kann mir beim besten Willen nicht vorstellen, dass ein Spiel "einfach so" (ohne Leistungseinbußen) weitere Kerne verwenden kann, die unterschiedlich schnell sind, wenn das Spiel nicht extra darauf optimiert ist. Das kann eigentlich nur im Chaos enden, weil das Spiel in der Regel auch nicht weiß, ob es den Kern mit 3D V-Cache oder den Kern mit höherem Takt für eine bestimmte Aufgabe präferieren soll.