puh, mehr zerstückeln ging nicht?

Quidproquo77 schrieb:

Warum persönlicher Wunsch? Es gibt ja verfügbare Hardware die das kann, insofern finde ich es halt schwach wenn dieser wichtige Teillastbereich seit Jahren am Desktop so vernachlässigt wird.

das eine hat mit dem anderen aber nichts zu tun.

es gibt genauso viel auf dem markt was nicht sparsam ist.

daher ist es erstmal deine anforderung.

Quidproquo77 schrieb:

Ich glaube die Anforderungen sind was die Masse betrifft ziemlich identisch.

halte ich für vermessen das anzunehmen.

wenn du recht hättest, würde auch der 7800x3D wie blei in den regalen liegen.

ist aber nicht so, daher haben viele andere offensichtlich nicht deine erwartungen.

Quidproquo77 schrieb:

Das muss man denke ich eher im Gesamtkontext sehen. Als 3 Personen Haushalt benötigen nur 1400KW/h pro Jahr. Das liegt zum einen an modernen Geräten und zum anderen daran, dass alle Anschaffungen, egal ob Spülmaschine, Lampe, Handy, PC und Monitore sehr energieeffizient sind.

Mich würde es massiv stören, wenn das System beim nichts tun permanent 100W aus der Dose nuckelt, dann macht es wirklich mehr Sinn ans Handy zu gehen. Mit der eingeschränkten Nutzererfahrung dann.

auch hier wieder: deine anforderungen!

ich finde es gut, aber ich teile es nicht.

ein gerät hat unterschiedlichste anforderungen zu erfüllen, eine davon ist natürlich auch der verbrach bzw. die effizienz.

Quidproquo77 schrieb:

Ja Mainboards machen schon etwas aus, sicher. Aber die CPUs und deren Powerstates halt auch

alles gehört natürlich dort hinein und keine einzelne komponente kann hier speziell rausgegriffen werden.

Quidproquo77 schrieb:

Mit dem sparsamten Board und einer APU ja, mit einer CPU halt eher nicht.

Die Tests müssten nur mehr auf Teillast eingehen, dann würde man das auch sehen. Früher hat man auch keine CPU Leistungsaufnahme in Spielen vermessen, man nahm immer Prime 95/Cinebench als gegeben an.

nein, es braucht keine apu damit auch an am5 system sparsam ist.

da aber natürlich nie ein breites spektrum betrachtet werden kann und die hersteller interessiert sind die fetten teile oben aus dem regal zu bewerben, gibt es oft ein verzerrtes bild.

das kann man gerne machen, würde aber meiner meinung nach nichts ändern am verhalten der mehrheit.

die kauft das was die mehrzahl der ansprüche abdeckt.

Quidproquo77 schrieb:

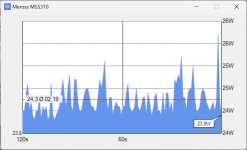

Wäre doch ganz einfach. Idle, Browser, Youtube, Word, Photoshop starten, und dabei package power und Systemverbrauch über eine gewisse Zeit mitloggen. Klar das ist wieder zeitlicher Aufwand, aber die Menschen interessieren sich heute viel mehr für die Effzienz.

halte ich für nicht haltbar die these.

sonst hätten wir in umfragen hier eine gänzlich andere verteilung der hardware.

und oem ist dabei noch nicht mal betrachtet.