Xes

Admiral

- Registriert

- Nov. 2013

- Beiträge

- 7.690

@Hito360

Wenn ich mich recht erinnere wurde vor einiger Zeit angestrebt durch DX 12 sogar Nvidia und AMD-GPU`s im Verbund arbeiten zu lassen. Bis heute habe ich da aber keine großartigen Neuigkeiten dazu gelesen.

b2t.

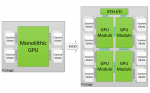

Ich fand diese ganz speziellen Dual-GPU`s immer sehr interessant.

Die liegen allerdings preislich entweder weit weg von dem, was ich bereit bin in Hardware zum spielen zu investieren oder sind generell sinnlos (wie diese Dual GTX 760 Karte, den es vor einigen Jahren gab.)

Würde ich mir daher nicht kaufen, hat aber einen netten "exotischen" Show Effekt und ich sehe mir gerne passende Systeme und Benchmarks dazu an.

Wenn ich mich recht erinnere wurde vor einiger Zeit angestrebt durch DX 12 sogar Nvidia und AMD-GPU`s im Verbund arbeiten zu lassen. Bis heute habe ich da aber keine großartigen Neuigkeiten dazu gelesen.

b2t.

Ich fand diese ganz speziellen Dual-GPU`s immer sehr interessant.

Die liegen allerdings preislich entweder weit weg von dem, was ich bereit bin in Hardware zum spielen zu investieren oder sind generell sinnlos (wie diese Dual GTX 760 Karte, den es vor einigen Jahren gab.)

Würde ich mir daher nicht kaufen, hat aber einen netten "exotischen" Show Effekt und ich sehe mir gerne passende Systeme und Benchmarks dazu an.