GerryB

Rear Admiral

- Registriert

- Sep. 2016

- Beiträge

- 5.145

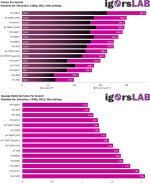

zu Starfield gibts die AnalyseMoinWoll schrieb:Ich fände es echt interessant mal eine Analyse dazu zu sehen, warum RDNA2/3 relativ zu Ampere/Ada Lovalace in einigen Spielen bzw. Spielereihen (CoD, Starfield, Battlefield, Assassin's Creed) so viel besser performen als im Durchschnitt. Es wäre auch interessant, ob softwareseitige Anpassungen dazu führen könnten, dass Ampere/Ada Lovelace hier wieder gleichziehen können, oder ob hier tatsächlich die Hardwarearchitektur ein hartes Limit darstellt.

https://chipsandcheese.com/2023/09/...erformance-on-nvidias-4090-and-amds-7900-xtx/

NV kann da per Software die Hardware-Bottlenecks vermutlich nicht beheben.

Wie kann Das sein?Trelor schrieb:Dual Issue ist bei AMD anders Implementiert als bei NVIDIA. ...

Die meisten Shader Compiler für den PC ignorieren die Dual Issue Befehle von RDNA3 weitesgehend. Das ist ein großes Problem von RNDA3.

Normalerweise ist doch im SDK genau erklärt, wie die Programmierer/Studios die Hardware händeln sollen.

Haben da manche Studios "ausversehen" keine Zeit+Muße ihre Software auf Vordermann zu bringen?

Zuletzt bearbeitet: