Celinna

Commander

- Registriert

- Nov. 2007

- Beiträge

- 2.371

B3nutzer schrieb:Habs jetzt bei mir auch nochmal mit ner Slow Mo Aufnahme vom Monitor geprüft. Das hätte ich gleich von Anfang an machen sollten.

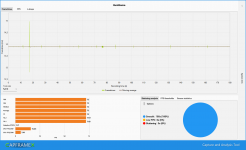

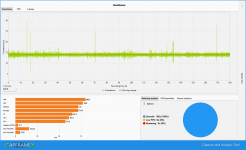

In der gesamten Benchmarkszene sind mir jetzt mit Hilfe der Slow Mo zwei winzige Unregelmäßigkeiten aufgefallen. Einmal am Speicherpunkt am Tor und dann nochmal kurz danach. Das wars. Die Ausgabe am Display ist praktisch perfekt mit Gsync und ohne Vsync (Gamepadsteuerung).

Damit hat sichs für mich auch erledigt. Das Game läuft absolut sauber bei mir. Kein Grund sich verrückt machen zu lassen.

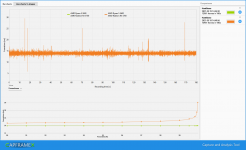

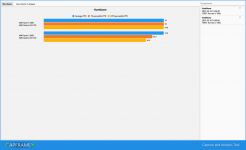

deckt sich ja mit dem was 99% der Spieler hier sagen, was am Ende am Monitor ankommt mit Gsync ist absolut perfekt, kein ruckeln, kein zuckeln, keine riesen Framesprünge(MSI AB: 12,6ms->12,8ms z.B.). Da interessiert nicht was davor im PC passiert(capframex), solange das was am Ende rauskommt super ist.

Edit: nix gegen capframex

Zuletzt bearbeitet: