Farcrei schrieb:

bei dem Namens-wirwar werde ich mir die nächste Zeit keine nvidia-Karte kaufen

GT212 und die anderen GTxxx sind

offiziel unbestätigte Namen der Chips. Wie die Grafikkarte im Endeffekt benannt wird ist doch noch garnicht raus, und du heulst schon rum ?

Bei hardware-infos.com findet man übrigens noch zwei weitere Artikel bezüglich des GT212 und seine performanceschwächeren Namensbrüder GT214, GT216 und GT218.

Der erste Artikel vom 06.11.2008 besagt das der Launch aufgrund der Probleme mit dem GT200b (aka GT206) vom Q1-2009 ins Q2-2009 verschoben wurde, und evtl. sogar erst einer der schwächeren und einfacher herstellbaren GT21x Chips auf den Markt kommen würde.

Der zweite Artikel vom 27.12.2008 wiederrum sagt das nun laut einer NV-Roadmap doch zuerst der Highend-GT212 im Q2-2009 auf den Markt kommt und die restlichen GT21x erst Q3-2009 erscheinen.

Jetzt könnte man natürlich spekulieren das die GT212 Chips schon recht nahe dem Finalen Tapeout sind oder diesen gar schon hinter sich gebracht haben. Und dementsprechend könnten auch erste Ableger recht früh im Q2-2009 schon auf dem Markt auftauchen.

Dies alles hängt wahrscheinlich auch vom Erfolg des

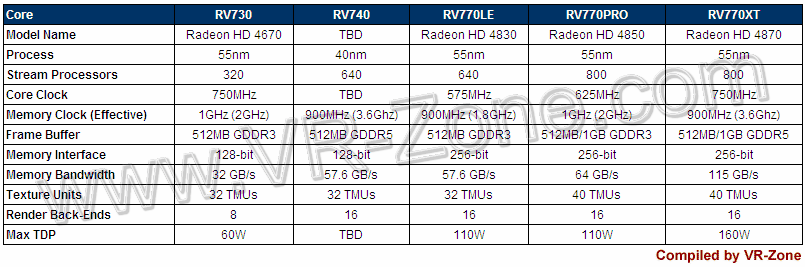

recht bald anstehenden RV775 Launches ab. Schon beim RV770 verläuft Leistungsanstieg annährend Linear zum gesteigerten Takt. Wenn man jetzt überlegt wie schnell ein RV770 mit 900MHz wäre, ist es ja durchaus denkbar das der RV775 die GTX260 Karten deutlich überflügelt und die evtl sogar die GTX280/285 angreifen kann, und dementsprechend wird NVidia versuchen zeitnah zu reagieren.

EDIT1:

P.S.: Übrigens in der Nachbetrachtung eigentlich auch nicht unlogisch warum NV die Namen GTX 270 & GTX 290 freigehalten hat.

EDIT2:

@Krautmaster

Völlig richtig. Aktuelle Infos besagen das DX11 auch auf Vista funktionieren wird.