Im Moment funktionieren die "unvernünftigen" DDR5 Speichermodule genauso gut wie die "vernüftigen" DDR4 Module, die es übrigens auch nicht umsonst gibt. Mit dem bereits genannten Vorteil, sie auch noch Jahre später weiter benutzen zu können oder das bereits gekaufte Board später mit schnelleren DDR5 Modulen nachrüsten zu können.Chillaholic schrieb:Da kannste gleich B-Die kaufen und auf vernünftigen DDR5 zu Normalpreis warten.

Wer den Speicher bereits hat, da stellt sich die Frage nicht, wer neu kauft, sollte sich zwei mal überlegen ob die Sackgasse das richtige für ihn ist.

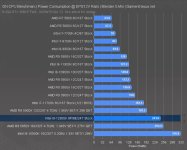

Der entscheidende Faktor sind aktuell nur die Kosten und nicht die Leistung. Die Behauptung einiger, DDR5 würde aufgrund der angeblich so hohen Latenzen viel schlechter abschneiden, hat sich nicht bestätigt. Die Kosten aus Beschaffungspreis, Nutzungsdauer, möglichen Verkauf, muss sich jeder selbst für seinen Anwendungsfall ausrechnen. Nur auf den Kaufpreis zu achten, ist da viel zu kurzsichtig.

Zuletzt bearbeitet: