Also ich muss sagen, krass was Destiny 2 für Anforderungen an die CPU stellt.

Vor allem bei "Öffentlichen Events" . Ich spiele auf "High" Texturen auf "Highest" und DOF+Motion Blur "OFF".

In den Öffentlichen Events geht es dann von 160-200 FPS runter auf 89 FPS und diese Drops fühlen sich schon extrem grausam an. Parallel dazu sinkt die GPU Last auf 62% oder tiefer.

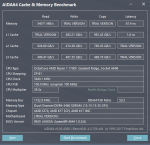

Ich weiß nicht wie man hier die FPS deutlich steigern könnte. Keine Ahnung ob das Spiel mehr Kerne/Threads, Takt oder IPC benötigt. Aber ein 6700K @ 4.7 Ghz + 1080 Ti @ 2Ghz und 3866Mhz CL16 reichen bei weitem nicht aus um dauerhaft smoothe 120 FPS+ zu erreichen.

Vor allem bei "Öffentlichen Events" . Ich spiele auf "High" Texturen auf "Highest" und DOF+Motion Blur "OFF".

In den Öffentlichen Events geht es dann von 160-200 FPS runter auf 89 FPS und diese Drops fühlen sich schon extrem grausam an. Parallel dazu sinkt die GPU Last auf 62% oder tiefer.

Ich weiß nicht wie man hier die FPS deutlich steigern könnte. Keine Ahnung ob das Spiel mehr Kerne/Threads, Takt oder IPC benötigt. Aber ein 6700K @ 4.7 Ghz + 1080 Ti @ 2Ghz und 3866Mhz CL16 reichen bei weitem nicht aus um dauerhaft smoothe 120 FPS+ zu erreichen.