Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Intel Optane SSD 900P im Test: Der Benchmark-Kaiser ist im Alltag kaum schneller

Zwirbelkatz

Fleet Admiral

- Registriert

- Juni 2006

- Beiträge

- 47.474

Das sehe ich ähnlich. Man wartet von 2011 bis 2017 darauf, dass sich (im Mainstream) mal endlich etwas Signifikantes tut. Da handelt es sich dann, je nach Setting, um Leistungsvorteile von 15-30%. Zumindest für Spieler in hoher Auflösung.tomasvittek schrieb:was mich NICHT interresiert ist der preis.

Wieso also bei Festplatte (und Ram) die Leistung liegen lassen, wenn sich sonst schon kaum noch etwas tut?

Kaufe ich mir hier und heute eine extrem schnelle Plattform, profitieren davon 2-3-4 weitere Grafikkarten bei der Aufrüstung. Früher oder später wird entweder das Hobby aufgegeben oder aber eine dicke Grafikkarte nachgerüstet. Demnach zählt das Argument "ich bekomme bei der Neuanschaffung an Tag X für dieselbe Summe eine bessere Grafikkarte" einfach nur sehr bedingt. Denn schon die nächste Generation macht diesen Schritt zumeist für viele erschwinglich.

Wer anders rechnet oder ein sehr kleines Budget hat, für den zählen wiederum andere Dinge.

Vielen Dank für die Ausführungen.Holt schrieb:S.o. und lies einfach meinen Beiträge in diesem Thread.[...]

Zuletzt bearbeitet:

(mea culpa)

Tramizu

Vice Admiral

- Registriert

- Sep. 2014

- Beiträge

- 6.281

Die jetzigen Schritte sind in der Regel alle sehr klein.HaZweiOh schrieb:Joa, dann ziehen wir wohl beide das Fazit, dass die Optane den Aufstieg der SSDs nicht genauso wiederholen kann.

[das es noch Weiterentwicklungen davon geben wird, bezweifele ich nicht]

Ein richtiger Meilenstein wird eines Tages photonischer Datenspeicher sein. Ist zwar alles noch Zukunftsmusik, aber manchmal kann das schneller gehen als man denkt. Vor 15-20 Jahren dachte man auch noch, dass dem optischen Datenspeicher, wie CD´s und Co, gehört die Zukunft.

Zuletzt bearbeitet:

Habe noch ne Vertex2 mit 50 GB rumliegen, müsste noch funktionieren (zumindest vor 5 Monaten, bis ich sie aus Platzgründen gegen eine Samsung 850Pro mit 512 GB tauschte).

Hatte die Vertex früher als "WoW-Platte" im Wechseleinschub, am Laptop wurde sie dann über eSATA angeschlossen. Brauchte somit die Addons nicht mehrfach verwalten, (Addon-)Einstellungen blieben gleich und brauchte nur die Config für den jeweiligen Rechner umbenennen. Mit Draenor wurde WoW aber zu groß und dann kam halt ne 850Pro mit 256 GB als "Wechselplatte" (habe 2 Einschübe, darum jetzt 2 850er).

Bei Steam läuft es übrigens auch wunderbar, man braucht nicht mehrmals runterladen oder patchen.

Übrigens konnte man an WoW auch gut die Unterschiede sehen (Orgrimmar gut gefüllt), wie die Spieler "aufploppten". Referenz war damals meine (noch immer laufende -> Bootsektor + XP; 7 ist auf SSD 840Pro) VelociRaptor, war schon seehhr deutlich spürbar. Aber auch zwischen VelociRaptor und einer normalen 7200er (darum war die Raptor auch DAS Systemlaufwerk vor dem "SSD-Boom")...

Aber solche Performanceunterschiede wird mal wohl nicht zwischen der Vertex2 und Optane spüren (wenn man überhaupt was spürt, darum wäre ein Vergleich mal interessant gewesen)...

Hatte die Vertex früher als "WoW-Platte" im Wechseleinschub, am Laptop wurde sie dann über eSATA angeschlossen. Brauchte somit die Addons nicht mehrfach verwalten, (Addon-)Einstellungen blieben gleich und brauchte nur die Config für den jeweiligen Rechner umbenennen. Mit Draenor wurde WoW aber zu groß und dann kam halt ne 850Pro mit 256 GB als "Wechselplatte" (habe 2 Einschübe, darum jetzt 2 850er).

Bei Steam läuft es übrigens auch wunderbar, man braucht nicht mehrmals runterladen oder patchen.

Übrigens konnte man an WoW auch gut die Unterschiede sehen (Orgrimmar gut gefüllt), wie die Spieler "aufploppten". Referenz war damals meine (noch immer laufende -> Bootsektor + XP; 7 ist auf SSD 840Pro) VelociRaptor, war schon seehhr deutlich spürbar. Aber auch zwischen VelociRaptor und einer normalen 7200er (darum war die Raptor auch DAS Systemlaufwerk vor dem "SSD-Boom")...

Aber solche Performanceunterschiede wird mal wohl nicht zwischen der Vertex2 und Optane spüren (wenn man überhaupt was spürt, darum wäre ein Vergleich mal interessant gewesen)...

- Registriert

- Juli 2010

- Beiträge

- 14.234

Das Problem bei Online-Spielen ist aber, dass immer auch die Latenz zum Server eine Rolle spielt. Und die schwankt ja in der Regel. Da lassen sich dann schwer gleichbleibende Bedingungen schaffen und entsprechend wären die Rückschlüsse auf die Speicherleistung nicht eindeutig.

Ich habe eine Vector-180. Das Potential sieht man in dem Diagramm Leistungsbeständigkeit. Während die anderen SSDs nach 1-2 Minuten Schreiblast zusammenbrechen läuft der Transfer bei der OCZ mit verhältnismäßig guten Werten weiter. Ansonsten hatt die m.W. keine herausragende Eigenschaft. Im Gegenteil, pro gelöschtes GB ist die ca. 1s busy beim TRIM.Vindoriel schrieb:@MichaG:

Habt Ihr noch eine alte SSD wie die OCZ Vertex 2 oder Ähnliches aus der Zeit?.

- Registriert

- Aug. 2012

- Beiträge

- 7.483

Kleine Anmerkung @ Zwirbelkatz: Das Zitat ist nicht von mir.  Da ging wohl was durcheinander.

Da ging wohl was durcheinander.

Mich interessiert der Preis schon.

p.s.: https://www.computerbase.de/forum/t...g-kaum-schneller.1729710/page-5#post-20694972

Mich interessiert der Preis schon.

p.s.: https://www.computerbase.de/forum/t...g-kaum-schneller.1729710/page-5#post-20694972

Zuletzt bearbeitet:

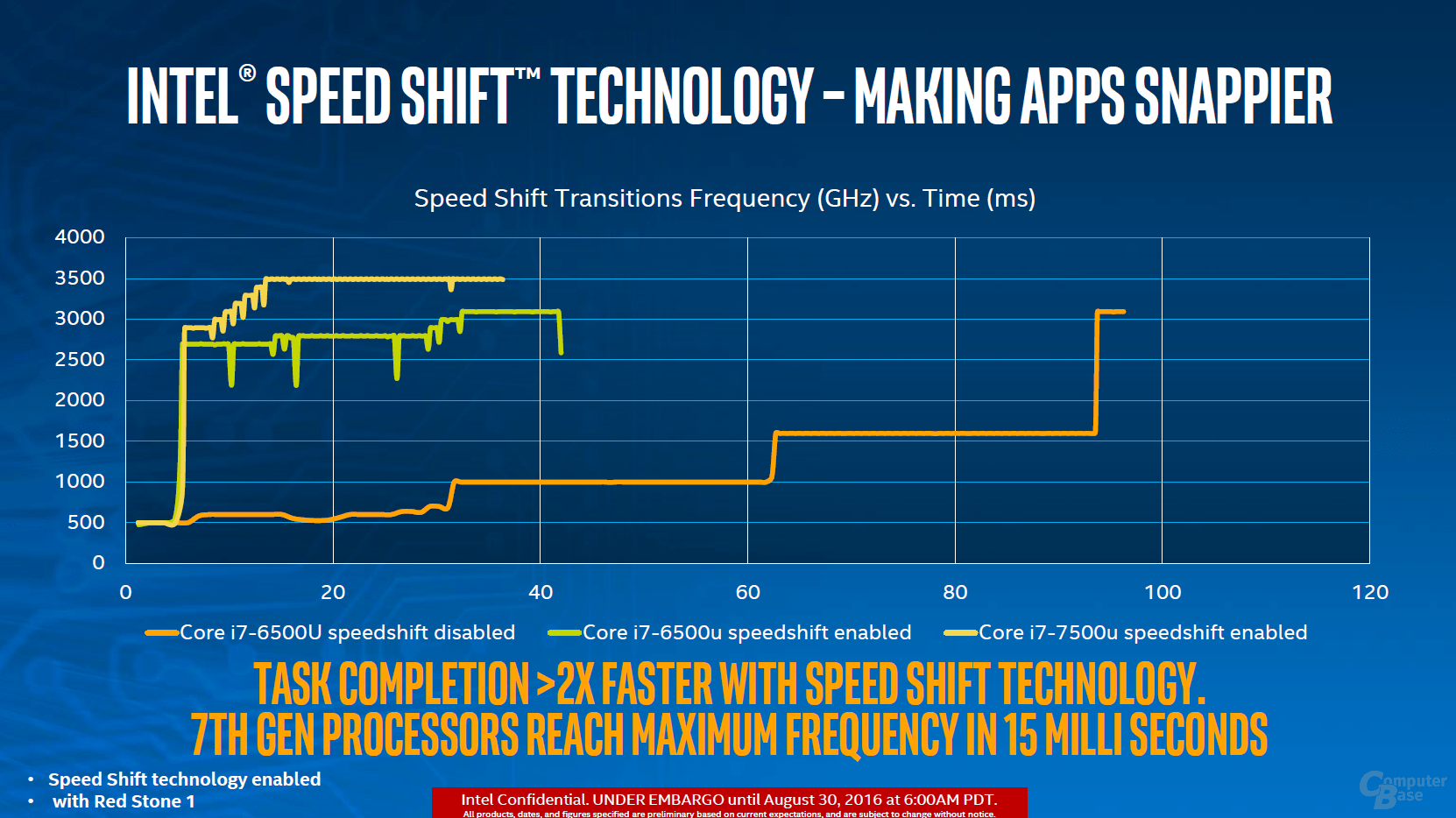

Die guten 4k QD1 Lesend bedeuten nur, dass die Latenz des Systems gering ist, aber die CPU wird hier ja auch mit einem festen Takt betrieben und damit bekommt man bei allen Systemen die geringsten Latenzen hin. Bei Intels neusten Plattformen mit Speed Shift 2 (nur für Win 10 ab Version 10586), dürfte der Effekt geringer sein, weil die CPUs damit die Taktraten weit schneller anpassen:ZeroZerp schrieb:@unlimited1980

Naja-Das beweist nur, dass das System eben in praxisfernen Szenarien tolle Leistung bringt.

Wie viel dies ausmacht, zeigt auch der in der News: "Speed Shift: Intel-Technik verringert Latenz bei Touch-Bedienung" zitierte Test.

Bei AMD alten AM3 machen die Energiespareinstellungen noch viel mehr aus und gehen auch auf die seq. Transferraten. Schau mal hier, wie die Werte sich ändern, wenn man den CPU-Takt fest einstellt und natürlich auch alle anderen Energiespareinstellungen in Windows und im BIOS (Cool'n'Quiet, C1E, etc.) deaktiviert. Ob das praxistaugliche Einstellungen sind, steht auf einem anderen Blatt, aber für die besten Benchmarkergebnisse, ist das unumgänglich.

Wie weit das auch noch für die AM4 Plattform gilt und ob AMD eine Antwort auf Speed Shift gefunden hat, weiß ich nicht. Wie hier schon mal ausführlich von mir aufgezeigt wurde, sind die 4k Werte mit ATTO z.B. von M.2 NVMe SSDs an Z270er Boards etwas doppelt so hoch wie bei AM4 Boards in den Mainboard Reviews von Hardwarelux, die Latenzen bei AM4 in der Defaulteinstellung (so dürfte die Mainboards in den Benchmarks laufen) ist also offenbar sehr viel höher, da die SSD ja selbst auch eine Latenz hat und wenn trotz 4 Overlapping I/Os bei 4k nur etwa halb so Werte rauskommen. Die Gesamtbandbreite ist auch nicht das Problem, da sind die Unterschiede nämlich nur minimal.

Hardwarecanucks testet neuerdings mit einem AM4 X370er System und einer R7 1700 CPU @4GHz mit 3200er RAM, also wohl mit konstantem Takt und obendrein schnellem RAM. Die TR200 480GB kommt damit bei ATTO bei 4k auf 95,382MB/s lesend und die BX300 auf 98,889 MB/s, also nochmal deutlich weniger, nämlich weniger als ein Drittel der 336,538MB/s die Thessdreview für die TR200 480GB bzw. 324,755MB/s für die BX300 480GB mit 4k bei ATTO auf einem Z170 Board mit i7 6700K mit deaktivierten C1E, C3 und C6 states sowie weiteren Optimierungen (den Guide nachzumachen kann ich nicht empfehlen) erreicht hat.

Andererseits ist ATTO nicht optimal die Latenzen zu zeigen, eben weil es 4 Overlapping I/Os sind, nur kann ich ja keine Benchmarks auswerten die nicht gemacht werden und Hardwareluxx veröffentlicht bei Mainboard Reviews eben bestenfalls die Screenshots von ATTO, schlimmstenfalls nur die Maximalwarte (deshalb liebe ich es, wenn Reviewer auch die Screenshots statt nur der eigenen Diagramme posten). Bei 4D (QD1) mit CDM ist der Unterschied nämlich weitaus geringer, da hat 25,81MB/s für die TR200 480GB und 29,39MB/s für die BX300 480GB ermittelt, während Thessdreview auf 34,47MB/s die für die TR200 480GB bzw. die 37,12MB/s für die BX300 480GB kommt, 33,6% bzw. 26,3% mehr und damit zwar immer noch ein nicht unwesentlicher Unterschied, aber längst nicht mehr über das Dreifache wie bei ATTO.

So ist es, die Daten müssen ja alleine schon beim Laden einen größeren Wert zurücklegen, selbst innerhalb der CPU in denen ja heutzutage die PCIe und die RAM Controller sitzen und die über Ringbus, Mesh oder eben die AM4 die Infinity Fabric miteinander verbunden sind.ZeroZerp schrieb:Beim Laden einer Anwendung spielt aber eben nicht nur I/O des Massenspeichers eine rolle, sondern die gesamte Plattform. CPU, RAM, Cache, PCI(e), DMI etc. etc.

Dann hoffen wir mal, dass wenn sich das Testverfahren ändert, der Link in den alten Artikel weiterhin auf diese Seite mit der wirklich während des Tests verwendeten HW verweist und der in Tests mit einer neuen HW dann auf die dort verwendete HW.MichaG schrieb:Zu Testsystem und Methodik haben wir doch schon lange einen eigenständigen Artikel auf den in jedem Test verlinkt wird.

Weil eben bei einer Anwendung mehr passiert als nur den Programmcode oder die Daten zu Laden, diese müssen eben immer auch verarbeitet werden, was mal mehr und mal weniger viel Arbeit für die CPU bedeutet. Wo es weniger ist, sie also nicht so lange auf den Daten "rumkauen" muss, bringt eine schnellere SSD eben auch mehr Vorsprung beim Gesamtergebnis, was keinen überraschen sollte und natürlich hat die Performance der CPU da auch einen Einfluss, je lahmer sie ist, umso länger braucht sie um einen bestimmten Algorithmus abzuarbeiten, der auf die Daten anzuwenden ist. Ob Single- oder Multithreadperformance eine größere Rolle spielen, hängt eben vom Algorithmus ab und ob der parallel arbeitet oder nicht.MichaG schrieb:Dort seht ihr, dass die Optane 900P ca. doppelt so schnell ist beim Durchsatz wie die 960 Pro. Bei der Dauer für die einzelnen Anwendungen gibt es dann aber im Bestfall nur 1% Vorsprung.

Ja ich weiß wer gemeint ist, aber es geht mir auch weniger um diese 100 Tabs an sich, sondern darum das es ein Beispiel ist, dass der Vorteil bei einer passenden Anwendung eben auch gewaltig sein kann und diese pauschale "es bringt im Alltag nichts" eben nur dann stimmt, wenn der Alltag keine Anwendung in der Art hat, wo wenig Verarbeitung der Daten erfolgt, die CPU also darauf nicht lange rumkaut. Denn das ist eben der Flaschenhals, der "woanders liegt".MichaG schrieb:Der Flaschenhals liegt leider oft woanders. Sich auf Spezialfälle zu konzentrieren (100 FireFox-Offline-Tabs anyone?) wäre zwar richtig, um die SSD zu fordern, aber wäre sowas für Normalnutzer relevant und praxisnah?

Übrigens sind es inzwischen 120 Tabs, die seit dem Wechsel vom i7 5930K zum R7 1700@4GHz für den Test verwendet werden und auch wenn man nicht weiß ob es noch die gleichen 100 bis weiterer 20 oder komplett andere Seiten sind, so hat das mit den 120 Tabs bei der MX300 525GB 130,4s gedauert 1,1075s pro Tab, während der Programmstart mit den 100 Tabs im alten System nur 107,9s gedauert hat, also nur 1,079s pro Tab. Da die Intel 750 1,2TB dies in 18,9s geschafft hat (mehr als Faktor 5 schneller als jede SATA SSD!), war hier eindeutig nicht die CPU das Limit. Schade nur, dass dort noch nie eine Samsung SSD getestet wurden und bisher auch keine Optane.

Eigentlich bist du auf einer Ingoreliste und ich weiß auch noch wieso, aber der Unterschied dürfte einfach sein, dass bei der Gesamtzeit auch noch die CPU Aktivität reinspielt, es ist ja ein Systembenchmark und kein reiner Storagebenchmark.Unlimited1980 schrieb:Verstehe ich das richtig, PCMark8 gibt die Ergebnisse doppelt aus, als Bandbreite und als Zeit?

Schon damals habe ich vorgeschlagen es selbst auszuprobieren, was mit NTFS und dessen Datenkompression sehr einfach und schnell geht. Man geht auf die Eigenschaften der Datei(en), Erweitert, wählt die Datenkompression und drückt Apply, wenn es durch ist vergleicht man die Größe der Datei mit der Größe auf dem Datenträger, je weniger diese abweichen, umso stärker sind die Daten schon vorher komprimiert, Wenn man Packprogramme wie 7Z, Rar oder ZIP nimmt, bekommt man gerade bei den stärkeren Algorithmen die über weite Bereiche nach Redundanzen suchen, leicht ein verzerrtes Bild, denn so starke Komprimierungen brauchen viele Resourcen und werden von Programmen kaum eingesetzt, schaffen es damit ggf. auch schon komprimierte Daten noch einmal deutlich nachzukomprimieren. Die NTFS Datenkompression ist im Vergleich dazu schwach, kann also normalerweise schon komprimierte Daten nicht noch großartig weiter komprimieren. Ganz kleine Dateien taugen für den Test nicht, da hier dann die Clustergröße das Ergebnis verfälschen kann.Unlimited1980 schrieb:Holt vermutet ja gewissen Dekompressionsalgos.

Er hat das aber niemals mit Links belegt oder eine Aussage dazu gemacht, welcher Anteil von normalen Alltagsdateien "komprimiert" ist.

Wieso sollte dies so sein? Wie sollte man dies benchen? Um den Einfluss der Datenkompression von NTFS mit dem AS-SSD zu messen, muss man schon das ganze Laufwerk mit der Komprimierung versehen. Außerdem ist die Kompression (die bemerkt man wegen der meist gepuffert ablaufenden Schreibvorgänge eher weniger) und vor allem Dekomprimierung nur ein Punkt und bin sicher darauf auch darauf auch verwiesen zu haben, der Arbeit das CPU an den Daten, der sich zu den ggf. erforderlichen weiteren Bearbeitungsschritte addiert, die auf den Daten erfolgen. Bei Spielen und ich meine darum ging es damals denn darum geht es hier bei CB meistens, dürfte es aber durchaus ein wichtiger Punkt sein, viel viel Daten danach an die Graka weitergereicht werden. Wenn Intel also von Optimierungen von Spielen für die Optane spricht, dann dürfte es genau darum gehen die Daten von der (Optane) SSD mit so wenigen Bearbeitungsschritten wie möglich an die Graka weiterzureichen.Unlimited1980 schrieb:Ich habe halt an seiner Aussage immer etwas gezweifelt, weil wenn es stimmen würde müsste ja die Laufwerksperformance inzwischen auch stark von der CP-Leistung abhängen (dekompression).

Die Kompression der Daten ist ja nicht aus Dummheit oder Böswilligkeit entstanden, sondern weil sie bei langsamen Datenträgern wie HDDs durchaus Performancevorteile bieten kann und auf jeden Fall werden die Daten dann auch weniger Plattenplatz beanspruchen, was bei einigen Spielen ja trotzdem durchaus nicht wenig ist. Die SW hängt den Möglichkeiten der HW nun einmal meist eine ganze Weilen, oft viele Jahre, hinterher, auch weil gefordert wird, dass sie auf alten Systemen immer noch lauffähig sein soll. Dies führt dazu, dass so ein Review natürlich nur eine Momentaufnahme ist und da man die Reviews natürlich möglichst zeitnah mit dem Erscheinen der HW lesen möchte, bleibt kaum Zeit dabei von Anpassungen zu profitieren, da diese immer ein gewisse Zeit brauchen:

So manches was in den ersten Reviews der AM4 oder auch Skylake-X CPUs steht, gilt heute nicht mehr, weil Anpassungen vorgenommen wurden, sei es am UEFI oder schon an der Software. Solche Reviews stehen aber lange im Netz und werden auch nach Jahren noch gelesen und für bare Münze genommen, auch wenn die Realitäten sich vielleicht schon geändert haben. Die Reviewer haben die HW dann vermutlich schon zurückgegeben, manchmal scheint diese schon vor der Veröffentlichung des Reviews ja nicht mehr verfügbar zu sein und Nachtests sind dann kaum machbar. Obendrein wird jede Woche eine andere Sau durchs Dorf getrieben, wen interessieren diese ollen Kammalen dann noch?

Nein blos nicht, denn die Vertex 2 hat den SF-1222 Controller und der ist mit den SATA Ports der Intel Haswell Generation (und wohl auch der Nachfolger, zumindest an den SATA 6Gb/s Ports) nicht kompatibel. Das Problem ist, dass der (war halt das Erstlingswerk eines Startups) nicht kompatible ist und da es daran liegt das er die elekronische Spezifikation nicht eingehalten hat (es ging vermutlich um Energiespareinstellungen, mit denen stand der SF--1222 immer auf Kriegsfuß und Corsair hat damals für Notebooks SSDs mit Indilinx Controller statt solchen mit SF Controllern empfohlen), konnte auch kein FW Bug dieses Problem jemals beheben. Die Probleme mit Energiespareinstellungen wurden dann teilsweise in der letzten FW nur behoben, indem man diese einfach nicht mehr unterstützt hat.Vindoriel schrieb:@MichaG:

Habt Ihr noch eine alte SSD wie die OCZ Vertex 2 oder Ähnliches aus der Zeit?

Vom Controller her sollte die Alternative ähnlich der OCZ sein, denn damals gab es noch viel Mist (lahme Controller usw.).

Wenn man also Vergleiche mit einer SSD aus der Zeit anstellen will, dann wäre eine Crucial C300 oder m4, die aber beide (vor allem die C300) nie wirklich gut mit LPM klar gekommen sind und auch so ihre Probleme mit Energiespareinstellungen hatten oder noch besser die Samsung 470 (die war damals eher lahm, aber zuverlässig und problemfrei) zu empfehlen, wenn man diese an heutiger HW testen möchte. Von Sandforce müsste man schon eine SSD mit einem Controller der 2. Generation nehmen wie die Vertex 3 oder besser noch Intels 320 / 520, denn Intel hat lang an der SF FW debuggt und dabei offenbar gute Arbeit geleistet, denn deren SSD mit dem Controller haben mit Abstand am wenigsten Probleme gemacht. Es dürfte schon seinen Grund gehabt haben, warum nach der Übernahme durch LSI und dann Avego und Seagate kein neuere Sandforce Controller mehr auf den Markt gekommen ist, obwohl sogar lauffähige Prototypen mit den SF-3xxx Controllern auf Messen gezeigt wurden. Die Qualitätsanforderungen großer Konzerne sind einfach höher als die von Startups und die Qualität war bei denen immer das Problem. Aber die Gründer können sich trotzdem freuen, wenigstens denn hat der Laden viel Geld eingebracht

Siegfriedphirit

Lt. Junior Grade

- Registriert

- Apr. 2009

- Beiträge

- 508

Wenn es nach den Herstellern ginge, dann würden wir jedes Jahr einige Tausend Euro für aktuelle Hardware ausgeben müssen. Und Afrika würden wir-dank dem entsprechenden Abkommen - mit Elektronik- Schrott zumüllen.

massaker

Commander

- Registriert

- Mai 2012

- Beiträge

- 2.125

Ja, habe fast alle Serien und Ausführungen -> funktionieren wie sie sollen und auch die Tools/Updates funktionieren einwandfrei.AthlonXP schrieb:(Optane) ohne Probleme unter Windows 11 erkannt und sind betriebsbereit?

Ähnliche Themen

- Antworten

- 28

- Aufrufe

- 5.130

- Antworten

- 162

- Aufrufe

- 17.768

- Antworten

- 109

- Aufrufe

- 15.065

- Antworten

- 48

- Aufrufe

- 9.212