Ich habe mal ein wenig nachgeschaut, wo der Sweetspot für Performance und Performance/Watt für meine GPU in Cyberpunk 2077 und Shadow of the Tomb Raider ist.

Systemeckdaten: Ryzen 7 5800X, 144Hz 3440x1440 Display - ich warte auf ein gutes 40" 4K QD-OLED Panel

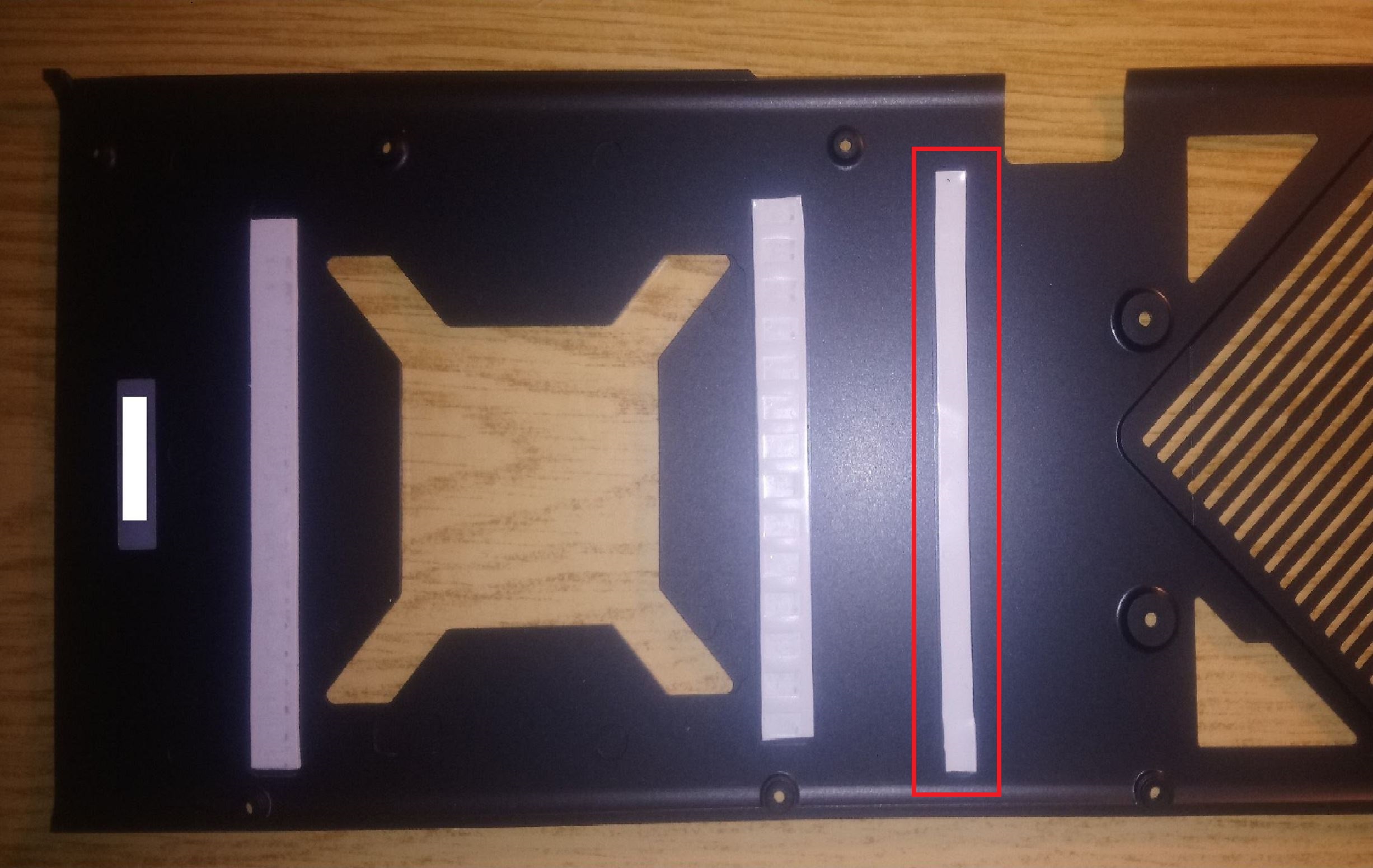

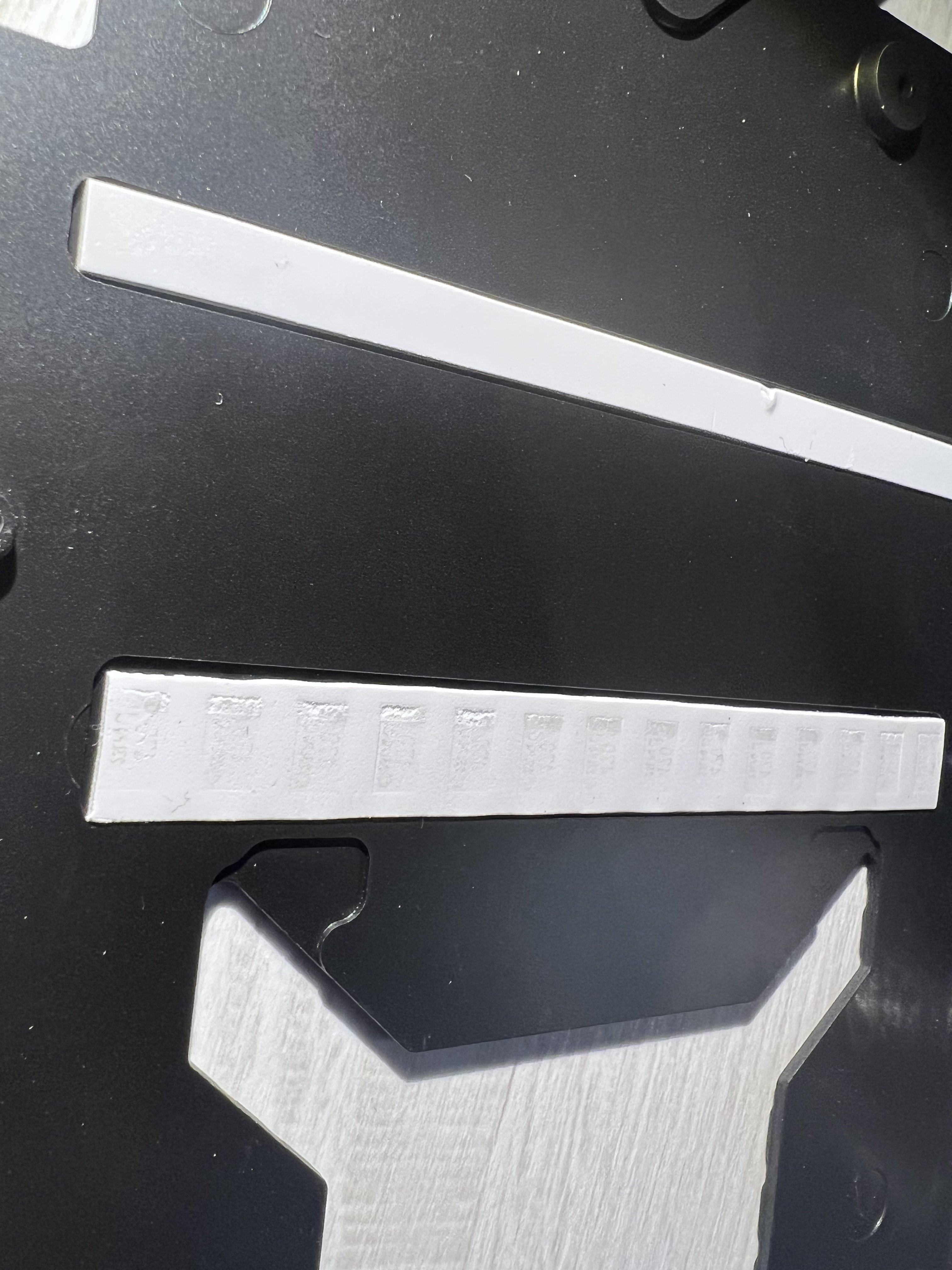

Einstellung der GPU*: +250MHz Core Clock, +1250MHz Mem Clock, Custom WaKü mit Fullcover Block

Es handelt sich im Detail um eine

Zotac Gaming GeForce RTX 4090 AMP Extreme AIRO

Die Messungen sind 'schnell' gemacht worden, daher keine Details zu den Settings weil Reproduzierbarkeit durch andere war kein Kriterium...

Meine Messwerte:

| Einstellung | MHz in CP77 | W in CP77 | FPS in CP77 | % von Stock | FPS/W in CP77 | FPS in SOTR Menü | W in SOTR Menü | % von Stock | FPS/W im SOTR Menü | minFPS in SOTR Bench | % von Stock | minFPS/W in SOTR |

| stock | 2760 | 385 | 150 | 100,0 | 0,39 | 341 | 396 | 100,0 | 0,86 | 215 | 100,0 | 0,54 |

| stock+memOC | 2760 | 390 | 153 | 102,0 | 0,39 | 351 | 405 | 102,3 | 0,87 | 220 | 102,3 | 0,54 |

| OC - 100% PT | 3000 | 400 | 156 | 104,0 | 0,39 | 357 | 400 | 101,0 | 0,89 | 231 | 107,4 | 0,58 |

| OC - 90% PT | 3000 | 390 | 153 | 102,0 | 0,39 | 355 | 395 | 99,7 | 0,90 | 231 | 107,4 | 0,58 |

| OC - 85% PT | 2970 | 380 | 152 | 101,3 | 0,40 | 353 | 381 | 96,2 | 0,93 | 232 | 107,9 | 0,61 |

| OC - 80% PT | 2910 | 356 | 150 | 100,0 | 0,42 | 348 | 373 | 94,2 | 0,93 | 231 | 107,4 | 0,62 |

| OC - 75% PT | 2880 | 335 | 148 | 98,7 | 0,44 | 341 | 340 | 85,9 | 1,00 | 231 | 107,4 | 0,68 |

| OC - 70% PT | 2775 | 315 | 145 | 96,7 | 0,46 | 338 | 312 | 78,8 | 1,08 | 230 | 107,0 | 0,74 |

| OC - 65% PT | 2670 | 295 | 142 | 94,7 | 0,48 | 330 | 298 | 75,3 | 1,11 | 230 | 107,0 | 0,77 |

| OC - 60% PT | 2580 | 270 | 138 | 92,0 | 0,51 | 311 | 271 | 68,4 | 1,15 | 225 | 104,7 | 0,83 |

| OC - 55% PT | 2310 | 245 | 131 | 87,3 | 0,53 | 280 | 248 | 62,6 | 1,13 | 218 | 101,4 | 0,88 |

| OC - 50% PT | 1845 | 225 | 118 | 78,7 | 0,52 | 250 | 230 | 58,1 | 1,09 | 194 | 90,2 | 0,84 |

| OC - 45% PT | 1545 | 202 | 104 | 69,3 | 0,51 | 216 | 205 | 51,8 | 1,05 | 156 | 72,6 | 0,76 |

| OC - 40% PT | 1230 | 180 | 89 | 59,3 | 0,49 | 181 | 184 | 46,5 | 0,98 | 128 | 59,5 | 0,70 |

Die besten FPS/Watt bekomme ich im Bereich von 55% bis 60%, allerdings verliere ich da so langsam schon einiges von der Rohleistung der Karte.

Unterhalb von 55% rutschen die min-FPS im Shadow of the Tomb Raider Bench, die mit Overclock anscheinend ins CPU-Limit geraten, massiv ab. Niedriger als 55% Powertarget ist also keine gute Idee. Außerdem hätte ich da auch direkt eine kleinere und günstigere Karte kaufen können...

Während der Heizsaison werde ich vermutlich bei meiner bisherigen Einstellung von 75% PT bleiben. Im Sommer kann ich mir durchaus vorstellen, auf 60% runter zu gehen, wenn's im Raum warm wird.

*Bezüglich der OC-Einstellung: Ja, ich habe tatsächlich nur über die Slider die Clocks und das Power Limit angepasst. Begründung:

- Der OC-Scanner bringt mein Netzteil jedesmal zur Notabschaltung. Das Seasonic 600W Titanium Fanless mag im Gaming-Betrieb kein Problem sein, aber der OC-Scanner ruft irgendeinen Zustand ab, der dem Netzteil nicht schmeckt.

- Ich hatte es auch mal mit dem Curve-Editor versucht, aber dann kackt der GPU-Videotakt ab, wie im Video vom Startpost auch beschrieben, und außerdem waren die versuchten Betriebszustände (primär 2745MHz@925mV) nicht komplett stabil, aber dabei in FPS und FPS/W nicht wirklich besser als meine jetzige Einstellung mit entsprechend angepasstem Powertarget.

In Cyberpunk 2077 ist somit bei 75% PT mein primärer Betriebspunkt bei 2880MHz@995mV, als Änderung zum Werkszustand mit 2760MHz@1045mV.

3000MHz erreicht die GPU bei 1060mV und ich habe die zwischendurch kurz bei 3015MHz gesehen, aber allgemein nicht höher als durchgehend 3000MHz, auch wenn das Powerlimit noch Platz hat.

Ein golden Sample ist das nicht umbedingt, aber ich glaube, ich kann mich nicht beschweren.