Masterchief79

Captain

- Registriert

- Juni 2009

- Beiträge

- 3.261

Hallo liebe CB'ler,

statt den Grafikkarten-Bilderthread weiterhin mit nicht-jugendfreien Bildern von zersägten Platinen, höchst unzulässigen Kühllösungen und frevelhaften Voltmod-Experimenten zuzuspammen, eröffne ich stattdessen hiermit meinen eigenen Graka- und Hardware-Blog.

Ich habe mein Hardware-Hobby wieder stärker denn je aufgenommen, und die Idee ist, meine Fortschritte und Erkentnisse hier zu dokumentieren und Ideen, Erfolge und Fehlschläge offen mit euch zu diskutieren.

Kurz zu meinem Hintergrund: Ich heiße Niklas, bin 29 Jahre alt und komme ursprünglich aus der Extreme-OC-Szene des PCGHX. Ich habe neben einigen LN2-Events zahllose Bench-Sessions mit Trockeneis- und Kompressorkühlung hinter mir. Besonders hat es mir zur Zeit "Legacy 3D" angetan, also mit älteren Grafikkarten auf aktuellem Unterbau in Windows XP so hohe 3DMark Scores wie möglich rauszuholen. Außerdem rutsche ich immer weiter in das "Rabbit Hole" der Grafikkarten-Reparaturen.

Aktuell bin ich für das Overclock.net-Team unterwegs - hier geht es zu meinem HWBot-Profil: https://hwbot.org/user/masterchief79/

Doch lassen wir Bilder sprechen, die Interessierte hoffentlich auf den Ton des Ganzen einstimmen:

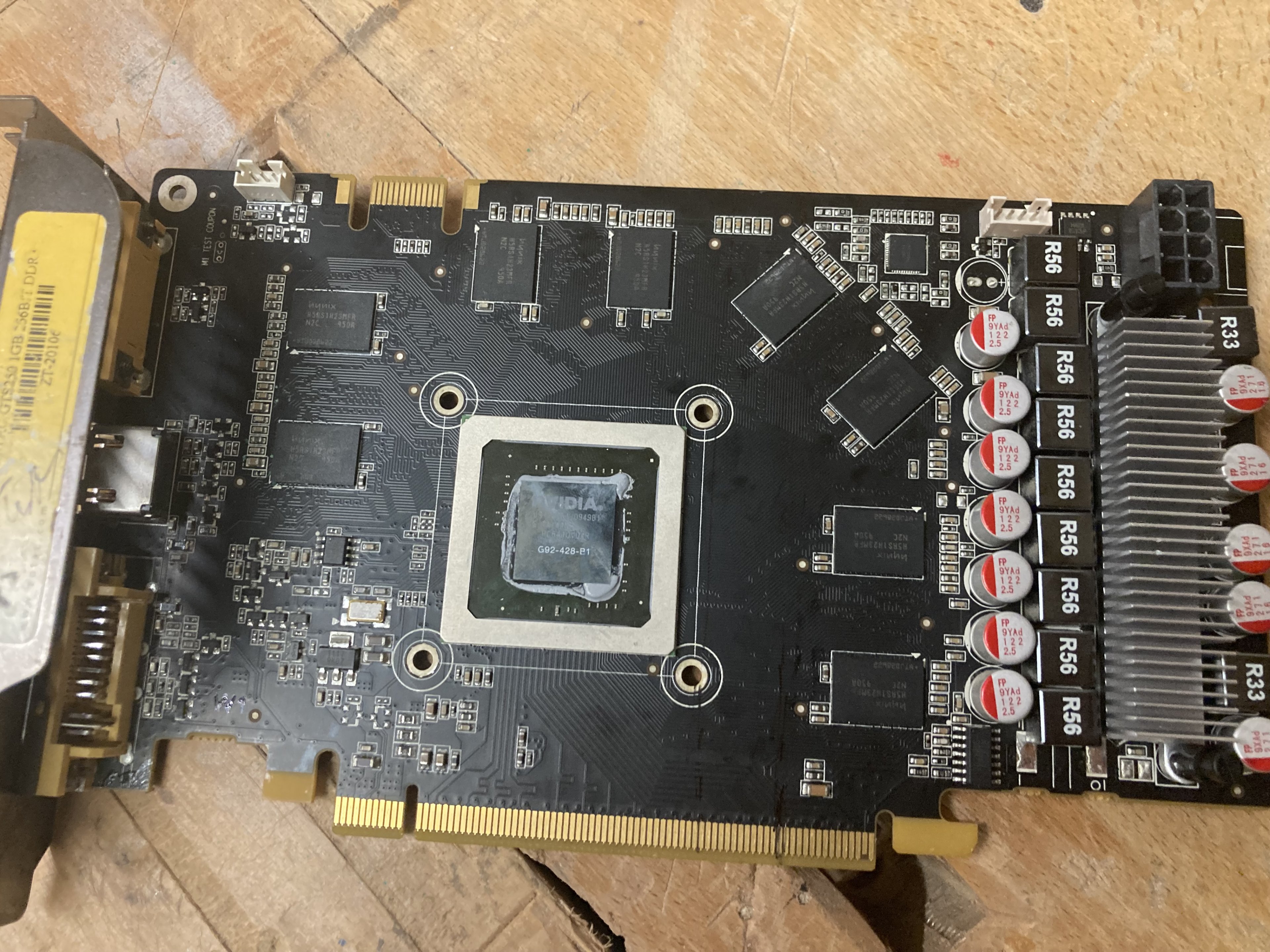

GTS250 ePower-Projekt

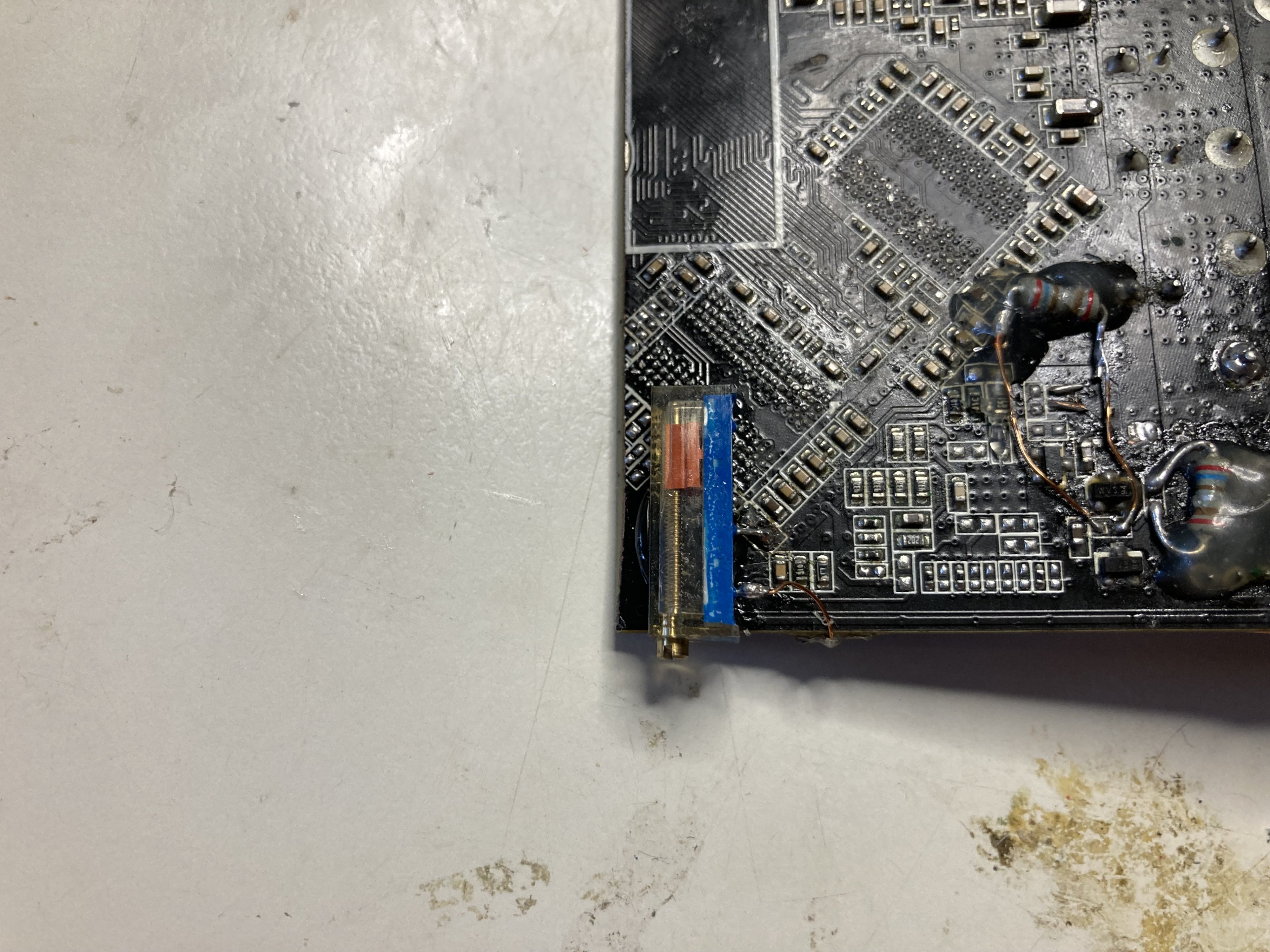

Das hier ist ein kleines Projekt, dem ich mich über die Feiertage angenommen habe. Ich habe hier eine ziemlich defekte Zotac GTS250 mit potenten und funktionsfähigen Spannungswandlern (VRM). Sie hat starke Beschädigungen durch Korrosion - ich hab gelernt, was Lötfett mit der Zeit veranstaltet, wenn man es nicht saubermacht - und einen Kratzer durch mehrere Schichten direkt hinter der GPU.

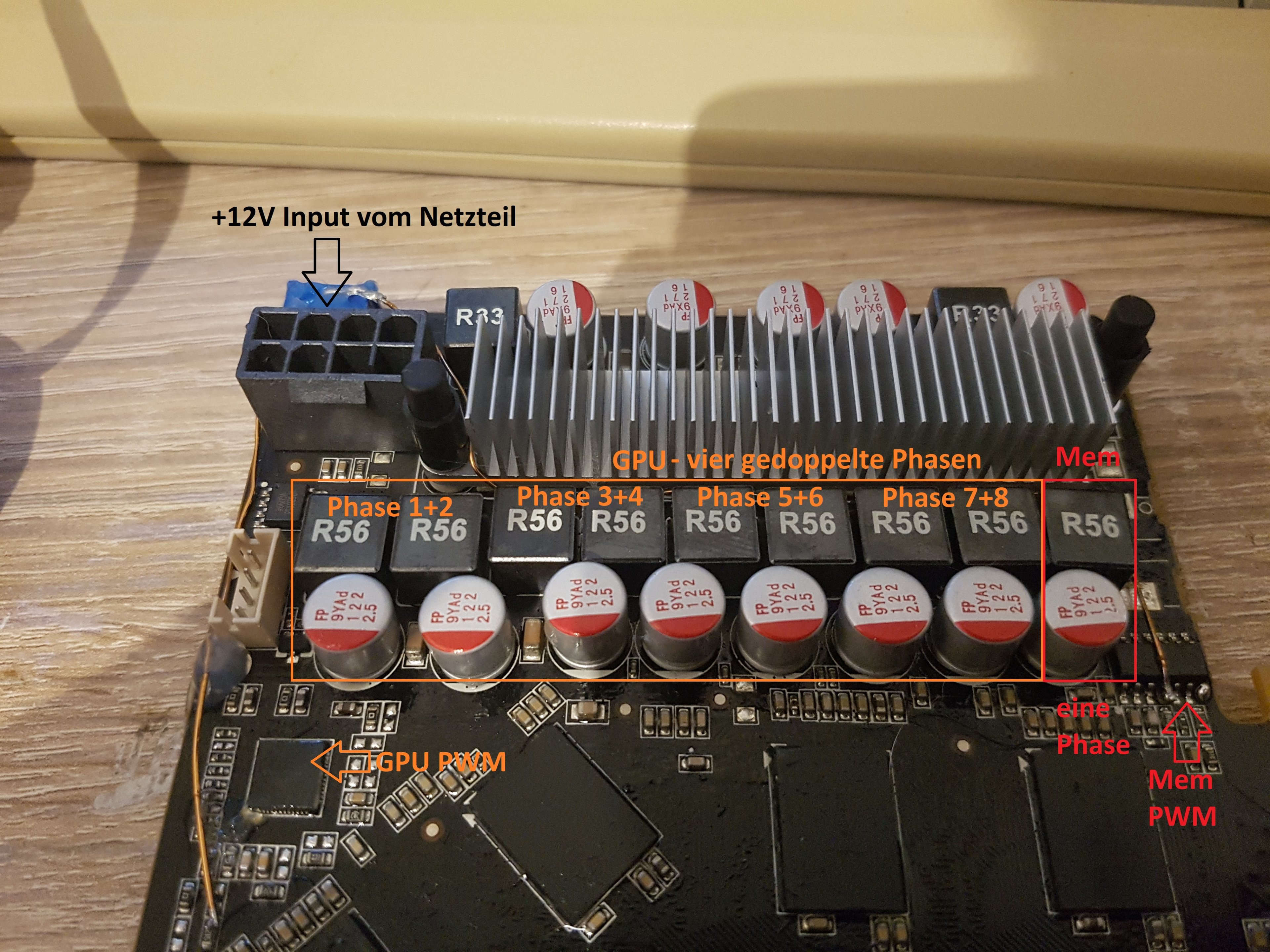

Es lohnt sich nicht wirklich, weitere Reparaturversuche anzustellen (vor allem, da ich ein zweites baugleiches Modell schon durchgebencht habe). Es wäre aber schade um die hochwertige Stromversorgung mit 8 GPU-Phasen. Meine Idee ist daher folgende: Ich baue mir hierdraus eine ePower-Platine, die ich auf jede beliebige Grafikarte löten kann, und die an die Stelle des hauseigenen GPU-VRM tritt. Obwohl ich mir schon früher solche "Zombies" gebaut habe, wird dieser Versuch der erste, der ohne Tutorial oder Vorlage erfolgt.

Warum wäre das fürs Extreme-OC überhaupt nützlich?

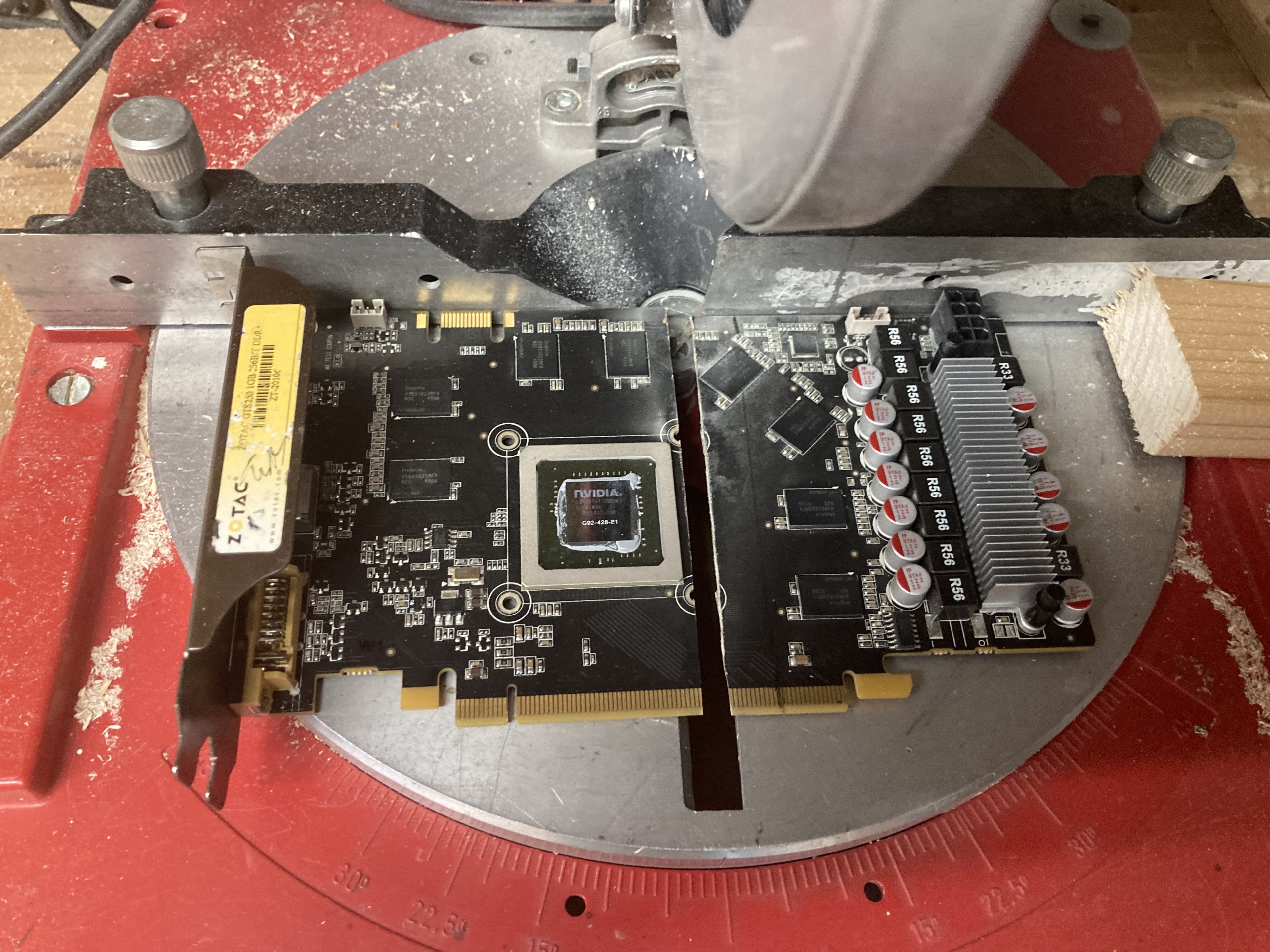

(Eine Kappsäge zählt zu den wichtigsten Werkzeugen des modernen Overclockers!)

(Eine Kappsäge zählt zu den wichtigsten Werkzeugen des modernen Overclockers!)

Anschließend wird die Sägekante durch vorsichtiges Schleifen von Grat gesäubert und mit Plastik70-Spray gegen äußere Einflüsse geschützt.

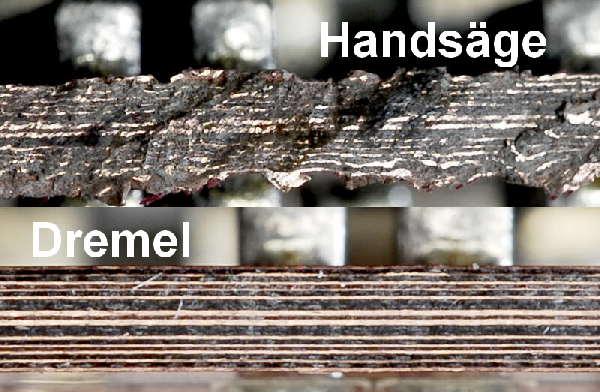

Danke an loopy83 im HWLuxx für dieses Bild! (Quelle)

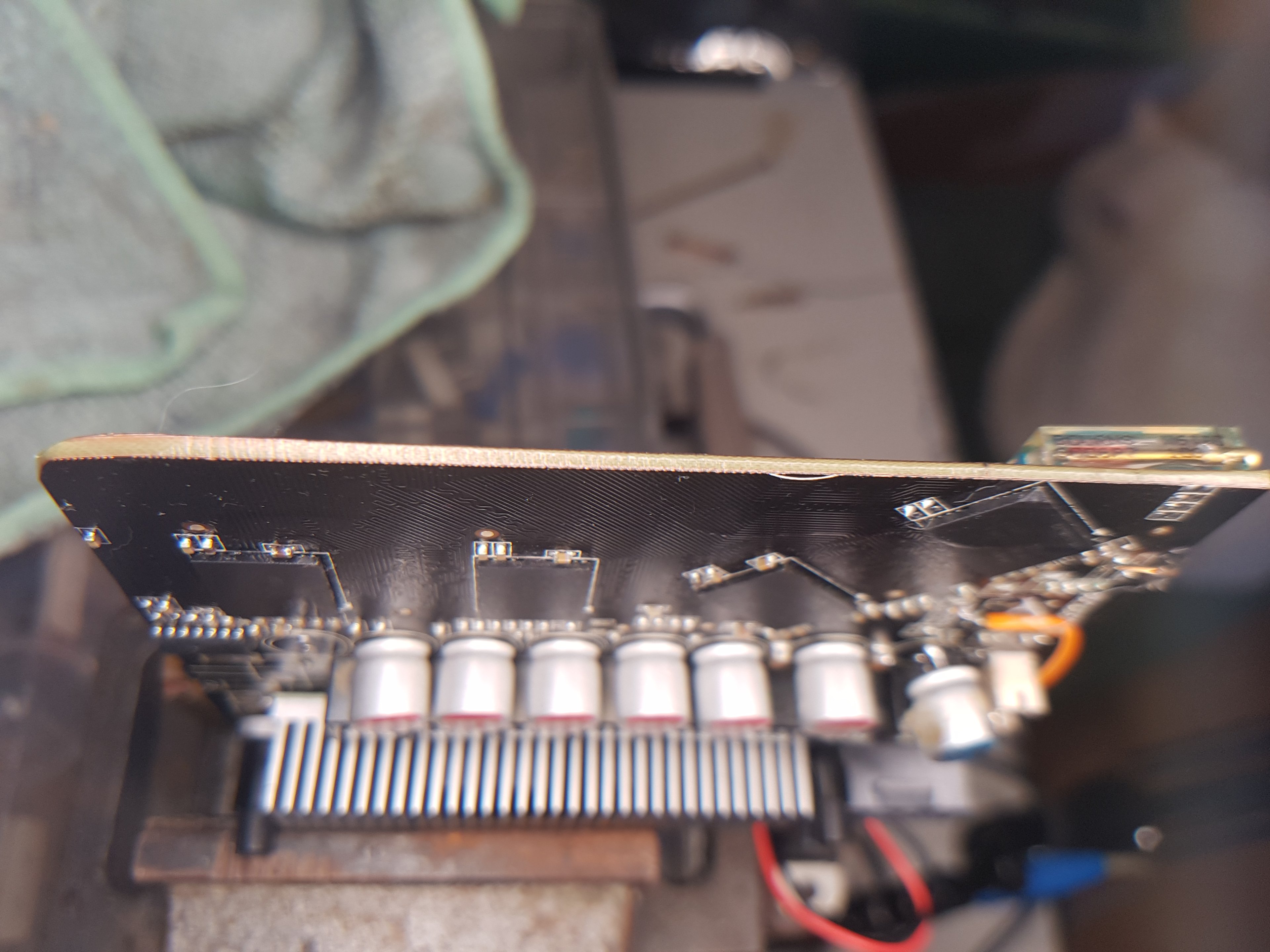

Besonders wichtig ist, dass wir jetzt keine Kurzschlüsse haben! Davon entstehen beim Sägen so einige, da die verschiedenen Lagen an der Sägekante Kontakt untereinander, und auch zur Masse bekommen. Ein Graka-PCB hat üblicherweise zwischen 8 und 14 Schichten, davon bspw. zwei für Masse, vier für die Stromversorgung und den Rest für "Data-Lines".

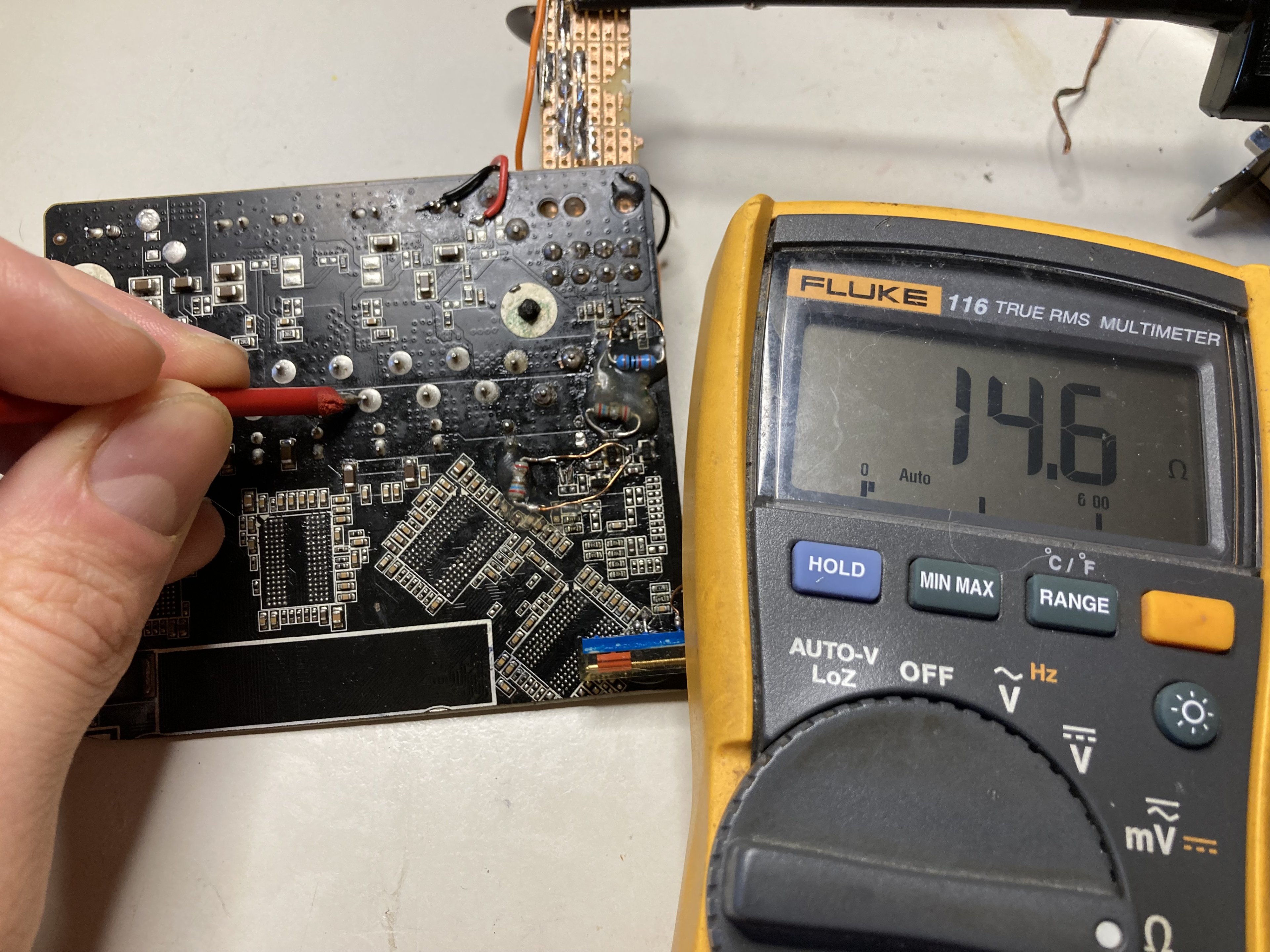

Glücklicherweise sind 15 Ohm größer als 0 Ohm, von daher können wir weitermachen. Interessanterweise scheint meine GTS250 zumindest in diesem Bereich nur vier Schichten zu haben, zwei oben und zwei unten. Der Rest des PCBs ist "blank".

Ich habe der Platine testweise 12V an dem 8 Pin Stecker gegeben, und sie hat keinen Mucks gemacht. Das ist in diesem Fall als voller Erfolg zu werten, da nichts explodiert ist!

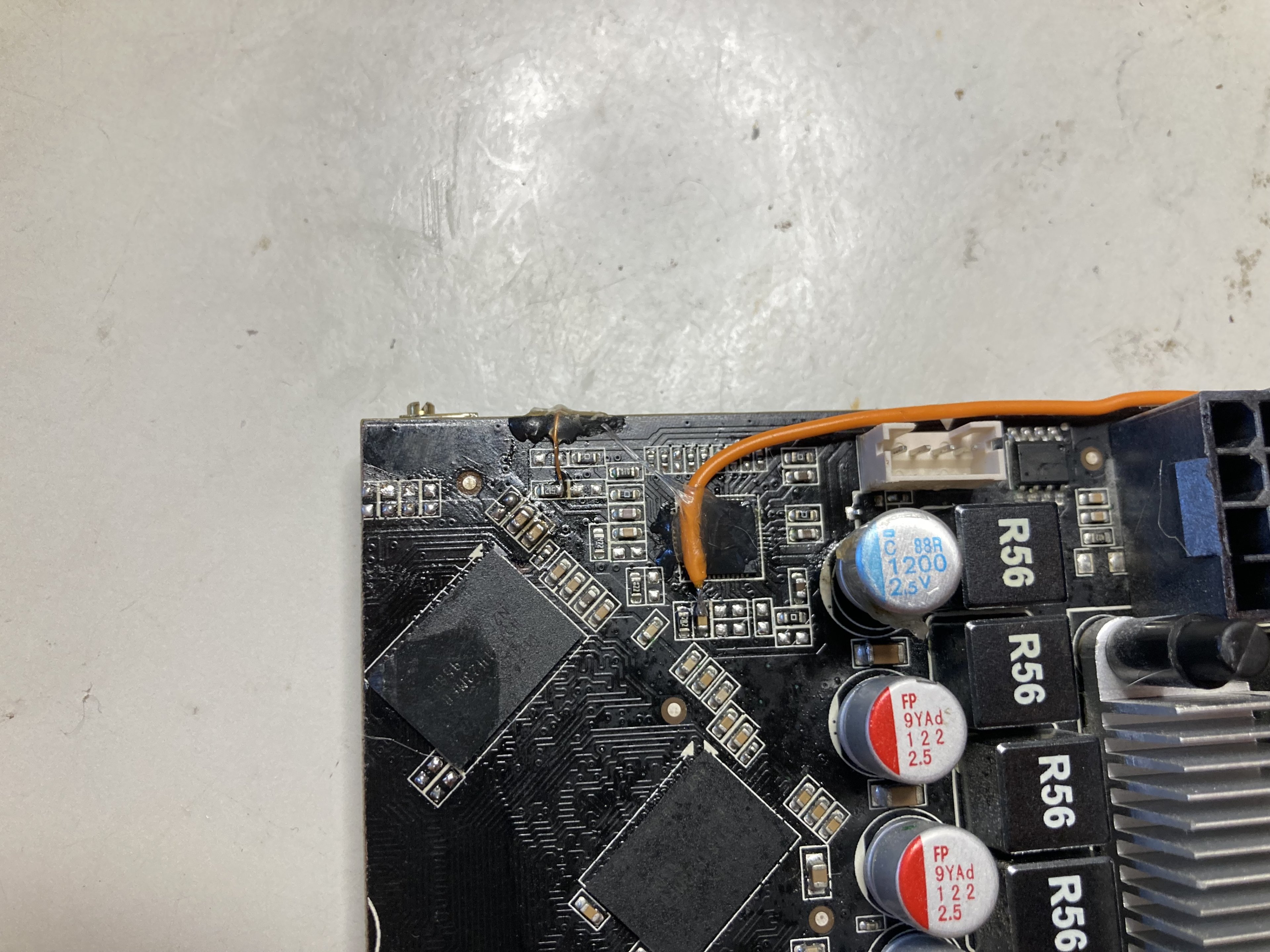

Scherz beiseite - der VRM wird von einem uP6206 4-Phase PWM Controller gesteuert, der das "Gehirn" des Ganzen ist. Das Gehirn braucht zum Denken aber 5V, die wir vorhin uncharmant abgesägt haben. Wir haben als Input auf der ePower-Platine aktuell nur 12V vom 8 Pin, daher habe ich mir eine kleine Schaltung gebastelt (die nicht schön aussieht, aber funktioniert). Die 5V werden aus einem 7805 Mosfet erzeugt, der noch zwei Elkos zur Glättung zur Seite hat. Das orangene Kabel führt zum "5VCC" Input des PWM Controllers, der damit wieder Saft hat.

Der Kupferlackdraht, der links daneben angeschlossen ist, geht an einen 10KOhm Poti, der auf der Rückseite sitzt. Das ist der klassische Voltmod für diese Platine, hierüber kann ich dann die ausgegebene Spannung regeln.

Funktionstest: Es lebt!

Ich war positiv überrascht, denn die 5V am PWM Controller haben direkt gereicht, damit das Ding tut, was es soll: Spannung ausgeben. Ich hatte damit gerechnet, mich noch mit Powergood (PWRGD) bzw. Enable (EN)-Signalen rumschlagen zu müssen, was bei diesem Modell aber zum Glück nicht der Fall war.

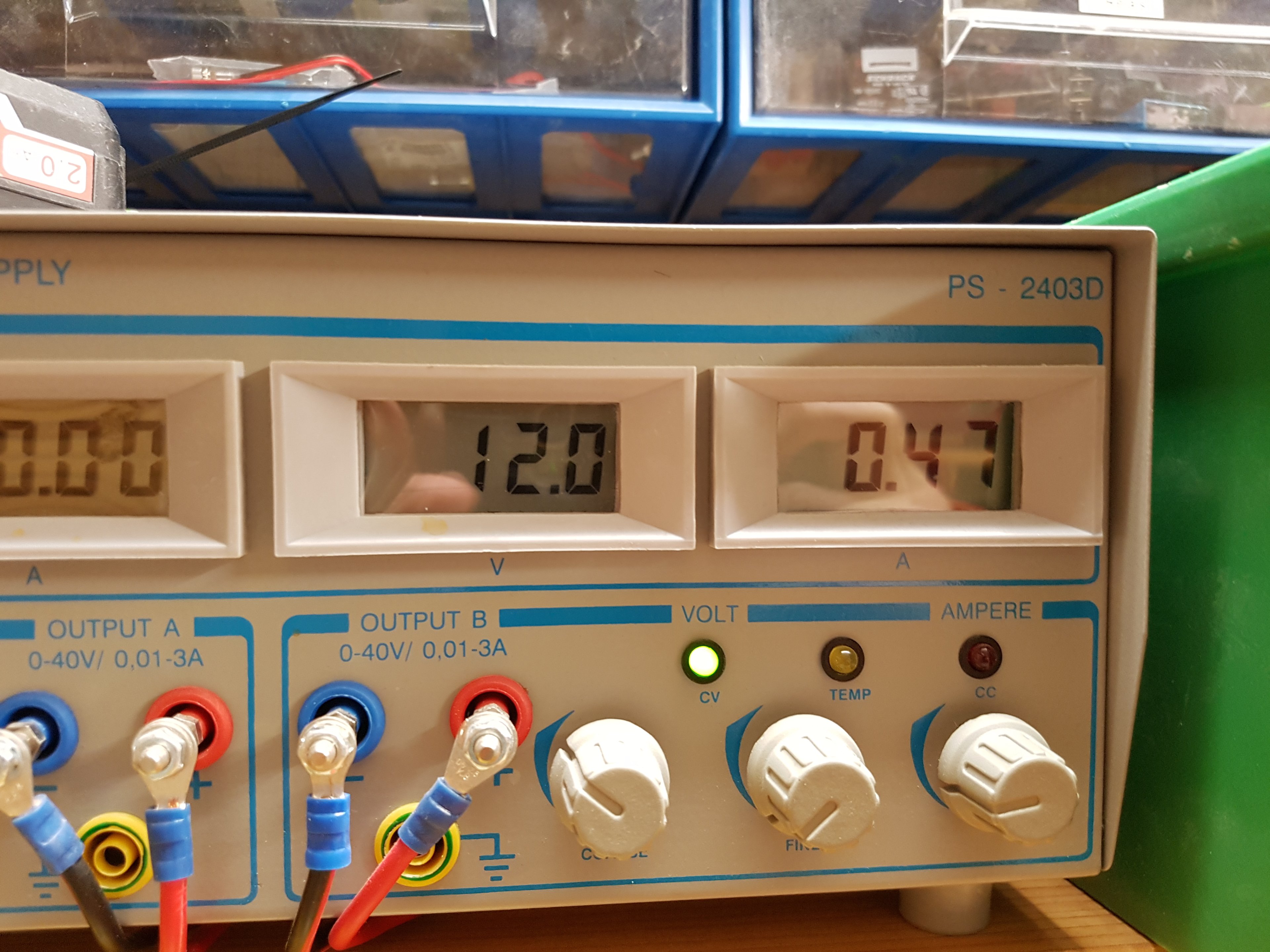

Für den Funktionstest habe ich das Board an einem Labornetzteil angeschlossen. Das ist zum Testen sicherer und praktischer. Ohne angeschlossenen Verbraucher (die GPU ist ja nicht mehr vorhanden) zieht das Board 470mA.

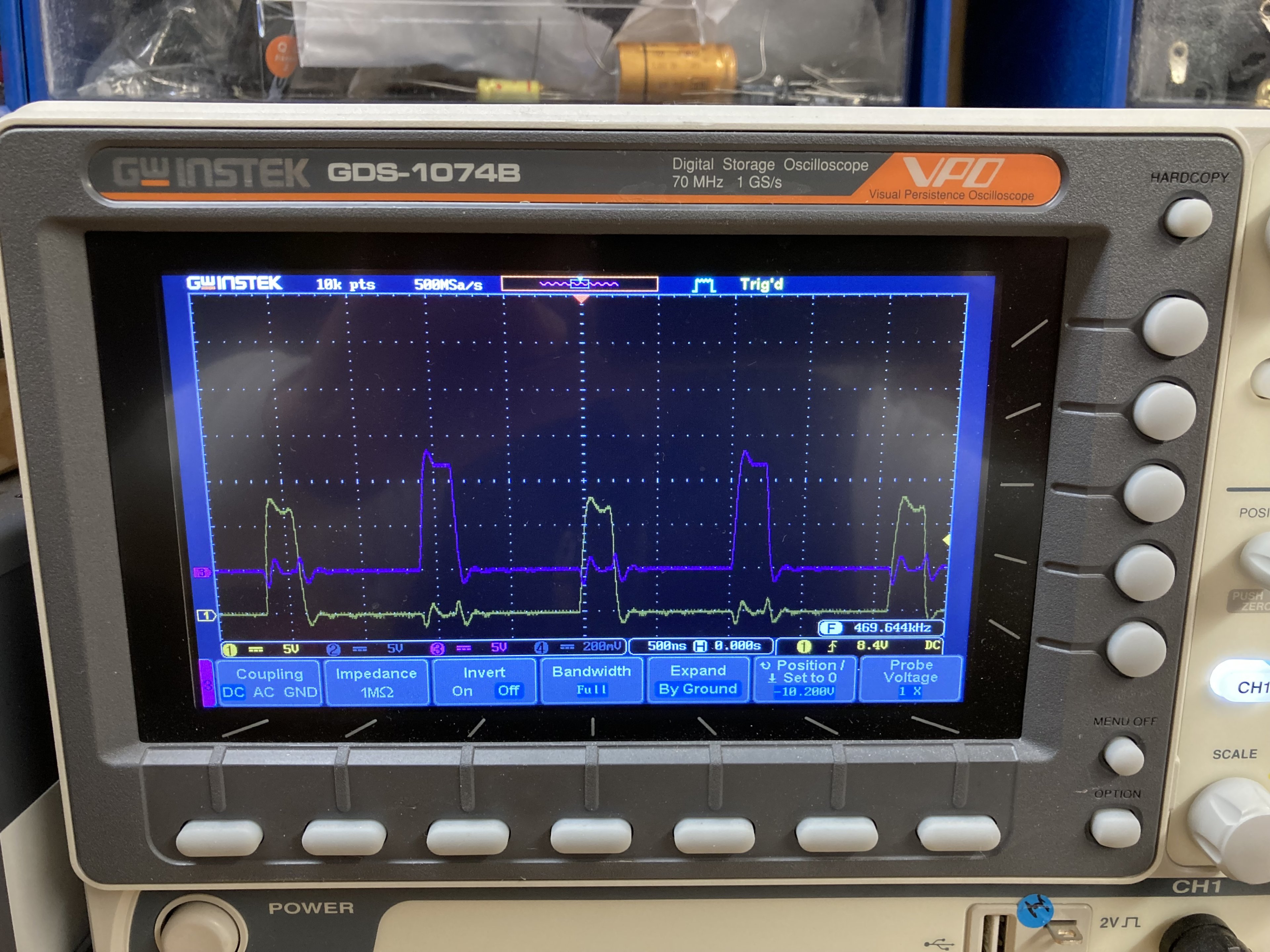

Und so sieht PWM auf dem Oszilloskop aus. (Besuche bei den Eltern haben auch immer den Vorteil, dass man auf eine gut ausgestattete Werkstatt zurückgreifen kann! )

)

Wir haben hier zwei verschiedene Phasen angeschlossen. Kurze Erklärung, wie euer VRM überhaupt funktioniert:

Die GPU braucht zwischen 1 und 1,5V, der PWM-Controller hat aber nur 12V zur Verfügung. Er "taktet" er die 12V dafür kurz an (das sind die Spitzen auf dem Bild). In den Spulen baut sich ein Magnetfeld auf, dass über Induktion die stabile Ausgangsspannung erzeugt, die wir für die GPU brauchen. Damit das funktioniert, muss der Controller unheimlich schnell "feuern", in diesem Fall mit 470kHz. Wenn ich das richtig verstanden habe, sind das 470.000 Einschaltvorgänge pro Sekunde - und das pro Phase!

Mithilfe des Oszis haben wir auch rausgefunden, dass jeweils zwei Phasen gleichzeitig angetaktet werden. Das bedeutet, dass die gedoppelt ausgeführt sind - was auch Sinn macht, weil der PWM Controller nur 4 Phasen steuern kann.

Das "Feuern" kann man sich wie die Zündreihenfolge beim Verbrennungsmotor vorstellen, nur dass der PWM Controller einfach der Reihe nach vorgeht (1/2 - 3/4 - 5/6 - 7/8). Im Vierzylinder wäre es üblicherweise 1-3-4-2.

Damit ist das Board jetzt an sich einsatzbereit, wären da nicht...

Komplikationen mit der Mem-Phase

Zuerst wollte ich die Mem-Phase auch funktionsfähig halten. Der Mem PWM IC braucht nur 12V als Versorgungsspannung, weswegen ich eigentlich davon ausgegangen bin, dass das kein Problem sein sollte. Es sieht aber so aus, als würde der seine 12V nicht vom 8 Pin, sondern vom PCI-E Slot beziehen. Als ich dann versucht habe, das vom 8 Pin auf den IC zu brücken, hatte ich kurzzeitig 4V Ausgangsspannung auf dem Speicher, also viel zu viel!

Ich habe dann noch ein wenig probiert, das ganze war mir dann aber doch zu heikel - also die Mem-Phase einfach ausgelötet.

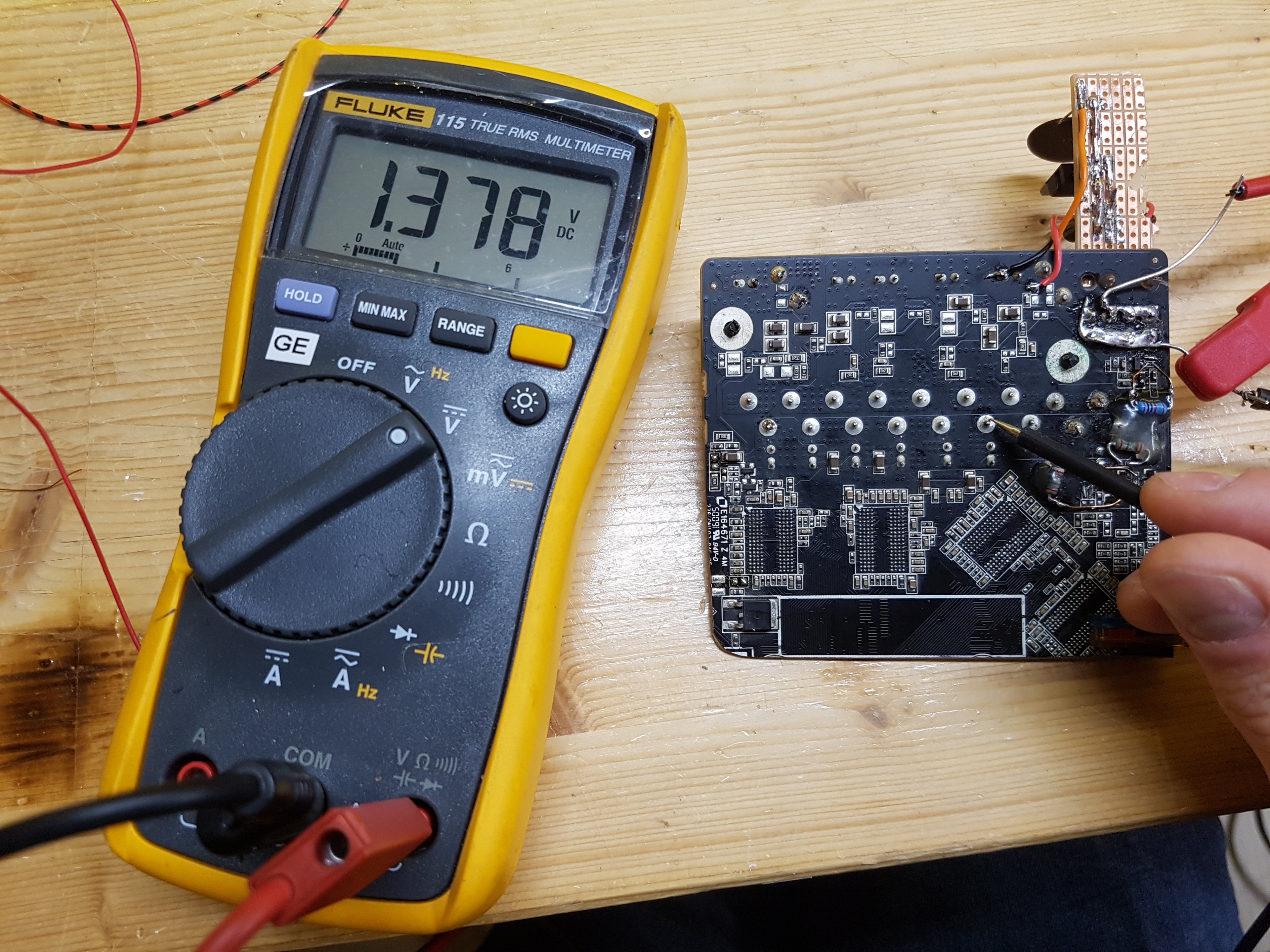

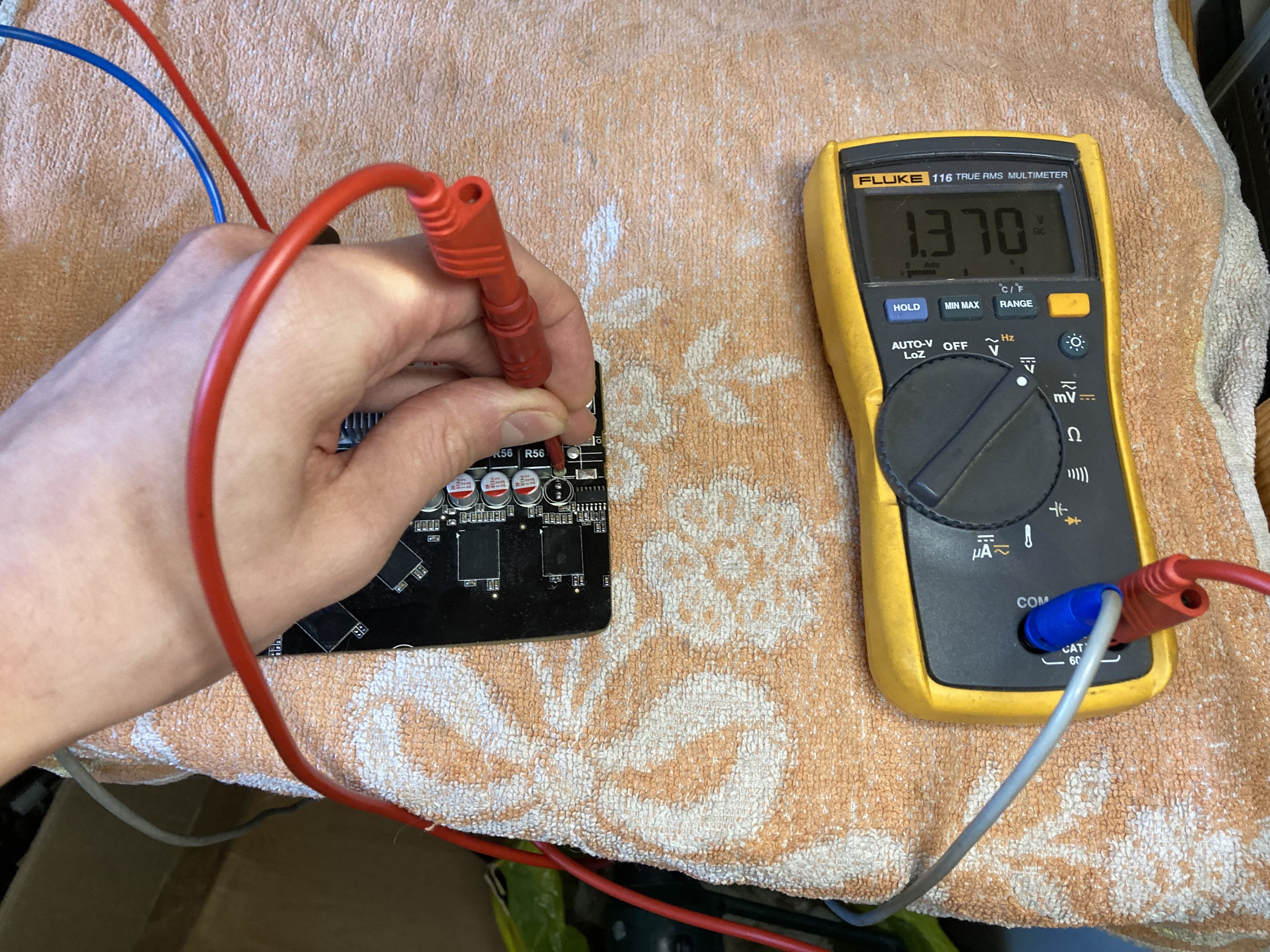

Das komische ist, dass sich die GPU-Spannung auf die Mem-Phase zu übertragen scheint. Trotz ausgelöteter Spule kommen 1,37V auf der Mem-Phase und auch am Speicher an.

Auch der Durchgangswiderstand von knapp 15 Ohm von oben war ursprünglich deutlich höher. Da gehen die Alarmglocken an. Hier muss irgendwo in der Platine eine Verbindung entstanden sein, die da nicht hingehört. Meine Vermutung liegt auf den Ram-Chips.

Bevor ich das Board auf einer Karte teste, werde ich noch den Mem-IC und die vier Ram-Chips auslöten, und dann heißt es Daumen drücken! Vielleicht teste ich das ganze auch erst mit Lastwiderständen, das überlege ich mir noch.

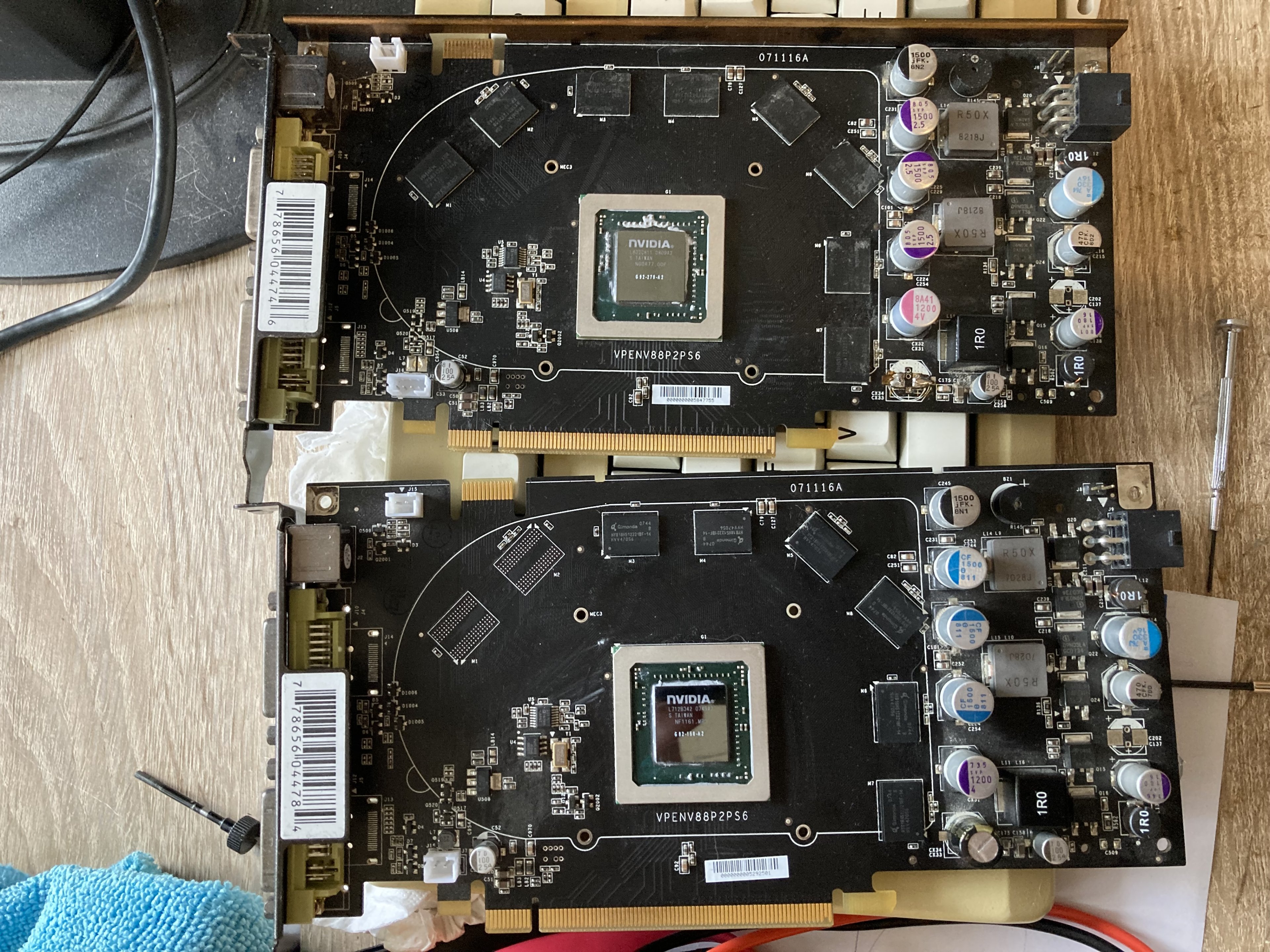

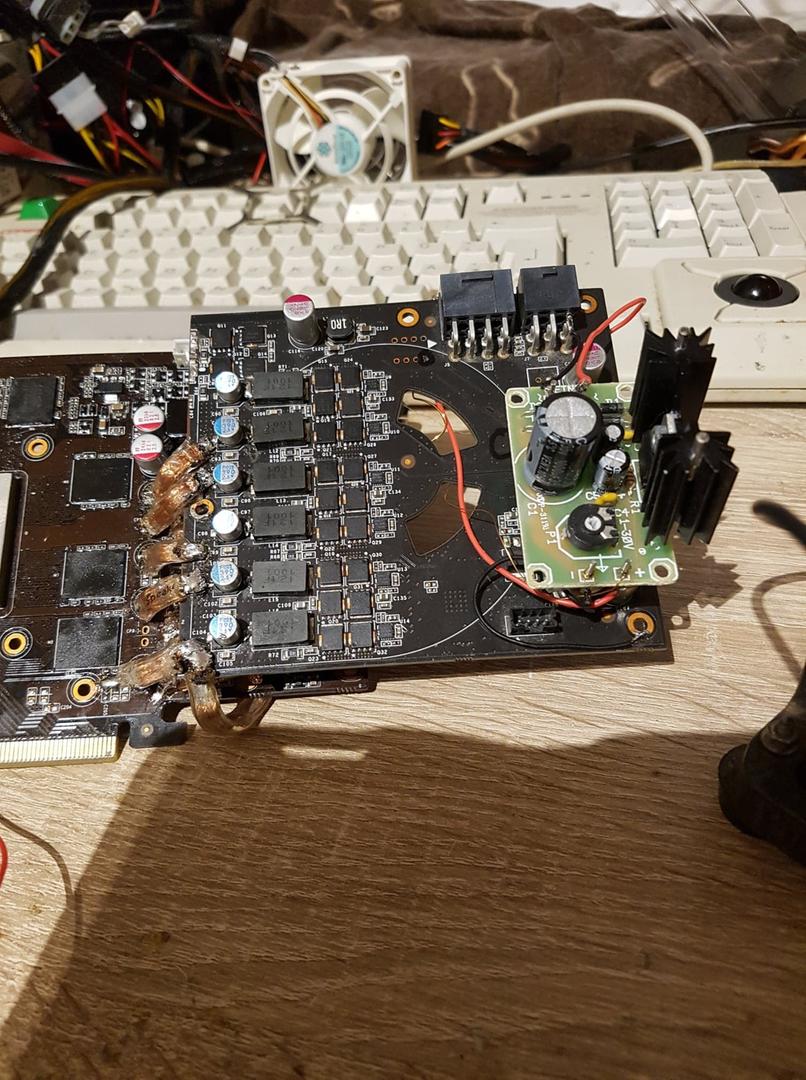

Und zu guter Letzt noch ein Bild von meiner GTX560 mit dem VRM einer GTX480 im Huckepack - so oder so ähnlich könnte das ganze mit dem GTS250 Power Board auch aussehen.

Falls ihr Fragen zum Projekt oder allgemein, oder irgendwelche Rückmeldung habt, lasst gerne einen Kommentar da. Ich lerne durch solche Experimente zwischen Genie und Wahnsinn unheimlich viel, habe aber auch noch unheimlich viel zu lernen. Wenn es dann am Ende auch noch funktioniert, umso besser!

Weitere Projekte meinerseits beschäftigen sich aktuell viel mit der Diagnose und Reparatur von defekten Grafikkarten, hier dürft ihr auf jeden Fall auch noch ein paar Posts erwarten.

So long und danke fürs Lesen,

Niklas

statt den Grafikkarten-Bilderthread weiterhin mit nicht-jugendfreien Bildern von zersägten Platinen, höchst unzulässigen Kühllösungen und frevelhaften Voltmod-Experimenten zuzuspammen, eröffne ich stattdessen hiermit meinen eigenen Graka- und Hardware-Blog.

Ich habe mein Hardware-Hobby wieder stärker denn je aufgenommen, und die Idee ist, meine Fortschritte und Erkentnisse hier zu dokumentieren und Ideen, Erfolge und Fehlschläge offen mit euch zu diskutieren.

Kurz zu meinem Hintergrund: Ich heiße Niklas, bin 29 Jahre alt und komme ursprünglich aus der Extreme-OC-Szene des PCGHX. Ich habe neben einigen LN2-Events zahllose Bench-Sessions mit Trockeneis- und Kompressorkühlung hinter mir. Besonders hat es mir zur Zeit "Legacy 3D" angetan, also mit älteren Grafikkarten auf aktuellem Unterbau in Windows XP so hohe 3DMark Scores wie möglich rauszuholen. Außerdem rutsche ich immer weiter in das "Rabbit Hole" der Grafikkarten-Reparaturen.

Aktuell bin ich für das Overclock.net-Team unterwegs - hier geht es zu meinem HWBot-Profil: https://hwbot.org/user/masterchief79/

Doch lassen wir Bilder sprechen, die Interessierte hoffentlich auf den Ton des Ganzen einstimmen:

GTS250 ePower-Projekt

Das hier ist ein kleines Projekt, dem ich mich über die Feiertage angenommen habe. Ich habe hier eine ziemlich defekte Zotac GTS250 mit potenten und funktionsfähigen Spannungswandlern (VRM). Sie hat starke Beschädigungen durch Korrosion - ich hab gelernt, was Lötfett mit der Zeit veranstaltet, wenn man es nicht saubermacht - und einen Kratzer durch mehrere Schichten direkt hinter der GPU.

Es lohnt sich nicht wirklich, weitere Reparaturversuche anzustellen (vor allem, da ich ein zweites baugleiches Modell schon durchgebencht habe). Es wäre aber schade um die hochwertige Stromversorgung mit 8 GPU-Phasen. Meine Idee ist daher folgende: Ich baue mir hierdraus eine ePower-Platine, die ich auf jede beliebige Grafikarte löten kann, und die an die Stelle des hauseigenen GPU-VRM tritt. Obwohl ich mir schon früher solche "Zombies" gebaut habe, wird dieser Versuch der erste, der ohne Tutorial oder Vorlage erfolgt.

Warum wäre das fürs Extreme-OC überhaupt nützlich?

- Gerade viele ältere Grafikkarten haben nur eine oder zwei Phasen für die GPU, was das Übertaktungspotenzial einschränkt. Bei starkem OC und OV wird die Spannung schnell instabil und schwankt dann schonmal um 50mV - siehe obiges Bild von XFX 8800GT und GS. GTX200er-Karten sind andererseits bekannt dafür, schon bei leichtem OV ohne Vorwarnung Elkos im Tiefflug durch den Raum zu schießen, was jetzt auch nicht unbedingt vorteilhaft ist.

- Andere Karten haben gar nicht erst einen Stromstecker, und ziehen ihre gesamte Leistung über den PCI-E Slot. In dem Fall würde eine ePower-Platine in erster Linie mein Mainboard schützen.

- Manche Karten haben PWM Controller mit ärgerlichen Schutzmechanismen, die schnell Nein sagen, wenn man versucht, am Rädchen zu drehen.

(Beispiel NCP5388, NCP5395). Derartige Logik würde man durch eine ePower-Platine komplett umgehen.

(Beispiel NCP5388, NCP5395). Derartige Logik würde man durch eine ePower-Platine komplett umgehen.

Anschließend wird die Sägekante durch vorsichtiges Schleifen von Grat gesäubert und mit Plastik70-Spray gegen äußere Einflüsse geschützt.

Danke an loopy83 im HWLuxx für dieses Bild! (Quelle)

Besonders wichtig ist, dass wir jetzt keine Kurzschlüsse haben! Davon entstehen beim Sägen so einige, da die verschiedenen Lagen an der Sägekante Kontakt untereinander, und auch zur Masse bekommen. Ein Graka-PCB hat üblicherweise zwischen 8 und 14 Schichten, davon bspw. zwei für Masse, vier für die Stromversorgung und den Rest für "Data-Lines".

Glücklicherweise sind 15 Ohm größer als 0 Ohm, von daher können wir weitermachen. Interessanterweise scheint meine GTS250 zumindest in diesem Bereich nur vier Schichten zu haben, zwei oben und zwei unten. Der Rest des PCBs ist "blank".

Ich habe der Platine testweise 12V an dem 8 Pin Stecker gegeben, und sie hat keinen Mucks gemacht. Das ist in diesem Fall als voller Erfolg zu werten, da nichts explodiert ist!

Scherz beiseite - der VRM wird von einem uP6206 4-Phase PWM Controller gesteuert, der das "Gehirn" des Ganzen ist. Das Gehirn braucht zum Denken aber 5V, die wir vorhin uncharmant abgesägt haben. Wir haben als Input auf der ePower-Platine aktuell nur 12V vom 8 Pin, daher habe ich mir eine kleine Schaltung gebastelt (die nicht schön aussieht, aber funktioniert). Die 5V werden aus einem 7805 Mosfet erzeugt, der noch zwei Elkos zur Glättung zur Seite hat. Das orangene Kabel führt zum "5VCC" Input des PWM Controllers, der damit wieder Saft hat.

Der Kupferlackdraht, der links daneben angeschlossen ist, geht an einen 10KOhm Poti, der auf der Rückseite sitzt. Das ist der klassische Voltmod für diese Platine, hierüber kann ich dann die ausgegebene Spannung regeln.

Funktionstest: Es lebt!

Ich war positiv überrascht, denn die 5V am PWM Controller haben direkt gereicht, damit das Ding tut, was es soll: Spannung ausgeben. Ich hatte damit gerechnet, mich noch mit Powergood (PWRGD) bzw. Enable (EN)-Signalen rumschlagen zu müssen, was bei diesem Modell aber zum Glück nicht der Fall war.

Für den Funktionstest habe ich das Board an einem Labornetzteil angeschlossen. Das ist zum Testen sicherer und praktischer. Ohne angeschlossenen Verbraucher (die GPU ist ja nicht mehr vorhanden) zieht das Board 470mA.

Und so sieht PWM auf dem Oszilloskop aus. (Besuche bei den Eltern haben auch immer den Vorteil, dass man auf eine gut ausgestattete Werkstatt zurückgreifen kann!

Wir haben hier zwei verschiedene Phasen angeschlossen. Kurze Erklärung, wie euer VRM überhaupt funktioniert:

Die GPU braucht zwischen 1 und 1,5V, der PWM-Controller hat aber nur 12V zur Verfügung. Er "taktet" er die 12V dafür kurz an (das sind die Spitzen auf dem Bild). In den Spulen baut sich ein Magnetfeld auf, dass über Induktion die stabile Ausgangsspannung erzeugt, die wir für die GPU brauchen. Damit das funktioniert, muss der Controller unheimlich schnell "feuern", in diesem Fall mit 470kHz. Wenn ich das richtig verstanden habe, sind das 470.000 Einschaltvorgänge pro Sekunde - und das pro Phase!

Mithilfe des Oszis haben wir auch rausgefunden, dass jeweils zwei Phasen gleichzeitig angetaktet werden. Das bedeutet, dass die gedoppelt ausgeführt sind - was auch Sinn macht, weil der PWM Controller nur 4 Phasen steuern kann.

Das "Feuern" kann man sich wie die Zündreihenfolge beim Verbrennungsmotor vorstellen, nur dass der PWM Controller einfach der Reihe nach vorgeht (1/2 - 3/4 - 5/6 - 7/8). Im Vierzylinder wäre es üblicherweise 1-3-4-2.

Damit ist das Board jetzt an sich einsatzbereit, wären da nicht...

Komplikationen mit der Mem-Phase

Zuerst wollte ich die Mem-Phase auch funktionsfähig halten. Der Mem PWM IC braucht nur 12V als Versorgungsspannung, weswegen ich eigentlich davon ausgegangen bin, dass das kein Problem sein sollte. Es sieht aber so aus, als würde der seine 12V nicht vom 8 Pin, sondern vom PCI-E Slot beziehen. Als ich dann versucht habe, das vom 8 Pin auf den IC zu brücken, hatte ich kurzzeitig 4V Ausgangsspannung auf dem Speicher, also viel zu viel!

Ich habe dann noch ein wenig probiert, das ganze war mir dann aber doch zu heikel - also die Mem-Phase einfach ausgelötet.

Das komische ist, dass sich die GPU-Spannung auf die Mem-Phase zu übertragen scheint. Trotz ausgelöteter Spule kommen 1,37V auf der Mem-Phase und auch am Speicher an.

Auch der Durchgangswiderstand von knapp 15 Ohm von oben war ursprünglich deutlich höher. Da gehen die Alarmglocken an. Hier muss irgendwo in der Platine eine Verbindung entstanden sein, die da nicht hingehört. Meine Vermutung liegt auf den Ram-Chips.

Bevor ich das Board auf einer Karte teste, werde ich noch den Mem-IC und die vier Ram-Chips auslöten, und dann heißt es Daumen drücken! Vielleicht teste ich das ganze auch erst mit Lastwiderständen, das überlege ich mir noch.

Und zu guter Letzt noch ein Bild von meiner GTX560 mit dem VRM einer GTX480 im Huckepack - so oder so ähnlich könnte das ganze mit dem GTS250 Power Board auch aussehen.

Falls ihr Fragen zum Projekt oder allgemein, oder irgendwelche Rückmeldung habt, lasst gerne einen Kommentar da. Ich lerne durch solche Experimente zwischen Genie und Wahnsinn unheimlich viel, habe aber auch noch unheimlich viel zu lernen. Wenn es dann am Ende auch noch funktioniert, umso besser!

Weitere Projekte meinerseits beschäftigen sich aktuell viel mit der Diagnose und Reparatur von defekten Grafikkarten, hier dürft ihr auf jeden Fall auch noch ein paar Posts erwarten.

So long und danke fürs Lesen,

Niklas

Anhänge

Zuletzt bearbeitet: