Verständnisfrage: Womit hängt das eigentlich zusammen, dass die Grafikkarte (7900xt in dem Fall) unter Teillast im FPS Limit nochmal weniger verbraucht, wenn man die Taktrate manuell begrenzt, obwohl man den selben GPU Takt wie davor hat?

Beispiel: Wenn ich Kingdom come Deliverence in meiner Standard Konfig mit 3000MhZ max Takt laufen lasse, verbraucht die Karte in dem Spiel bei einem 90FPS Limit meistens um die 220 bis 240W. Die GPU Taktraten sind meistens unter 2000MhZ, in Dialogen etwas höher, aber nie mehr als ca. 2100. Wenn ich jetzt aber die Taktrate begrenze, auf beispielsweise 2300Mhz, taktet die Karte genau gleich hoch wie davor, verbraucht aber gute 50W weniger.

Dasselbe bei FIFA. Im 120fps Limit bei selber Taktrate ist der Unterschied auch locker bei 40 bis 60W, wenn ich den max GPU Takt runter setze, auf ein Limit, was die Karte im FPS Limit eh nicht erreicht, was halt richtig viel ist. Hoffe ihr versteht was ich meine

Das ist sehr gut zu wissen und war mir davor nicht klar. Hab daher jetzt auch ein Stromspar Profil erstellt. Aber ich versteh einfach nicht, wieso

die Taktraten sind gleich, kann mir nicht erklären wie der Unterschied zustande kommt, nur weil ich den Max GPU Takt auf ein Limit runter setze, was sowieso nicht erreicht wird im FPS Limit. Die Spannung war bei beiden "Tests" gleich, die hab ich erst im Nachhinein reduziert, daran liegt es nicht.

Mein neues Standard Profil sieht daher aktuell so aus:

Max GPU Takt: 2350mhz

Spannung: 1010mv

Vram: 2614mhz

Pt: +15% (braucht es hier nie, aber habe gelesen, dass das stabiler sein kann)

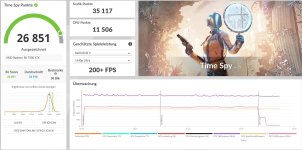

Damit habe ich +-1% die selbe Leistung einer Stock 7900xt bei ca. 20% weniger Verbrauch unter Volllast und eben wie oben beschrieben auch deutlich weniger unter Teillast. Und für den "Notfall" ja noch mein OC Profil.