ayngush schrieb:

Erzähle mir mal: Was für eine Grafikkarte hast du denn und wie spielst du denn denn und wie läuft es so?

Das System aus meiner Signatur ist soweit aktuell.

Also RTX4080 16GB von Zotac wegen der 5 Jahre Service(bietet nämlich sonst keiner weiter).

Vgl. hatte ich davor sehr lange eine 2080 8GB und da war natürlich vram permanent überlaufen.

Bei der 4080 denke ich nicht nach, es wird einfach 4k max eingestellt. Sollte das nicht passen würde ich schauen woran es liegt (man kann rein von Performance

jede Karte überlasten, inklusive einer 4090, wenn man weiß wie).

Irgendwelche Stottere,r Microstuttering, Ruckler habe ich mit der Karte noch nicht gesehen.

Bsp. Diablo 4 kann ich mich rumteleportieren soft ich mag da hängt es nie. Das ging in Diablo 4 nicht mal in FHD mit meiner alten 8GB Karte. Aber das könnte an den Optimiereungen Blizzards liegen.

ayngush schrieb:

Du hast es nicht verstanden: Ich muss dir nichts beweisen.

Da gehe ich mit.

ayngush schrieb:

Ich berichte von meinen Erfahrungen und wenn die zu deinen Informationen abweichend sind hast du zwei Möglichkeiten: Entweder du sammelst eigene Erfahrungen um meine Aussagen nachzuvollziehen oder du lässt es halt. Ich bin kein Testmagazin.

Sie sind halt zu der fachlichen und objektiv getesteten Masse nicht kompatibel.

Das heißt du kannst diese nicht auf andere projizieren.

Also deine Erfahrung das 12GB in 4K ausreichen als generelle Empfehlung ist eben nicht mehrheitsfähig.

Und da meine ich jetzt nur Magazine tests etc. nicht irgendwelche Leute die 24Gb für alle propagieren.

ayngush schrieb:

u deinen Ausführungen: 12GB VRAM reichen für 4K. Man kann damit aktuell alles spielen, manchmal muss man mit den Grafikeinstellungen halt ein wenig runter

Un schon sind wir auf einer Linie.

Sobald man Texturen eine Stufe runterregelt passt es natürlich. Leider sind diese, neben der Beleuchtung und Art-Stil, maßgeblich für die Grafik verantwortlich.

Eine 4070 Super 12GB kann halt auch nicht den Anspruch haben 4k Max flüssig darzustellen. Allerdings... Wäre NVIDIA nicht so vermessen mit dem Speicherinterface würde die Karte mit 16GB trotz des Preises zur Volkskarte werden. Den ohne bsp. RT wäre die Rohleistung in 4k gerade durch DLSS3 so enorm hoch das man es immer flüssig schaffen würde. Aber man wird dann eben am vram gebremst werden.

ayngush schrieb:

Und ob der Himmel für alle blau ist... kannst du ja gerne mal mit Menschen mit Farbwahrnehmungsstörung ausdiskutieren, tut hier übrigens auch nichts zur Sache, wie du den Himmel wahrnimmst. Blau ist er technisch betrachtet jedoch erst als Wahrnehmung im Auge des Betrachters.

Ein Mensch mit Farbstörung nimmt den Himmel anders war, korrekt.

Dennoch ist es Fakt das der Himmel auf der Erde vereinfacht gesagt blau ist (Wellenlängen des Lichts und Brechung an Atmosphäre). Der "Fehler" liegt dann in der Wahrnehmungsstörung der einzelnen Person.

Soll ich erst ein politisches Beispiel bringen wie sehr eine Wahrnehmungsstörung/"Erfahrung" einer faktenbasierenden Diskussion im Weg steht?

Soll ich der Wahrnehmungsgestörten Person glauben das der Himmel grün ist? Wenn er sagen würde: "Ich nehme den Himmel grün wahr", dann wird ein Schuh draus. Nur das schreibt keiner mehr heutzutage. Es wird geschrieben: Der Himmel sit grün.

ayngush schrieb:

Aber die Aussage, dass man mit einer 4070 mit 12 GB VRAM nicht in 4k Auflösung spielen kann ist halt einfach Blödsinn.

das habe ich aber nicht geschrieben.

Ich schrieb:

"Ich (und viele andere) haben belegt das 12GB in 4k nicht gut geht."

Das wurde mit Fallbeispielen von Magazinen und Webseiten untermauert.

Eine so absolute Aussage wie du denkst das ich Sie schrieb, traf ich eben nicht.

Habe immer versucht sehr genau zu formulieren was mich stört.

Weil ja, man kann damit spielen, gehe ich völlig mit.

Aber man kann nicht sagen das man damit reibungslos 4k kann.

Und zwar Heute Anfang 2024 zum frischen Release der 4070 Super welche für Jahre in Betrieb sein wird und direkt ca 650-700€ kostet. Bedenke, viele überspringen mind. 1 Gen bevor Sie aufrüsten.

Wer also 4k nutzen will sollte also direkt damit leben Einstellungen (Texturen!) bei der 4070 herunterzudrehen oder kauft eine 16GB AMD, welche in Summe Rasterleistung + 16GB das eben besser kann.

Die 7800XT gibt es für 100€ weniger und ist etwas langsamer aber hat 16GB.

Für 100€ mehr die 7900 XT die deutlich schneller (mindestens in Raster) als eine 4070 ist und 20GB hat.

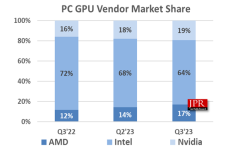

Klar das NVIDIA da sich in Zugzwang sieht.

Und diese Ansicht teilt der Markt, sonst würde AMD keine Karten los werden und NVIDIA keine 4070 TI Super bringen, wohlgemerkt zur selben UVP wie die non-super.