Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Radeon RX 480 Red Devil im Test: PowerColors roter Teufel ist zivilisiert und leise

AdmiralPain

Ensign

- Registriert

- Juli 2016

- Beiträge

- 136

derfledderer schrieb:Hier ein Test bezüglich der Lautstärke. Manche wünschten sich ja eins um mit der Nitro vergleichen zu können:

Danke dafür. Ein wie ich finde sehr angenehmes und dezentes Geräusch der Lüfter.

ix.tank schrieb:Definitiv letzter Versuch:

Du verwendest den Marketing-Begriff AC einfach falsch, bzw. für Dinge, die schon immer gingen und einfach nichts mit AC zutun haben. Das es etwas mit Queues zutun hat stimmt sogar, aber nicht so einfach und generell wie du glaubst.

Seit Kepler (GK110/GCN1.0) gibt es nun die Möglichkeit mehr als eine Queue für Compute-Tasks zu nutzen. Das kann Nvidia sogar aktuell mit 32 gegen 8 Queues bei AMD deutlich besser. (siehe Tabelle "GPU Queue Engine Support" deines Links)

Da du deinen Text erweitert hast, hier auch eine Antwort darauf.

AMD kann mehr als 8 Queues.

AMD hat bis zu 8 ACU´s, ,und jede kann parallel bis zu 8 Queues managen, sprich maximal 64 Queues simultan abreiten lassen. Dazu hat jede Queue bei AMD einen L2 Cache Acces. Und die Tasks können auch nach der Order „effektiv“ (dank eines Teils der Async Shader wie ich schon schrieb/mir ist bewusst das andere Teile der Async Shader andere Aufgaben übernehmen) bei AMD zwischen den Queues und in ihrer Folge nicht nur ausgetauscht, sondern auch beschleunigt werden, wenn andere Units im Idle sind.

Da Nvidia keine Async Shader hat die diesen Part übernehmen können, sind folglich in dessen Queues reichlich Idles und nicht bearbeitete Ressourcen brach liegend, völlig unabhängig davon ob AC aktiv ist oder nicht. Also sehr ähnlich wie bei AMD, wenn AC nicht aktiv ist.

Das ist der Hardware Unterschied zwischen der Funktion des Nvidia und des AMD Asynchrone Compute.

Nun versucht Nvidia dieses durch Treiber Anpassung zu umgehen, was aber niemals so effektiv wie die Hardwareseitige Verteilung und Sortierung zwischen den einzelnen Queues sein kann. Natürlich müssen die Programmierer den Vorteil der Async Shader bei AMD auch bewusst Softwareseitig nutzen. Wenn das Programm die Abkürzung welche einen auch noch trägt nicht kennt, dann nutzt es natürlich nichts.

Darum hat AMD dank Async Shader auch aktuell einen Vorteil im Bereich AC, sofern die Async Shader durch die Programmierer genutzt werden.

RichtigZweiter Teil: Die Fähigkeit Grafik- und Compute-Aufgabe gleichzeitig/gemischt von obigem Scheduler verteilen zu lassen:

In der Tabelle ist das die Spalte "Graphics/Mixed Mode". Hier hat sich eigentlich erst mit GCN 1.1 (290 Series) und Maxwell 2 wirklich etwas getan.

Allerdings deutet aktuell einiges darauf hin, dass Maxwell 2 diesen "Graphics/Mixed Mode" überhaupt nicht in Hardware unterstützt. Deswegen hebt AMD diese Fähigkeit so hervor, denn GCN1.1 kann es definitiv.

Es ist halt das AC was jede Karte kann, welche mehr als einen Queue verwalten kann, was aber wiederum ein völlig anderes AC ist, als das von AMD, natürlich aufgrund der Async Shader.

@AdmiralPain unter mir:

Und ich bin persönlich nur der Meinung, dass du nicht verstanden hast, was mit AC gemeint ist. Das du nicht einmal fachlich auf meine Beiträge geantwortet hast, bestätigt das auch irgendwie für mich.

Doch doch

Zurück zum Thema.

Meine Anfangsbehauptung war, Ohne eingeschaltetes AC = Nvidia & Amd den selben Arbeitsaufwand da selbe Arbeitsweise = selber Verbrauch da beide Hersteller die selben Rechenwege, somit die Queues die selben Idles haben (natürlich in Relation zum generellen Verbrauch) .

Mit verwendetem AC bei AMD = AMD anderer Rechenweg = mehr Compute Units aktiv da der Idle anderer Queues weg fällt = mehr Verbrauch als Nvidia.

Dieses hast du bis jetzt immer noch nicht widerlegt.

AC ist nicht gleich AC.

Der Begriff wird halt sehr inflationär für völlig unterschiedliche Dinge verwendet, weshalb das AC von AMD auch ein völlig anderes ist, als das von Nvidia, was nicht bedeutet, dass nicht beide das Grund AC wobei mehrere Queues verwendet werden (wie du ja richtig dargestellt hast ) beherrschen würden.

Zuletzt bearbeitet:

ix.tank

Lieutenant

- Registriert

- Sep. 2010

- Beiträge

- 908

AC ist nicht gleich AC.

Doch ist es nur kann AMD es so wie es gedacht war und Nvidia mit Maxwell nicht (bei Pascal sieht es da schon etwas besser aus). Es gibt bezüglich der 2 von mir erklärten Punkte zu AC keinen Spielraum, entweder man unterstützt sie, dann kann man AC oder man unterstützt sie nicht oder nicht korrekt, dann kann man nicht AC!

Btw ACE und nicht ACU.

AMD kann mehr als 8 Queues.

AMD hat bis zu 8 ACU´s, ,und jede kann parallel bis zu 8 Queues managen, sprich maximal 64 Queues simultan abreiten lassen.

Der Vergleich bei der Warteschlangenanzahlen bei Anandtech bezog sich auf die Scheduler, bei Nvidia die Warp-Scheduler, davon hat eine Nvidia GPU je nach SMM-Anzahl aber auch jede Menge. Daher bringt es überhaupt nichts die Werte zu multiplizieren, wenn man sich über die Technologie der Scheduler unterhält.

Da Nvidia keine Async Shader hat die diesen Part übernehmen können, sind folglich in dessen Queues reichlich Idles und nicht bearbeitete Ressourcen brach liegend

Genau das soll sugeriert werden. Typischerweise programmiert man aber für GPUs im SIMD-Style und das liegt auch für den Anwendungsfall "Grafik" in der Natur der Sache, wenn ich Millionen-Pixel pro Frame berechnen will, dann brauche ich in der Regel die Cores der ganzen GPU sogar mehrfach mit den gleichen Instruktionen, so das der Wechsel zwischen diesen Aufgaben tatsächlich verglichen mit der realen Ausführungszeit recht selten vorkommt. Bei Compute-Aufgaben für die KI oder Physik muss das nicht so sein aber hier kann Nvidia auch problemlos hin und her wechseln. Und wenn man die Aufgaben in 2 Blöcke unterteilt - Compute und Grafik - dann entstehen bei NV nur Lücken beim Wechsel von Compute und Grafik und das kann man wenn man es gut umsetzt, darauf reduzieren, dass man es exakt 1x pro Frame macht! Der Unterschied zwischen NV und AMD wäre dann quasi nicht spürbar.

Btw.: An meinem Beitrag habe ich nichts außer "Und ich bin persönlich nur der Meinung, dass du nicht verstanden hast, was mit AC gemeint ist. Das du nicht einmal fachlich auf meine Beiträge geantwortet hast, bestätigt das auch irgendwie für mich." geändert nach dem du etwas dazu geschrieben hattest. Der Rest stand schon genau so Stunden vor deiner Antwort hier, also besser mal den Browser ab und zu aktualisieren.

Dieses hast du bis jetzt immer noch nicht widerlegt.

Ja du hast jetzt auch genau die Aussage heraus gesucht die ich nicht wiederlegen will, die passt schon so

Ich wollte dir erklären was genau AC ausmacht, da du den Begriff falsch nutzt und hier AC-Fähigkeiten zurechnest die absolut nichts damit zutun haben. Siehe oben "AC ist nicht gleich AC" ... doch, entweder man kann es oder eben nicht und wenn nicht gibt es unter DirektX 12 bei entsprechend programmierten Anwendung eben die Quitung!

ebird

Lieutenant

- Registriert

- Feb. 2008

- Beiträge

- 1.003

Ich hätte noch eine Anregung für die Diagramme. Der Temperaturvergleich alleine ist nicht gerade aussagekräftig. Ein Diagramm Temperatur/Lautheit wäre das wünschenswert. Die Lautheit muss ja nicht mal exakt bestimmt werden. Oder wenigstens ein Temperatur/Lautstärke.

>_<

Lieutenant

- Registriert

- Aug. 2011

- Beiträge

- 539

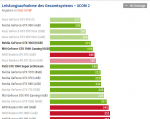

Von der FPS Performance schenkt sich die RX 480 oder GTX 1060 nicht viel. Anders sieht es aber bei der Temperatur und dem Verbrauch aus. Bemerkenswert, dass die AMD- Karten gut 5 °C wärmer werden (bei 3 Lüfter!) und im Schnitt gut 25 % mehr Strom verbrauchen (Last) bei nahezu gleicher Leistung der GTX 1060.

Unterm Strich muss man einfach sagen, dass die GTX 1060 effizienter arbeitet.

Unterm Strich muss man einfach sagen, dass die GTX 1060 effizienter arbeitet.

ebird

Lieutenant

- Registriert

- Feb. 2008

- Beiträge

- 1.003

HerrRossi schrieb:Kann sich eigentlich jemand etwas unter "Sone" vorstellen? Ich jedenfalls nicht, da ist dB schon griffiger, aber auch das lässt sich imho nur schwer einordnen.

Also Sone ist ein lineare Einheit unter Berücksichtigung der menschlichen Wahrnehmung. Und 2 Sone ist auch doppelt so laut wie 1 Sone. Das ist wesentlich besser als 33dB ohne Angabe der Entfernung und der Frequenz(en), bzw. wenigstens wird angegeben, ob das Geräusch angenehm, da tieffrequent oder unangenehm das hochfrequent. Der unterschied zwischen 26, 30, 34 und 38dB kann sich kauf einer vorstellen. Vor allem der Unterschied der Lautheit kann keiner anhand der Differenzen verstehen, obwohl es konstant 4dB sind.

In diesem Kontext spielt es auch keine Rolle, da nur die Temperatur im Vergleich zur Lautheit betrachtet werden kann.

FAKK schrieb:Von der FPS Performance schenkt sich die RX 480 oder GTX 1060 nicht viel. Anders sieht es aber bei der Temperatur und dem Verbrauch aus. Bemerkenswert, dass die AMD- Karten gut 5 °C wärmer werden (bei 3 Lüfter!) und im Schnitt gut 25 % mehr Strom verbrauchen (Last) bei nahezu gleicher Leistung der GTX 1060.

Unterm Strich muss man einfach sagen, dass die GTX 1060 effizienter arbeitet.

Was ist daran Bemerkenswert? Höhere Verlustleistung führt zur höheren Temperaturen. Man kann immer die schlechtesten Ergebnisse raus picken und entsprechend auslegen.

Ich kann genauso 7,5% geringere Performance bei gleicher Verlustleistung betrachten. Unter dem Gesichtspunkt, dass der Treibersupport bei Linux dermaßen überlegen ist, gibt es für mich keinen Grund die NVidia vorzuziehen.

Zuletzt bearbeitet:

Ich verstehe hier manche Beiträge nicht, die Werte sind doch wunderbar? Eine leise aber dennoch übertaktete Grafikkarte die ähnliche Leistung wie die 1060 für 299€ bietet. Dazu ein günstiger FreeSync Bildschirm und man ist sehr gut bedient.

Wer kaum Shooter spielt und auf FreeSync verzichten kann sollte natürlich wegen des Stromverbrauchs zur 1060 greifen.

Interessant wird das ganze wenn weitere DirectX 12 Spiele erscheinen

Wer kaum Shooter spielt und auf FreeSync verzichten kann sollte natürlich wegen des Stromverbrauchs zur 1060 greifen.

Interessant wird das ganze wenn weitere DirectX 12 Spiele erscheinen

Mortal1978

Lt. Commander

- Registriert

- Nov. 2014

- Beiträge

- 1.251

Ich habe die Devil seit vorgestern und bin hoch zufrieden mit ihr. Im Wattman gleich mal die +5% powertarget rein, und sie rennt düfte mit 90% 1330 MHz. OC ist wegen der noch ausstehenden verbesserten bios-version noch nicht drinnen!

Die drei Lüfter sind eher Kosmetik. Der sehr große Kühler mit Kupferkern und nur sanft angebogenen Heatpipes führt die Abwärme schon gut weg. Wer also will, kann den Lüfterteil wegmodden und nen hübschen 140er von unten drauf blasen lassen

Die drei Lüfter sind eher Kosmetik. Der sehr große Kühler mit Kupferkern und nur sanft angebogenen Heatpipes führt die Abwärme schon gut weg. Wer also will, kann den Lüfterteil wegmodden und nen hübschen 140er von unten drauf blasen lassen

Bei HWLUXX ist wie immer easy OC von 1420 MHZ möglich.

http://www.hardwareluxx.de/index.ph...radeon-rx-480-red-devil-im-test.html?start=18

Beeindruckend die Performance auch in DX 11 z.B. TW3. Scheint einfach eine runde RX 480 zu sein.

http://www.hardwareluxx.de/index.ph...radeon-rx-480-red-devil-im-test.html?start=18

Beeindruckend die Performance auch in DX 11 z.B. TW3. Scheint einfach eine runde RX 480 zu sein.

issenia schrieb:Bei HWLUXX ist wie immer easy OC von 1420 MHZ möglich.

http://www.hardwareluxx.de/index.ph...radeon-rx-480-red-devil-im-test.html?start=18

Beeindruckend die Performance auch in DX 11 z.B. TW3. Scheint einfach eine runde RX 480 zu sein.

Leider kein Speicher-OC, daher sind die Ergebnisse nicht wirklich aussaugekräftig

Krautmaster

Fleet Admiral

- Registriert

- Feb. 2007

- Beiträge

- 24.321

HerrRossi schrieb:Warum lässt man, während man den Benchmarkparcours absolviert, nicht einfach einen Stromzähler mitlaufen? Dann weiß man: das jeweilige System hat in den x Stunden des Testlaufs soundsoviel Strom verbraucht, selbst wenn Leerlauf vorkommt, ist das doch viel praxisnäher als irgendein Spiel kurz unter Volllast rennen zu lassen.

das könnte man ggf mit einem Trigger machen der zwischen Last und Idle unterscheidet, daraus dann einen Durchschnitt Verbrauch @ Last und Durchschnitt im Idle errechnen. Einfach komplett durchzumessen wird kaum gehen da die Abstände zwischen den Benchmarks sicher unterschiedlich ausfallen. Ich denke nicht dass ein Run komplett automatisiert durchläuft.

Man weiß zb dass das Testsystem vllt 55W idle frisst. Ab 100W geht man zB von Gaming Last aus , darunter von idle.

Edit: Es wurde ja schon darauf hingewiesen dass ANNO 2205 die AMD Karten teils deutlich weniger verbrauchen als in anderen Titeln wie Star Wars Battlefornt... was natürlich auch mit Lautstärke und Temperatur einhergehen dürfte. Deswegen ist ANNO hier in vielerlei Hinsicht ungeeignet, schon gleich wenn es das einzige getestete Game ist.

Wie gesagt, selbst die Referenzkarte braucht in XCOM 30W mehr als in Anno, und 30W sind eben schnell mal 25%.

30W werden je nach Lüfterprofil einen großen Kühler wie den der Devil wohl kaum großartig stressen - aber mit 245W ist da die Referenzkarte (XCOM) schon sehr nahe an der Devil OC Profil mit 253W in ANNO.

Zuletzt bearbeitet:

Mortal1978

Lt. Commander

- Registriert

- Nov. 2014

- Beiträge

- 1.251

a) Mem-OC derzeit kaum möglich wegen Treiber bug bei AMD... bringt aber mehr als die GPU für spiele!

b) gpu-OC mit der neuesten BIOS Version nicht mehr möglich, wird noch gefixt...

b) gpu-OC mit der neuesten BIOS Version nicht mehr möglich, wird noch gefixt...

alkaAdeluxx

Lt. Commander

- Registriert

- Mai 2007

- Beiträge

- 1.341

Idon schrieb:Grafikkarten-BIOS-Update für eine Mittelklasse-Karte, übel, viele Käufer werden gar nicht wissen, was das ist und/oder wie das geht.

Von den angepriesenen 220-250€ für Custom-Designs sind wir auch noch weit entfernt. Alles in allem doch recht enttäuschend.

Ich glaube du verwechselst das mit Nvidia die allen im Vorfeld mit ihren Fail Edition an der Nase herumführen wollten und angeblich die Customs günstiger werden sollten.

Amd hat nix diesbezüglich gesagt oder?

Mortal1978

Lt. Commander

- Registriert

- Nov. 2014

- Beiträge

- 1.251

Das ist nur ein Fall von powercolor mit dem BIOS.

Und wo ist das Problem? Es gab die Referenz für 219€ mit 4GB. Es wird auch kleine customs für 220-230€ geben. Fertig. Das hat doch alles nur mit Kundensegmenten und Preisdifferenzierung zu tun. Bis Weihnachten sind wir bei ~280€ für die custom 8 GB ohne viel OC....

Und wo ist das Problem? Es gab die Referenz für 219€ mit 4GB. Es wird auch kleine customs für 220-230€ geben. Fertig. Das hat doch alles nur mit Kundensegmenten und Preisdifferenzierung zu tun. Bis Weihnachten sind wir bei ~280€ für die custom 8 GB ohne viel OC....

Rockafilly

Cadet 3rd Year

- Registriert

- Dez. 2011

- Beiträge

- 36

Gibt nun auch einen ersten Test zur MSI RX 480

https://www.techpowerup.com/reviews/MSI/RX_480_Gaming_X/

https://www.techpowerup.com/reviews/MSI/RX_480_Gaming_X/

S

Sp3cial Us3r

Gast

Liebes CB Team, wann kommt der Nachtest mit der Karte mit den letzten Bios? Hardwareluxx konnte die Karte auf 1420 MHz takten, unter Last bewegte sich der Takt zwischen 1310-1330 MHz @ Stock Powerlimit

Viele Grüße

Sp3cial

Viele Grüße

Sp3cial

Ähnliche Themen

- Antworten

- 711

- Aufrufe

- 109.719

- Antworten

- 164

- Aufrufe

- 40.323