Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Radeon RX 6000: AMD-Benchmarks zeigen mehr als 60 FPS in 4K

- Ersteller Wolfgang

- Erstellt am

- Zur News: Radeon RX 6000: AMD-Benchmarks zeigen mehr als 60 FPS in 4K

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 4.415

unddeo schrieb:Big Navi wird auch gut in Tests abschneiden. Die Leistung muss nicht ganz an die 3080 heran reichen, weil die Leistungsaufnahme geringer sein wird....

Man darf net vergessen das u.U. die 16GB Vram sich erst bei den Frametimes zeigen.

(es gibt ja schon Fälle, wo die 3080 vs. 3090 net so ruhig läuft; und so richtige Brocken wirds wohl erst Ende2020 und 2021 mit den neuen Konsolengames geben; olle Games sind net entscheidend, daher wohl auch die 20GB für die 3080 demnächst)

btw.

Weniger W sind schon ein Vorteil zusammen mit reichlich offenem Powerlimit, um die Graka mal mit h2o zu betreiben. Preislich müsste man dann jeweils die 2x 8pin-Customs vergleichen.

(ne 3080strixx nur wg. der 3x 8pin ist ganz schön happig, vor Allem weil die TUF 2x 8pin ganz gut aussehen)

Zuletzt bearbeitet:

Markain

Cadet 3rd Year

- Registriert

- Sep. 2017

- Beiträge

- 42

Vendetta schrieb:AMD fehlt DLSS und die RT Performance wird auch noch schlechter als bei Ampere.

https://www.igorslab.de/ultimativer-visueller-vergleich-zwischen-amd-ris-nvidia-dlss-und-freestyle/

Sephiroth51

Lt. Commander

- Registriert

- Mai 2009

- Beiträge

- 1.703

Vendetta schrieb:5-10% langsamer als die 3080 und das war wohl der Vollausbau 6900XT. Preis? 649 mindestens, wahrscheinlich eher mehr. UVP wird eh nirgendwo mehr eingehalten, die ist ein reiner Fantasiewert.

Dann fehlen AMD die RT Cores, deren Raytracing wird sicher noch stärker die Performance tanken als eh schon bei Ampere. Und ohne Tensor Cores, die DLSS ermöglichen, kann AMD hier auch nichts kompensieren...

Von wo weiß man das?

AMD wird NIIIEEE Tensor Cores haben ebenfalls kein DLSS, zumindest unter dieser Marke da diese bestimmt Urheberrechtlich geschützt ist.

Anstatt panisch/hysterisch zu werden einfach mal am Zopf fassen, chillpille einlegen und cool bleiben. 😂😂

Ich denke zwar das es die größte Karte vorerst war die man da gezeigt hat, aber das macht mich nicht weniger Pessimistisch und Raytracing ist eine Technik die ist Uralt, keiner weiß wie die bei AMD in Echtzeit performen wird. Könnte etc. auch bei AMD besser laufen. Wer weiß.

Und warum sollte AMD keinen Pendant zu DLSS haben? Weil AMD noch nichts vorgestellt hat? Warum sollten Sie?

Die Technik wurde bei NVIDIA auch erst bei Erscheinung der RTX 20er vorgestellt.

Ergänzung ()

Tyga schrieb:Weniger FPS, kein Raytracing, kein DSSL und schlechte Treiber, günstiger im Preis? Stimmts?

sifusanders

Lt. Junior Grade

- Registriert

- Dez. 2017

- Beiträge

- 284

hoffe, dass nicht alle Deine 2.683 Beiträge das Niveau hatten.Tyga schrieb:Weniger FPS, kein Raytracing, kein DSSL und schlechte Treiber, günstiger im Preis? Stimmts?

Markain schrieb:

Super über nen Jahr alt, mittlerweile gibt es DLSS 2.0 und sogar auf cb einen Vergleich mit AMD FidelityFX und da wischt DLSS 2.0 den Boden mit.....

acmilan1899

Lt. Commander

- Registriert

- März 2007

- Beiträge

- 1.571

Ich vermute mal knapp hinter der RTX 3080 aber deutlich vor der RTX 3070 bei geringerem Verbrauch und mutmaßlich 12 oder 16 GB Ram.

W

Wadenbeisser

Gast

Du meinst das Spiel das bei den bisherigen empfohlenen Systemanforderungen lediglich ne 1060 oder 1070 hatte?Vendetta schrieb:Es ist ein Feature, das in dem Most Wanted 2020 von Millionen Spielern integriert sein wird: Cyberpunk 2077

So nebenbei, das Spiel interessiert mich kein Stück.

Vendetta

Commander

- Registriert

- Okt. 2007

- Beiträge

- 2.133

Korrekt, AMDs Lösung ist ca. so brauchbar wie das Checkerboarding der PS4Pro, glaube digital Foundry hat da Vergleiche bei death stranding gemacht, da Schnitt das image sharpening nicht gut ab, kann halt keine Details erzeugen wo keine da sind, DLSS schon, richtig irre ist der neue Ultra Performance Mode:Beg1 schrieb:Super über nen Jahr alt, mittlerweile gibt es DLSS 2.0 und sogar auf cb einen Vergleich mit AMD FidelityFX und da wischt DLSS 2.0 den Boden mit.....

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Payne19

Lieutenant

- Registriert

- Nov. 2008

- Beiträge

- 736

Und AMD ist einfach stehengeblieben? Als ob sie nicht auch weiter an ihrer Software arbeiten würden... haltet alle mal die Bälle flach bis zur GPU Präsentation ende des Monats.Beg1 schrieb:Super über nen Jahr alt, mittlerweile gibt es DLSS 2.0 und sogar auf cb einen Vergleich mit AMD FidelityFX und da wischt DLSS 2.0 den Boden mit.....

Vendetta

Commander

- Registriert

- Okt. 2007

- Beiträge

- 2.133

Ja, die Karten können auch kein Raytracing, für PS4 Optik wird es schon reichen.Wadenbeisser schrieb:Du meinst das Spiel das bei den bisherigen empfohlenen Systemanforderungen lediglich ne 1060 oder 1070 hatte?

der Unzensierte

Vice Admiral

- Registriert

- Juni 2009

- Beiträge

- 7.084

Ich hatte gar nicht mit einem teaser zu Big Navi gerechnet. Aber der hat ja eigentlich mehr Fragen aufgeworfen als beantwortet. Warten wir's ab.

Chismon

Admiral

- Registriert

- Mai 2015

- Beiträge

- 8.708

Nanu, da schau einer an (bei VCZ)  :

:

Ich sehe da jedenfalls keine Big Navi21 XTX als bestaetigt fuer die abegelieferten (Teaser-Demo) GPU-Leistungsdaten (fast schon eher ein Dementi).

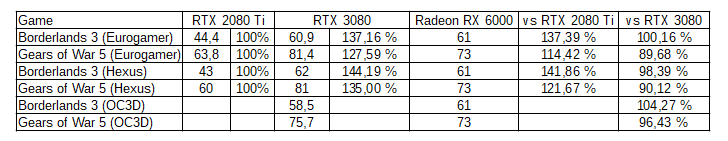

Einen ersten Vergleich von Planet3DNow! zur Leistung dieser Big Navi21 (XT?) GPU gibt es im dortigen Artikel auch schon, wobei Gears of War 5 (von Microsoft) eigentlich als sehr neutraler Spieltitel (weder AMD/RTG noch nVidia architektur-/sponsortechnisch grossartig beguenstigend) angenommen werden koennte :

:

Ergo, im Schnitt ist diese Big Navi21 GPU bei Spielen vielleicht 15-20% schneller als eine RTX 2080Ti?

Before the event, Radeon Scott Herkelmann stressed that AMD did not disclose which Radeon RX 6000 graphics card was used for these benchmarks. It is also important to note that AMD tested RX 6000 with Ryzen 9 5950X CPU, yet an unreleased processor which no GPU reviewer has used for their GPU benchmarks. AMD claims that this processor will be better than Intel CPUs in gaming. Whether that affects 4K performance, we don’t know yet.

Ich sehe da jedenfalls keine Big Navi21 XTX als bestaetigt fuer die abegelieferten (Teaser-Demo) GPU-Leistungsdaten (fast schon eher ein Dementi).

Einen ersten Vergleich von Planet3DNow! zur Leistung dieser Big Navi21 (XT?) GPU gibt es im dortigen Artikel auch schon, wobei Gears of War 5 (von Microsoft) eigentlich als sehr neutraler Spieltitel (weder AMD/RTG noch nVidia architektur-/sponsortechnisch grossartig beguenstigend) angenommen werden koennte

Ergo, im Schnitt ist diese Big Navi21 GPU bei Spielen vielleicht 15-20% schneller als eine RTX 2080Ti?

Zuletzt bearbeitet:

W

Wadenbeisser

Gast

@Beg1

Sinnloser Vergleich da FidelityFX herzlich wenig mit einem Upscaler wie DLSS zu tuen hat.

Das Eine arbeitet in der Zielauflösung udn das Andere skaliert ein geringer aufgelöst gerendertes Bild auf die Zielauflösung rauf. Logisch das DLSS dann schneller ist wenn es mit einer geringeren Auflösung rendert.

Und nebenbei, wo ging es in dem Link um FidelityFX?

Sinnloser Vergleich da FidelityFX herzlich wenig mit einem Upscaler wie DLSS zu tuen hat.

Das Eine arbeitet in der Zielauflösung udn das Andere skaliert ein geringer aufgelöst gerendertes Bild auf die Zielauflösung rauf. Logisch das DLSS dann schneller ist wenn es mit einer geringeren Auflösung rendert.

Und nebenbei, wo ging es in dem Link um FidelityFX?

- Registriert

- Sep. 2018

- Beiträge

- 3.485

Kann jemand eine grobe Abschätzung dazu geben, wie sich aktuell unter Blender openCL gegen CUDA/OptiX in der Renderperformance schlägt?

Supermax2004

Lt. Commander

- Registriert

- Aug. 2004

- Beiträge

- 1.643

Naja gut, man hat keinen Vergleich zu Nvidia gezeigt. Also wird man die 3080 kaum schlagen können, sonst hätten sie Vergleiche gezeigt.

Mal zum Spaß die Werte mit Computerbase vergleichen, da hat die 3080 in CoD 90+, AMD gibt 88 an. Ok das wäre sehr nah dran.

Borderlands gibt AMD 61 an, die 3080 packt hier 70 grob. Also so könnte es am Ende aussehen, man ist nah dran, etwas günstiger, mehr Vram, joah weckt sicher Interesse.

Mal zum Spaß die Werte mit Computerbase vergleichen, da hat die 3080 in CoD 90+, AMD gibt 88 an. Ok das wäre sehr nah dran.

Borderlands gibt AMD 61 an, die 3080 packt hier 70 grob. Also so könnte es am Ende aussehen, man ist nah dran, etwas günstiger, mehr Vram, joah weckt sicher Interesse.

Payne19

Lieutenant

- Registriert

- Nov. 2008

- Beiträge

- 736

Auch für dich nochmal die GPU Präsentation ist ende des Monats. Alle Infos die du dir Wünschst kriegst du dann dort.Supermax2004 schrieb:Naja gut, man hat keinen Vergleich zu Nvidia gezeigt. Also wird man die 3080 kaum schlagen können, sonst hätten sie Vergleiche gezeigt.

Ähnliche Themen

- Gesperrt

- Antworten

- 386

- Aufrufe

- 88.933

K

- Antworten

- 549

- Aufrufe

- 88.113