Pixelhomie

Ensign

- Registriert

- Okt. 2007

- Beiträge

- 233

Schon witzig. Da tut sich jahrelang rein garnichts auf dem CPU Markt, immer mit dem Hinweis 4 Kerne reichen vollkommen aus, und jetzt können es garnicht genug sein.

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

MrBackslash schrieb:Schon witzig. Da tut sich jahrelang rein garnichts auf dem CPU Markt, immer mit dem Hinweis 4 Kerne reichen vollkommen aus, und jetzt können es garnicht genug sein.

xexex schrieb:

Phneom schrieb:Zum Zocken ja.

Wenn du aber mal weiter gehst wie z.b. rendern oder encoding sieht die Sache anders aus.

Beispiel:

Anhang anzeigen 632823

@Xeon1231v3

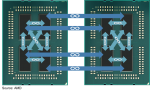

yurij schrieb:Hier ist die längste strecke zwischen zwei beliebigen nodes (Dies) 2 hops.

MrBackslash schrieb:Ich dachte rendern und encoding ist mit GPUs heute viel schneller und effizienter als mit einer CPU???

yurij schrieb:Hier ist die längste strecke zwischen zwei beliebigen nodes (Dies) 2 hops.

MK one schrieb:Quantität = GPU , hohe Qualität = CPU

Wer sagt denn das AMD in den 4 - 8 Sockel Server Bereich will ? der Naples Nachfolger Starship hat schon 48 Kerne , im Dual Sockel = 96 Kerne 192 Threads , dazu Octachannel uns was weiß ich wieviel Terrabyte Ram ( Threadripper kann ja schon 2 TB adressieren )

druckluft schrieb:Ganz so wenige sind es dann doch nicht. Da hast du die Die-internen Routing-Punkte vergessen mitzuzählen

Assume a processor which works at 1GHz. This means one billion clock cycles per second. This also means one clock cycle takes one billionth of a second, or a nanosecond. Light travels about 30cm (about a foot) in a nanosecond. So, the size of circuitry involved at such clock speeds better be much less than (at least 1/10 of) 30cm. So, your maximum circuit size is 3cm. Taking into account that the actual CPU core size is less than 1cm a side, we are still in safe waters.

A core that access an L3-cache slice that is very close (like the ones vertically above each other) gets an additional latency of 1 cycle per hop. An access to a cache slice that is vertically 2 hops away needs 2 cycles, and one that is 2 hops away horizontally needs 3 cycles. A core from the bottom that needs to access a cache slice at the top needs only 4 cycles. Horizontally, you get a latency of 9 cycles at the most. So despite the fact that this Mesh connects 6 extra cores verse Broadwell-EP, it delivers an average latency in the same ballpark (even slightly better) as the former's dual ring architecture with 22 cores (6 cycles average).

Meanwhile the worst case scenario – getting data from the right top node to the bottom left node – should demand around 13 cycles. And before you get too concerned with that number, keep in mind that it compares very favorably with any off die communication that has to happen between different dies in (AMD's) Multi Chip Module (MCM), with the Skylake-SP's latency being around one-tenth of EPYC's. It is crystal clear that there will be some situations where Intel's server chip scales better than AMD's solution.

Toaster05 schrieb:1920X und Abfahrt.. wo bleiben die Benches

Leider wirds auch hier kein ITX geben so wie bei X99.. (jaja ich weiß es gibt genau 1! Mobo für X99)..

ampre schrieb:Schau dir die Stuktur beider An. Es kommt jetzt drauf an wie die Programme geschrieben sind.

Bei den Meisten Programme ist es so das es ausreicht wenn 4 Kerne miteinander Daten austauschen. Bei der CCX muss man im Programm also nur aufpassen das Threads die Daten von anderen Threasds brauchen in der selben Gruppierung laufen und bum das Teil wird viel viel Schneller abgearbeitet als bei Intel.

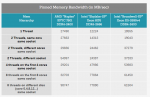

The new Skylake-SP offers mediocre bandwidth to a single thread: only 12 GB/s is available despite the use of fast DDR-4 2666. The Broadwell-EP delivers 50% more bandwidth with slower DDR4-2400. It is clear that Skylake-SP needs more threads to get the most of its available memory bandwidth.

Meanwhile a single thread on a Naples core can get 27,5 GB/s if necessary. This is very promissing, as this means that a single-threaded phase in an HPC application will get abundant bandwidth and run as fast as possible. But the total bandwidth that one whole quad core CCX can command is only 30 GB/s.

Overall, memory bandwidth on Intel's Skylake-SP Xeon behaves more linearly than on AMD's EPYC. All off the Xeon's cores have access to all the memory channels, so bandwidth more directly increases with the number of threads.

druckluft schrieb:Ganz so wenige sind es dann doch nicht. Da hast du die Die-internen Routing-Punkte vergessen mitzuzählen

Previously, Ian has described the AMD Infinity Fabric that stitches the two CCXes together in one die and interconnects the 4 different "Zeppelin" dies in one MCM. The choice of using two CCXes in a single die is certainly not optimal for Naples. The local "inside the CCX" 8 MB L3-cache is accessed with very little latency. But once the core needs to access another L3-cache chunk – even on the same die – unloaded latency is pretty bad: it's only slightly better than the DRAM access latency. Accessing DRAM is on all modern CPUs a naturally high latency operation: signals have to travel from the memory controller over the memory bus, and the internal memory matrix of DDR4-2666 DRAM is only running at 333 MHz (hence the very high CAS latencies of DDR4). So it is surprising that accessing SRAM over an on-chip fabric requires so many cycles.

What does this mean to the end user? The 64 MB L3 on the spec sheet does not really exist. In fact even the 16 MB L3 on a single Zeppelin die consists of two 8 MB L3-caches. There is no cache that truly functions as single, unified L3-cache on the MCM; instead there are eight separate 8 MB L3-caches.

That will work out fine for applications that have a footprint that fits within a single 8 MB L3 slice, like virtual machines (JVM, Hypervisors based ones) and HPC/Big Data applications that work on separate chunks of data in parallel (for example, the "map" phase of "map/reduce"). However this kind of setup will definitely hurt the performance of applications that need "central" access to one big data pool, such as database applications and big data applications in the "Shuffle phase".

MK one schrieb:der Naples Nachfolger Starship hat schon 48 Kerne , im Dual Sockel = 96 Kerne 192 Threads ,