MegaManPlay schrieb:was du evt. meinen könntest ist das fertige Bilder einfach weiter geleitet werden zb. die gpu berechnet 60 bilder und schickt die weiter... das wäre ja im bestenfall ein paar MB daten zu verarbeiten... so steigt MINIMAL die Latenz des inputes aber nicht weiter tragisch

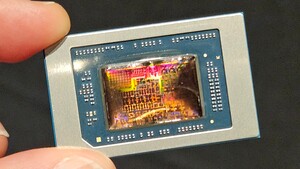

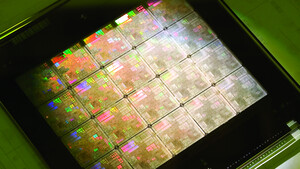

Ja, die Grafikkarte berechnet das Bild, gibt es aber nicht direkt an den Bildschirm aus sondern lädt es in den Arbeitsspeicher. Der Bildschirm bzw. die Grafikausgänge sind dann an die iGPU angeschlossen, welche dann letztlich das Bild ausgibt. Hier wird es genauer beschrieben: https://www.notebookcheck.com/Nvidia-Optimus-im-Test.25430.0.html