CR4NK schrieb:

Wer weiß was mit Undervolting noch so drin ist. Ich sag nur 8800GT und GTX280

so sehe ich das auch, viele hier reagieren übermäßig enttäuscht von der Karte, ich hingegen sehe dass die Karte vieles besser als die GTX 480 macht. Gerade der idle Verbrauch überrascht, deutlich besser als die 480er dabei sind die Karten kaum verschieden.

Die Frage ist, ob bei der 470er auch konstante Spannungen anliegen und ob diese manuell anpassbar sind. Für die Mehrzahl an Käufern ist Bios Editing wohl ausgeschlossen, für jemand der sich aber damit zu beschäftigen weiß kann man nur raten erste Ergebnisse abzuwarten.

Schaffe89 schrieb:

Für mich ist die GTX470 mit einem Custom Design viel erstrebenswerter als ne olle GTX480, die auch mit Custom Design sehr heiß und laut werden wird. Übertaktbarkeit gleich null.

Die GTX470 ist da wesentlich sympathischer.

da stimme ich dir zu. Dass 480-> 448 Shader und bissle weniger Ram so großen Unterschied machen hätte ich nicht gedacht, dachte die 470er kommt weit enttäuschender daher. Für eine Karte die eigentlich weniger fürs Spielen optimiert wurde, eine akzeptable Leistung.

y33H@ schrieb:

@ Mister-Knister

Nein. Eine GTX480 etwa macht bei 92° im Furmark "nur" 76%. Die Temps sind also Absicht und der Lüfter hat noch viel Spiel nach oben.

Ganz klar, wer mit Luft ein leises System haben will, der muss auf die HD 5870 / HD 5850 setzen mit alternativem Lüfter - oder Bios modifizieren. Prinzipiell sehe ich die Stärken der GTX 470 / 480 mehr unter Wasser. Ich denke erst dort kann sie nach oben raus ihre Leistung entfalten. Die Temperaturen dürften 50°C kühler ausfallen, was sicher auch gute Taktsteierungen ohne Spannungserhöhung mit sich bringt. 750 mhz + sind ordentlich, 20%. Unter Wasser könnte mehr drin sein. Mich interessiert Max Leistungsaufnahme nicht allzusehr, man darf gespannt sein was die VRs der Nvidia Karten abkönnen, wenn sie halbwegs taugen sollten nahezu 1000 Mhz mit Wasser + Bios + leichten v+ gehen.

Ich weiß, dass die Karte für das was wir sie brauchen, Spieleleistung, ineffizienter als die ATI ist, das sieht man deutlich in der DIE Größe und im Verbrauch. Das liegt denke ich nicht daran, dass NVIDIA architekturell Müll gebaut hat, sondern eher daran, dass der Fokus anders (mehr auf GPGPU) gesetzt wurde.

Die HD5XXX ist auch super zu übertakten. Wasser gehen hier ca 1100-1150, aber auch nur mit V+. Man darf gespannt sein. Die schlechte Verfügbarkeit hat leider mangelnde Forenberichte zur Folge.

Complication schrieb:

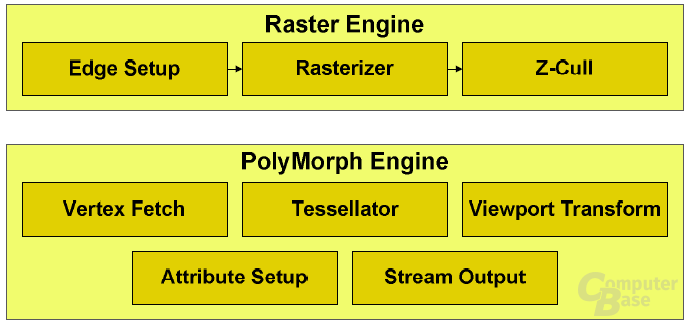

Es fehlt 1 Polymporphe Engine bei der 470. Und Fermi hat keine "klar getrennten" Tessellation Units

Die Polymorphe Engine erfüllt 5 Aufgaben - das macht sie nicht gleichzeitig. Man beachte mal die Benches bei höheren Auflösungen (2560x1600) wo die Fermis einbrechen - ich denke dass zukünftige Spiele gerade dort mehr Last verursachen wo eben Multi-Monitor Setups ins Spiel kommen verstärkt. Diese Aufgabenteilung wird um so mehr Einfluss haben je kleiner die Karten werden.

joa, so wie ich das verstanden habe schöpfen die Nvidia Karten ihre Leistung aus "einem Pott" - so hat Tessellatoren auch weniger GPU Leistung für den anderen Krams zur Folge. Ich denke aber diese Art der Tessellation ist zumindest flexibler, da sie dynamisch je nach Anforderung geschalten werden kann. Ohne Tessellation kann die GPU sich voll um die 3D Darstellung kümmern, ist 100% ausgelastet, mit Tessellation schaffe ich genauso 100%. Eine fixe Tessellationseinheit langweilt sich hier also. Dagegen wir ein Hardware Tessellator sicher weniger Platz brauchen und effektiver arbeiten. Ich denke die Vor / Nachteile beider Systeme zeigen sich erst in den nächsten Monaten und kommenden wirklichen Dx11 Spielen.

Auf keinen Fall kann man die Lösung von Nvidia hier schlechtreden - die Tessellation dynamisch zu lösen. Dafür ist es zu früh und bisher überzeugt die Lösung in der Tessillationsleistung, also sollte man sie eher loben

milamber! schrieb:

Niemand bestreitet das der GF100 in Tessellation gewisse Vorteile hat, aber das ist noch lange kein Grund aus ner Mücke nen Elefanten zu machen, und die Heaven Werte immer und überall auf die Zukunft zu projizieren.

joa das mag stimmen. Das ganze Tessellationsthema ist noch nicht abschätzbar. Allen Anschein nach gewinnt die Nvidia Architektur hier um ein paar Prozentpunkte, was aber den Brei nicht fett macht. Die Frage ist, wie sich die HD5XXX mit fixem Tessellator verhält, wenn sie mit der Tessellation nicht nachkommen sollte, die Einheit überlastet ist. Nvidia kann hier dynamisch auch viel Leistung dieser Aufgabe zukommen lassen.

Folglich muss AMD schauen, dass sie IMMER genug Tessellationspower haben, diese wird sicher mit kommenden Karten erhöht.

Ich frage mich wieso die Performance auch bei den ATI Karten mit zugeschaltener Tessellation so einbricht, eigentlich sollte dank Hardware dass eigentlich nahezu "nebenbei" gehen. Geht es sicher auch, aber die eigentliche 3D Darstellungsaufwand nimmt wohl auch ordentlich zu. Blöd wirds dann, wenn der Tessellator zum Flaschenhals wird. Kann man schwer sagen wann dies der Fall ist, oder ob das bereits heute auftritt und für den Einbruch verantwortlich ist.