KarlKarolinger

Lieutenant

- Registriert

- Nov. 2008

- Beiträge

- 732

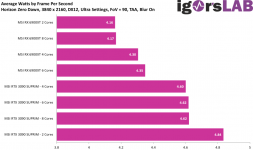

Wenn ich mich nicht irre testet CB mit einem 12-Kerner oder gar mehr. Ich glaube kaum, dass Watch Dogs alle 24 Threads zu 100% ausreizt und damit dem Treiber keine Luft mehr lässt. Laut Hardware Unboxed wird der Overhead ja nur in dem Szenario (100% CPU-Auslastung) zum Problem. Ich denke hier ist eher irgendeine andere CPU-Limitierung vorhanden.Blackfirehawk schrieb:Sobald n Spiel n bischen CPU lastiger wird (zb geringere Auflösung oder zuviel Hintergrund Berechnungen) kackt Nvidia zur Zeit leider sehr ab wegen dem dx12 Driver Overhead

Bei den Min-FPS in 4K sieht AMD auch deutlich besser aus. 🤷♂️