HITCHER_I

Commodore

- Registriert

- Okt. 2006

- Beiträge

- 4.880

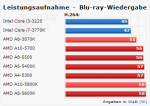

danke, der Test war sicher für alle Interessierten hilfreich, und zeigt schön, dass die A10-5700 APU auch wirklich erwartungsgemäß sparsamer ist.

Allerdings finde ich es fraglich, weshalb man in so einen Rechner eine Geforce GTX 680 einbaut, die ja idle auch Strom zieht, und man will ja auch von der guten integrierten und stromsparenden Grafik der APUs profitieren, daher wäre IMHO wenn schon, eine Kombination mit einer kleineren ATI-Grafikkarte sinnvoller, da diese beiden Grafikeinheiten dann zusammenarbeiten können.

-

Aber ansonsten sieht man ja im GPU-Vergleichstest den sehr guten IDLE-Verbrauch von ca. 33W

https://www.computerbase.de/artikel/grafikkarten/alle-desktop-trinity-im-gpu-vergleichstest.1944/

Allerdings finde ich es fraglich, weshalb man in so einen Rechner eine Geforce GTX 680 einbaut, die ja idle auch Strom zieht, und man will ja auch von der guten integrierten und stromsparenden Grafik der APUs profitieren, daher wäre IMHO wenn schon, eine Kombination mit einer kleineren ATI-Grafikkarte sinnvoller, da diese beiden Grafikeinheiten dann zusammenarbeiten können.

-

Aber ansonsten sieht man ja im GPU-Vergleichstest den sehr guten IDLE-Verbrauch von ca. 33W

https://www.computerbase.de/artikel/grafikkarten/alle-desktop-trinity-im-gpu-vergleichstest.1944/

Zuletzt bearbeitet: