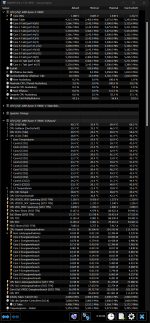

VORSICHT, das ist nicht korrekt von mir!!!!t3chn0 schrieb:So, da wir ja hier die Diskussion um den SOC Verbrauch hatten und ich die Screenshots geposted habe wo man sieht, dass ich out of the box mit dem 7900X im IDLE ca. 36W Verbrauch hatte und diesen dank VDD_SOC Anpassung und MISC Anpassung auf ca. 32W senken konnte.

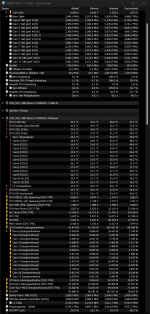

Ich bin gerade absolut überrascht was hier beim 7900X3D los ist. Statt der 36W out of the box, genügt dieser sich mit nur 25W out of the box. Das ist ein riesiger Unterschied. Ich habe keine Ahnung woher das kommt, aber das ist schon irre.

Anhang anzeigen 1333414

Ich hatte EXPOII noch nicht geladen. Mit EXPOII liegt die Leistungsaufnahme im IDLE nun bei 43W und ist damit 7W schlechter als beim normalen 7900X! Puh, gerade noch entdeckt.