Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test AMD Ryzen 9 7950X3D im Test: King of the Gaming-Hill

- Ersteller Wolfgang

- Erstellt am

- Zum Test: AMD Ryzen 9 7950X3D im Test: King of the Gaming-Hill

Mordekai2009

Lt. Junior Grade Pro

- Registriert

- Nov. 2018

- Beiträge

- 355

Vielen Dank für den Test. Bin gespannt für den AMD Ryzen 7 7800X3D im April um zu sehen wo die Reise hingeht.

kachiri

Fleet Admiral

- Registriert

- Apr. 2011

- Beiträge

- 18.777

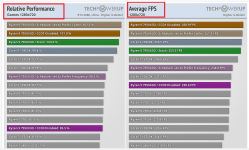

Also wie erwartet die 20% mehr zu den Varianten ohne 3D-Cache und ebenso dieselben Effizienzgewinne, wie sie der 5800X3D bei Zen 3 gezeigt hat.

+25% gegenüber den 5800X3D bei nahezu gleichen Stromverbrauch im Gaming. AMD doing it right. Intel braucht doppelt so viel Strom

+25% gegenüber den 5800X3D bei nahezu gleichen Stromverbrauch im Gaming. AMD doing it right. Intel braucht doppelt so viel Strom

Müritzer

Commodore

- Registriert

- März 2017

- Beiträge

- 4.848

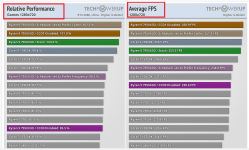

Die CPU ist je schon der Hammer aber hier haben die ein CCD deaktiviert, abgeschaltet, mal sehen ob diese Ergebnisse den echten 7800X3D wirklich wiedergeben.

https://www.techpowerup.com/review/ryzen-7800x3d-performance-preview/

https://www.techpowerup.com/review/ryzen-7800x3d-performance-preview/

Draco Nobilis

Banned

- Registriert

- Jan. 2012

- Beiträge

- 2.943

Das ist der AMD den wir uns gewünscht haben.

Ja klar, der Vorsprung hängt stark von den Spielen ab, das kann man aber auch bei Intel sagen.

Was aber stehen bleibt ist so oder so die absurd viel höhere Effizienz.

Und mal ehrlich, ich halte es eher für Entwicklerquatsch wenn diese den zusätzlichen Cache nicht nutzen, als es AMD zum Nachteil anzurechnen.

Bei Hardware unboxed ist in Factorio ein 7950X3D bsp 73% schneller als die non-X Variante.

Und ich behaupte mal frech das die Entwickler mit zu den besten in Sachen Optimierung gehören.

Allerdings hat dort der Scheduler den non-Cache CCD zuerst genommen, man musste daher selber Hand anlegen und quasi einen 7800X3D simulieren.

Ja klar, der Vorsprung hängt stark von den Spielen ab, das kann man aber auch bei Intel sagen.

Was aber stehen bleibt ist so oder so die absurd viel höhere Effizienz.

Und mal ehrlich, ich halte es eher für Entwicklerquatsch wenn diese den zusätzlichen Cache nicht nutzen, als es AMD zum Nachteil anzurechnen.

Bei Hardware unboxed ist in Factorio ein 7950X3D bsp 73% schneller als die non-X Variante.

Und ich behaupte mal frech das die Entwickler mit zu den besten in Sachen Optimierung gehören.

Allerdings hat dort der Scheduler den non-Cache CCD zuerst genommen, man musste daher selber Hand anlegen und quasi einen 7800X3D simulieren.

N

Noninterlaced

Gast

Gehst du nach PCGH !Bulletchief schrieb:Wie groß sind denn die Unterschiede bei realistischen Auflösungen?

O

Onkel Föhn

Gast

7 % schneller als der KS bei weniger als die Hälfte beim Verbrauch nenn ich mal sehr löblich AMD 👍

MfG Föhn.

MfG Föhn.

nighteeeeey

Commodore

- Registriert

- Jan. 2007

- Beiträge

- 4.110

Praktisch genau was ich mir erhofft habe

wird gekauft sobald die Preise etwas gefallen sind, passend für Diablo 4

wird gekauft sobald die Preise etwas gefallen sind, passend für Diablo 4

T

Tunaraxx

Gast

Gab's schon ein Statement von @Zer0Strat ?

Hat er nicht gepredigt das die neuen X3D Modelle praktisch chancenlos sein werden ?

Gibt's vielleicht später noch Cherry picking serviert ?

Frage für ein Freund.

Hat er nicht gepredigt das die neuen X3D Modelle praktisch chancenlos sein werden ?

Gibt's vielleicht später noch Cherry picking serviert ?

Frage für ein Freund.

- Registriert

- Apr. 2001

- Beiträge

- 16.215

Das haben wir uns am Ende noch separat angesehen:Redirion schrieb:Bei D2R beispielweise hätte sicherlich der CCD ohne Cache über den Takt mehr FPS generiert.

https://www.computerbase.de/artikel...-2#abschnitt_amds_ccdzuweisung_in_der_analyse

wenn Du dann aber andersrum die Games die weniger wie 100FPS in 720P bringen sowmit in FHD mit eine normalen GPU unspielbar sind sieht es wieder anders aus. man kann alles drehen und wennden das es passt.Pater_Erminold schrieb:Leider weniger CPU lastige Spiele als im letzten Test, definitiv nicht King of the Hill.

Das bleibt der 13900K mit bisschen RAM Tuning.

Unsinnige Spiele mit >300 FPS entfernt.

Effizienz herausragend.

ich hoffe ich finde noch tests mit 4070TI-12GB va 7900xt-20GB 192bit vs 320bit in FHD und WUHD

Anhänge

DonDonat

Commodore

- Registriert

- Apr. 2013

- Beiträge

- 4.807

Liest sich doch sehr nice, gerade die Effizient sieht sehr nett aus

Wären mir als Spieler der nur ab und an Videos schneidet aber zu teuer, ich kann mit sovielen Kernen/Threads keinen wirklichen Vorteil generieren. Auch muss man ja zu den hohen Anschaffungskosten noch die hohen Plattform Kosten rechnen...

Ich könnte fast meinen 3700X + 1080Ti als Komplettsystem tauschen, gerade weil mein 650W Netzteil bei den neuen GPUs vielleicht etwas knapp werden könnte. Nur ist dann am Ende in Sachen P/L natürlich ein 58003D sowie GPU+Netzteil dann trotzdem noch günstiger. Mal schauen, noch läuft mein System ja und bisher sieht es ja nicht danach aus, dass Nvidia die Preise der GPUs senkt, also bleib ich hier eh erst mal noch bis die GPU-Shortage-Tax die Nvidia hier verlangt wegfällt oder deutlich reduziert wird. Und nein, leider ist AMD keine Alternative weil G-Sync only Monitor War in der Retrospektive definitiv dumm den zu nehmen, "Lock-In" ist echt unschön...

War in der Retrospektive definitiv dumm den zu nehmen, "Lock-In" ist echt unschön...

Wären mir als Spieler der nur ab und an Videos schneidet aber zu teuer, ich kann mit sovielen Kernen/Threads keinen wirklichen Vorteil generieren. Auch muss man ja zu den hohen Anschaffungskosten noch die hohen Plattform Kosten rechnen...

Ich könnte fast meinen 3700X + 1080Ti als Komplettsystem tauschen, gerade weil mein 650W Netzteil bei den neuen GPUs vielleicht etwas knapp werden könnte. Nur ist dann am Ende in Sachen P/L natürlich ein 58003D sowie GPU+Netzteil dann trotzdem noch günstiger. Mal schauen, noch läuft mein System ja und bisher sieht es ja nicht danach aus, dass Nvidia die Preise der GPUs senkt, also bleib ich hier eh erst mal noch bis die GPU-Shortage-Tax die Nvidia hier verlangt wegfällt oder deutlich reduziert wird. Und nein, leider ist AMD keine Alternative weil G-Sync only Monitor

In Sachen Leistung leicht vor dem 13900K/KS. In Sachen Effizienz in einer ganz anderen Liga oder gar Dimension. Schon sehr beeindruckend.

Mehr muss eigentlich nicht gesagt werden.

Danke @Wolfgang und @Volker für den gelungenen Test.

Hier liefert der neue AMD-Prozessor mal eben doppelt so viele FPS pro Watt – das ist beeindruckend.

Mehr muss eigentlich nicht gesagt werden.

Danke @Wolfgang und @Volker für den gelungenen Test.

KlaasKersting

Captain

- Registriert

- Okt. 2015

- Beiträge

- 3.138

Wer schon Alder Lake oder Raptor Lake hat, muss da jetzt nicht extra umsteigen.

Kaum jemand wird so viel spielen, dass sich das in der selben Leistungsklasse nur für die Effizienz lohnen würde.

Als Neukauf dürfte für so gut wie jeden der 3D Raptor Lake ausstechen.

Kaum jemand wird so viel spielen, dass sich das in der selben Leistungsklasse nur für die Effizienz lohnen würde.

Als Neukauf dürfte für so gut wie jeden der 3D Raptor Lake ausstechen.

- Registriert

- Dez. 2016

- Beiträge

- 1.611

schönes gerät, hab mir jetzt erst vor zwei wochen den 5800x3d gekauft, das nächste upgrade hat also noch zeit bis zur 10. oder 11. generation oder dann auch mal wieder intels äquivalent.

F

floh667

Gast

Hardware Unboxed hat das ebenfalls simuliert, aber bei denen rennt der simulierte 7800x3d teilweise dem 7950x3d davonMüritzer schrieb:Die CPU ist je schon der Hammer aber hier haben die ein CCD deaktiviert, abgeschaltet, mal sehen ob diese Ergebnisse den echten 7800X3D wirklich wiedergeben.

Anhang anzeigen 1330278

https://www.techpowerup.com/review/ryzen-7800x3d-performance-preview/

Anhang anzeigen 1330280Anhang anzeigen 1330281

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

- Registriert

- Nov. 2002

- Beiträge

- 8.992

Zwingend notwendig ist die game Bar nicht, das kostet aber etwas Leistung, das kann ich hier bestätigen. Wie viel, weiß ich nicht, aber das kann schon mal im zweistelligen Prozentbereich liegen.konkretor schrieb:Windows Game Bar ist das zwingend notwendig?

Was passiert wenn die nicht auf dem Rechner ist oder einen alten Stand hat?

@Volker

Den Test dazu findest du auch im ArtikelRedirion schrieb:Welcher Wechsel? Laut CB lief war ja leider immer der X3D-Cache-CCD aktiv. Bei D2R beispielweise hätte sicherlich der CCD ohne Cache über den Takt mehr FPS generiert.

Das Tool spuckt den Verbrauch halt eben ausfloh667 schrieb:Jetzt muss ich aber doch mal nachhaken. Wie schafft ihr es, dass bei jedem CPU test euer 5800x3d mehr verbraucht? Ich hab das mal farblich markiert zum vergleich und aus drei CPU tests raus genommen.

Klar, der letzte wurde mit einer 4090 gemacht, aber mit den 720p als testauflösung habt ihr ja zuvor bereits dafür gesorgt, dass es kein CPU limit gibt.

Sind halt wieder andere, moderne Spiele etc. Die werden halt immer anspruchsvoller und das kostet dann wohl auch einfach mehr Energie.

Ben_computer_Ba

Lt. Commander

- Registriert

- Sep. 2021

- Beiträge

- 1.151

Griff ins Klo. Effizienz ist besser, ist aber Irrelevant und im gaming ist er nicht wirklich schneller. Da hätte ich mehr erwartet, würdet ihr auch Mal anständigen RAM verwenden, mit welchen Intel im Gegensatz zu AMD klarkommt, sind beide gleich auf. Das gleiche lächerliche wie letztens bei einem spiele Test, wo die rtx 4090 und RX 7900xtx ausgebremst wurden, weil nur mit Last Gen CPU getestet wurde. Das geht besser. Wie manche sich hier einen ab freuen können, erschließt sich mir nicht. Das entscheidende ist sowieso, wie gut und vorallem wie lange AMD diese Liste mit der Zuordnung der Kerne aktuell hält.

Ähnliche Themen

- Antworten

- 16

- Aufrufe

- 1.983

- Antworten

- 14

- Aufrufe

- 1.450

- Antworten

- 20

- Aufrufe

- 1.552

- Antworten

- 78

- Aufrufe

- 6.422

- Antworten

- 20

- Aufrufe

- 2.151