ZeroZerp schrieb:

Dort kann man den Verbrauch der CPU exakt ermitteln. Ohne den Verlust des Spannungswandlers.

Igor hat das inzwischen gemacht....da vertraue ich auch eher auf die Werte.

Er hat z.B. die Settings und Auflösung von 720p low, zu 4K extreme, hochgetestet....mit dem wenig überraschenden Ergebnis, dass der Verbrauch massiv sinkt, weil er dann immer weniger FPS hat...Teils durch höhere Settings, aber auch weil mehr von der Szene ins GPU Limit rutscht.

Und weiter hinten bei ca 35:00 sieht man den 10900K und den 3900X bei verschiedenen Situationen und auch beim Spielen verglichen.

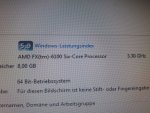

Im Idle 5 zu 26W geht klar an Intel.

Auch bei "wenig core" Anwendungen ist Intel grob 10W sparsamer.

Aber egal ob FHD mit guter oder schlechter Multicore Unterstützung oder maximaler Verbrauch bei 720p low, ist der 3900X 15-25W sparsamer.

Und bei Anwendungen die mehr Kerne nutzen ist die Sache eh klar.

Da der 10900K ja auch einige Prozent mehr FPS liefert und die X570 Boards nochmal mehr verbrauchen, kann man da sicherlich sagen, dass die Effizienz aus Watt/FPS nicht entscheident anders ausfällt.

Das wird sich von Spiel zu Spiel massiv unterscheiden....und wie man dank Igor sieht auch abhängig von den FPS.

Und das passt auch zu den Tests von CB....Intel ist sparsamer im Idle und bei single core Lasten....AMD ist sparsamer bei allcore Last und PC Spiele liegen irgendwo dazwischen.

v_ossi schrieb:

Nur man so, was sagst du eigentlich zu dem Argument, das höhere Auflösungen bisweilen CPU intensiver sind, weil z.B. mehr Drawcalls für Details erfolgen müssen, als bei 720p oder ähnlichem.

Siehe oben.....warum das so ist, hat dir ZeroZerp ja schon erklärt....aber hier hast du auch Verbrauchswerte dazu....Es sind vor allem höhere FPS, die den Verbrauch erhöhen.

Und stellt man auf Ultra sinken diese sowohl im CPU als auch im GPU Limit.

...für einzelne Settings mag das anders sein...wenn man mit einem Setting mehr Physik oder KI Berechnungen erhöht, sich die FPS dank GPU Limit aber nicht ändern.