Caramelito

Admiral

- Registriert

- Juni 2016

- Beiträge

- 9.014

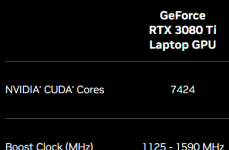

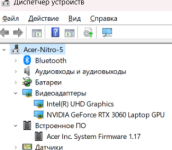

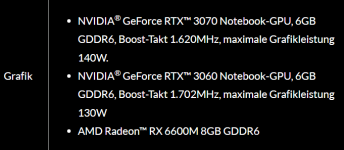

Sie hieß 3080 und hatte 16GB Vram. Da hat keiner geheult.CDLABSRadonP... schrieb:Häh? Die 3080 16GiB für Mobile war eine Karte, die mit der eigentlichen 3080 nichts zu tun hatte. Sie nutzte den GA104-Chip der 3070 8GiB Desktop, an Stelle des GA102 von 3080 10GiB Desktop.

In positiver Hinsicht wurde da gar nichts getäuscht...

Nun heißt sie 4090 und hat 16GB Vram. Und Leute heulen.

Heuchelei! ;-)