Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test GPU-Leistungsaufnahme: Auch Radeon kann auf dem Windows-Desktop sparsam sein

H

HierGibtsNichts

Gast

Das kann durchaus sein.Tanzmusikus schrieb:🤩 Der Artikel ist ja von @SVΞN. Danke & Grüße! 👍

Das sind gute Neuigkeiten - auch für Linux-Nutzer.

Ergänzung ()

Dann halt den bekannten Workaround mit CRU oder "Custom Resolution" in Adrenalin Software nutzen.Hunder schrieb:Egal welche Kombination an VRR Schalter bei mir in Windows und im Treiber an oder aus ist, die 100W Idle Verbrauch bleiben bei meiner 7900 XTX. 4K 120Hz HDR

Tatsächlich hab ich meinen neuen Monitor, der Freesync kann, immer im Freesync-Modus betrieben.

Der Treiber hat das nicht automatisch erkannt, aber die Einstellung war relativ einfach zu finden.

Damals unter dem Zahnrad Menü Symbol - in den neueren Treibern ist unter "Gaming".

PS: Wobei es im Menü nun auch AMD-Optimiert als Auswahl gibt - ich geh mal davon aus, das der Treiber es zumindest teilweise erkennt, ob er einen Freesync-Monitor am Kabel hat.

Der Treiber hat das nicht automatisch erkannt, aber die Einstellung war relativ einfach zu finden.

Damals unter dem Zahnrad Menü Symbol - in den neueren Treibern ist unter "Gaming".

PS: Wobei es im Menü nun auch AMD-Optimiert als Auswahl gibt - ich geh mal davon aus, das der Treiber es zumindest teilweise erkennt, ob er einen Freesync-Monitor am Kabel hat.

Zuletzt bearbeitet:

[wege]mini schrieb:Kommt auf das Szenario an.

Wenn man das selbe Bild nur 2mal ausgibt (spiegeln) sollte nicht viel passieren. Wenn man einen großen Monitor ausgibt (erweitern) werden nun einmal mehr Pixel berechnet und wenn man echtes Dual Screen betreibt, werden nun einmal 2 Monitore berechnet.

Es sollte beim Strommessgerät zu einer Veränderung führen, was man als Szenario wählt.

Sonst baut der Treiber schon wieder Mist.

mfg

ja schon werden mehr Pixel berechnet, aber das ist ja unwesentlich mehr Rambedarf. Das sind ja nur ein paar MB (rein für Desktop) und die Berechnung dazu ist auch nur unwesentlich komplizierter. Ich glaub mit 256MB kann man locker 2 x 4k (Desktop) ausgeben in 8bit Farbetiefe

[Ergänzung] hier die Rechnung:

2 (Monitore) x 3840 x 2160 x8 (bit) =132710400 bit =126,5625 MByte

Zuletzt bearbeitet:

janeeisklar

Lieutenant

- Registriert

- Juni 2014

- Beiträge

- 552

Glaube AMD wird sich erst nach dem "Update" für Windows 11 von Microsoft äußern:

https://blogs.windows.com/windows-i...ncing-windows-11-insider-preview-build-25915/

https://blogs.windows.com/windows-i...ncing-windows-11-insider-preview-build-25915/

What’s new in Build 25915

...

Changes and Improvements

[Graphics]

- We have improved refresh rate logic to allow different refresh rates on different monitors, depending on the refresh rate for each monitor and content shown on the screen. This will help most with refresh rate-dependent multitasking, like playing a game and watching a video at the same time.

- While a Dynamic Refresh Rate (DRR) is selected and Battery saver is also enabled, Windows will remain at the lower refresh rate and not switch to the higher rate until after Battery saver is disabled.

Haldi

Fleet Admiral

- Registriert

- Feb. 2009

- Beiträge

- 10.091

Schön für dich.janeeisklar schrieb:Nein, mein Monitor hat DSC (WQHD, 240Hz 10Bit und Radeon 6900XT) und das Verhalten ist gleich (6W Idle) bei FreeSync im Treiber an.

Ich hab leider nebenbei noch 2x FullHD 60Hz Monitore im Betrieb.

Da läuft das nicht mehr.

Wenn ich DSC abschalten sinkt der idle verbrauch von 50W auf 30W

Das mit variabler Refreshrate als LÖSUNG in Windows als Ursache hatte ich schon vor Mai mehrfach geschrieben. 1 Bsp:rentex schrieb:Und das über 7 Monate nach Release der Karten...

Und warum zum Teufel, hat man bis jetzt zum Benchen keinen Monitor mit VRR genutzt? Auch wenn es keinen Einfluss auf die Ergebnisse hatte, sollte man aktuelles Equipment zum Benchen auf dieser Veröffentlichungsebene nutzen.

Am falschen Ende gespart?

https://www.computerbase.de/forum/t...uen-testparcours.2144335/page-7#post-28216036

Und das CB besser mit einem weiteren Moni testen sollte, evtl. mit Zweitbalken. (Weil ich die Werte absolut nicht nachvolziehen konnte mit meinem System)

steht schon hier:

https://www.computerbase.de/forum/t...n-startklar-fuer-f1-23.2148275/#post-28313459

Für mich ist das nur alter Tee den ich seit Monaten ausrufe, wenigstens tut sich nun endlich was.

Ältere Threads habe ich mal nicht ausgekramt, sollte es aber auch geben.

- Registriert

- Nov. 2009

- Beiträge

- 6.553

Nein. Man muss da nix studiert haben, sondern es zeigt sich eher, dass es Glückssache ist. Oder Pech...johnieboy schrieb:Bei AMD muss man die Materie quasi studiert haben um ein befriedigendes Ergebnis zu bekommen während man bei Nvidia dafür schlicht überhaupt nichts machen muss.

Ich war von den letzten Messungen von ComputerBase komplett überrascht, weil ich mir auf die schlechten Werte bei RDNA2 keinen Reim machen konnte. Ich hatte bereits eine RX 6600, hab dann einen Monitor mit UHD@144Hz mit FreeSync-Feature gekauft, angeschlossen, und ab dann durchgehend 4-6 W auf dem Desktop gehabt. Da war absolut gar kein Zutun erforderlich. Nicht einmal den Treiber hatte ich beim Wechsel von RX 580 auf die RX 6600 aktualisiert.

Die höheren Werte aus dem letzten Bericht ergaben für mich schlichtweg keinen Sinn. Nach dem Installieren der Karte war VRR im Treiber automatisch aktiv, in Windows aus, und auch laut Monitor auf dem Desktop nicht aktiv. Ich konnte also aus meiner Perspektive nicht auf die Idee kommen, dass das nur in Spielen aktivierte VRR irgendwas damit zu tun hat. Erst jetzt mit dem neuen Bericht kommt die Erklärung, warum bei ComputerBase offenbar der Monitor für die höheren Werte verantwortlich war.

Nun kann man immer noch sagen, dass man dann halt ein Studium braucht, um nicht den falschen Monitor zu kaufen. Beim Blick in Geizhals haben allerdings von 211 Geräten mit 144 Hz nur 8 kein Adaptive Sync. Die Situation von ComputerBase vor diesem aktuellen Test war also eher Pech als der Normalfall.

Okay ich möchte bitte nur sichergehen, dass ich es richtig verstanden habe;

Kurz: Hauptsache AdaptiveSync im Treiber = AN und der Rest ist egal?

- Der AdaptiveSync-Switch im Treiber muss = AN sein, damit die Leistungsaufnahme sinkt?

- Punkt 1 bezogen auf Leistungsaufnahme funktioniert nur, wenn auch das Display AdaptiveSync beherrscht

- Der Windows-VRR-Switch, ob AN oder AUS hat keinen Einfluss auf 1 und 2?

Kurz: Hauptsache AdaptiveSync im Treiber = AN und der Rest ist egal?

Funktioniert das auch unter Windows 10 oder nur unter Windows 11?

Habe mir vor kurzem eine RX 6700 XT geholt, daher finde ich das recht interessant.

Nutzung wäre 2x FHD @ Freesync 48-75Hz + 1x WQHD @ Freesync 48-144Hz + ggf. FHD TV @ 60Hz.

Naja werde ich ja bald herausfinden.

Habe mir vor kurzem eine RX 6700 XT geholt, daher finde ich das recht interessant.

Nutzung wäre 2x FHD @ Freesync 48-75Hz + 1x WQHD @ Freesync 48-144Hz + ggf. FHD TV @ 60Hz.

Naja werde ich ja bald herausfinden.

- Registriert

- Nov. 2009

- Beiträge

- 6.553

Ja.ChrFr schrieb:Funktioniert das auch unter Windows 10 [...]?

- Registriert

- Nov. 2009

- Beiträge

- 6.553

Zumindest in Firefox wird die Videodekodierung komplett abgeschaltet, wenn das Video in einem Hintergrund-Tab abgespielt wird. Da läuft dann nur der Ton weiter. Hab hier gerade drei Twitch-Streams im Hintergrund laufen, bei einem den Ton an, und die RX 6600 meldet die gleichen 4,8W wie bei ruhendem Desktop. Das sollte bei einer 7900 XT identisch funktionieren... also nicht die Wattzahl, aber keinen Unterschied zwischen Video im Hintergrund und gar keinem Video.nitg schrieb:youtube, kA welche auflösung, da im hintergrund

flaphoschi

Lt. Commander

- Registriert

- Jan. 2018

- Beiträge

- 1.825

Wie reagiert den Linux mit VRR?

Wenn Linux ähnlich reagiert liegt es an der Hardware und/oder dem Kernelmodul. Wenn nicht liegt es allein am Treiber für Windows.

Hinweis: Da Mutter für Wayland (noch) kein VRR bietet, ist es sinnvoll das mit X11 zu testen.

Wenn Linux ähnlich reagiert liegt es an der Hardware und/oder dem Kernelmodul. Wenn nicht liegt es allein am Treiber für Windows.

Hinweis: Da Mutter für Wayland (noch) kein VRR bietet, ist es sinnvoll das mit X11 zu testen.

Demon_666

Commodore

- Registriert

- Dez. 2017

- Beiträge

- 4.603

Sehr interessant, Danke für den Test.

Ich frage mich jedoch, wie viele AMD User VRR im Treiber nicht aktiviert haben (entsprechenden Monitor vorausgesetzt).

Schließlich ist VRR (egal bei welchem Hersteller) imho eine der wichtigsten Technologien moderner Karten für eine korrekte Darstellung.

Ich frage mich jedoch, wie viele AMD User VRR im Treiber nicht aktiviert haben (entsprechenden Monitor vorausgesetzt).

Schließlich ist VRR (egal bei welchem Hersteller) imho eine der wichtigsten Technologien moderner Karten für eine korrekte Darstellung.

- Registriert

- Nov. 2009

- Beiträge

- 6.553

Es schaltet sich automatisch an, wenn es erstmalig aktivierbar wird. Man muss es bewusst wieder deaktivieren.Demon_666 schrieb:Ich frage mich jedoch, wie viele AMD User VRR im Treiber nicht aktiviert haben (entsprechenden Monitor vorausgesetzt).

Zuletzt bearbeitet:

Ich hab mal einen Vorschlag für die Redaktion. Macht den Test auf einem 120Hz 4K OLED Fernseher.

Ich hab dasselbe Problem mit meinem LG 34GN850-b und meiner 5700XT Speichertakt immer auf Maximum. Mit meinem Asus MG279Q keine Probleme, genauso wenn ich an meinem Fernseher Spiele.

Ich hab dasselbe Problem mit meinem LG 34GN850-b und meiner 5700XT Speichertakt immer auf Maximum. Mit meinem Asus MG279Q keine Probleme, genauso wenn ich an meinem Fernseher Spiele.

D

DerRobert94

Gast

Das sind mal gute Neuigkeiten. Seit gut 20 Jahren bin ich das erste Mal wirklich scharf auf meine neue GPU die irgendwann kommt. (Bin noch am schauen und am überlegen ob ich auf 12GB der aktuellen Gen warte etc). Das wird nicht nur ein gewaltiger Performance Sprung, wohl auch weit effizienter als mein aktueller Nvidia uralt Schrott.

ÖX45

Cadet 3rd Year

- Registriert

- Juli 2008

- Beiträge

- 61

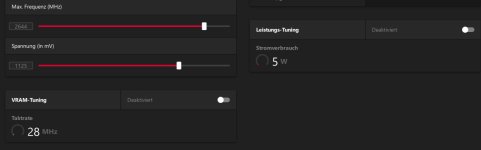

Mircosfot schrieb:Anhang anzeigen 1381435

Habe diese Option erst gar nicht

Aber mit meiner 6800XT 60Hz habe ich aber weniger verbrauch:

Anhang anzeigen 1381437

bei 144Hz sind´s wieder erheblich mehr, fast 40W :-(

Da stimmt was bei dir nicht. 6700XT @ WQHD 165Hz :

Anhänge

Ähnliche Themen

- Antworten

- 127

- Aufrufe

- 13.485

- Antworten

- 26

- Aufrufe

- 2.252

- Antworten

- 16

- Aufrufe

- 2.788

Leserartikel

Baal auf der Suche nach den Energiefressern im PC

- Antworten

- 99

- Aufrufe

- 21.499