- Registriert

- Nov. 2009

- Beiträge

- 6.524

Die Launch-Analyse des 3DCenters ist da.

Beobachtungen zum Thema Gaming:

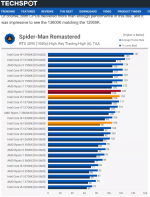

Für mehr Käufer interessant wird es bei den Modellen weiter unten. Das größte Problem hat bei AMD der 7700X für derzeit 463€, der vom 13600K für 380€ geschlagen wird. Da bekommt man bei Intel fast 30% mehr Performance pro Euro. Das ist die Baustelle.

Beobachtungen zum Thema Gaming:

- Der reduzierte Gaming-Parcours mit den 10 Titeln hier bei ComputerBase weicht diesmal sehr stark vom aggregierten Index ab. Beim Zen4-Launch waren es noch maximal 3,2% Abweichung, mit einem Ausreißer bis 4,5%. Diesmal sind es vielfach fast 10% Abweichung, mit Ausreißern bis fast 14%. Damit bildet ComputerBase die relative Gaming-Leistung der CPUs nicht mehr gut ab. Da muss nun eigentlich mit mehr Titeln nachgebessert werden.

- Die Spannweite zwischen den Tests ist riesig. Gegenüber dem auf 100% Gaming-Leistung normierten 13900K meldet Tom's Hardware für den 7600X nur 74,2%, und der Comptoir du Hardware 103,2%. Das sind +39% zwischen beiden Einträgen!!! Das zeigt einmal mehr, wie wichtig 3DCenter ist, um die Effekte solcher Ausreißer durch Aggregation zu reduzieren.

- Die Aussage von AMD, dass der 7600X in Spielen am 12900K vorbei zieht, wird bei 18 Publikationen, die beide getestet haben, von immerhin 5 bestätigt. Beim 7700X sind es 13 von 18, das ist dann schon deutlicher.

- Unter dem Strich legt sich Ryzen 7000 am Ende in Spielen nur mit dem 13600K an. Wer das Geld für 13700K oder gar 13900K ausgeben will, kann sich im Schnitt um gut 10% absetzen.

- Der 5800X3D bleibt AMDs derzeit beste Budget-Option für High-End-Gamer.

Ergänzung ()

Bei derart teuren Prozessoren sollte man sowieso genau hin sehen, welche Anwendungen genutzt werden, und welcher da konkret Vorteile bietet. Das kann mal der AVX-512-Support von Zen 4 sein, mal der qualitativ etwas bessere Hardware-Video-Encoder im 13900K. Oder man will halt einfach den einen oder anderen Prozessor haben, dann ändert da eh keiner was dran.mcsteph schrieb:Der 7950 und der 13900 sind in der Anwendungsperformance total gleich.

Für mehr Käufer interessant wird es bei den Modellen weiter unten. Das größte Problem hat bei AMD der 7700X für derzeit 463€, der vom 13600K für 380€ geschlagen wird. Da bekommt man bei Intel fast 30% mehr Performance pro Euro. Das ist die Baustelle.

Zuletzt bearbeitet: