@Sandro_Suchti

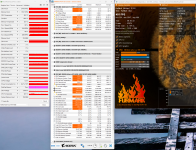

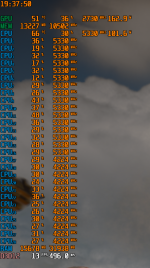

Evtl. bin ich einfach nicht in der Lage, das verständlich zu erklären. Ich hab's ja sogar schon aufgezeichnet. Mehr kann ich dazu nicht beitragen, sorry. Ich weiß auch nicht, was du meinst mit "...spielt keine Rolle für das Powerlimit" ... erneut, ich habe alles sauber aufgezeichnet, wie ich es hier nun schon mehrfach versucht habe zu erklären. Das muss dann auch reichen.

Evtl. bin ich einfach nicht in der Lage, das verständlich zu erklären. Ich hab's ja sogar schon aufgezeichnet. Mehr kann ich dazu nicht beitragen, sorry. Ich weiß auch nicht, was du meinst mit "...spielt keine Rolle für das Powerlimit" ... erneut, ich habe alles sauber aufgezeichnet, wie ich es hier nun schon mehrfach versucht habe zu erklären. Das muss dann auch reichen.