@GerryB Bei AMD wirds ein bisschen kompliziert, wegen der Architektur mit Infinity Fabric. AFAIK ist die SOC Bandbreite ist ab Werk höher, als die Speicherbandbreite, weil über den SOC zeitgleich mehrere Funktionseinheiten der GPU miteinander kommunizieren können müssen.

Bei RDNA2: Am SOC hängt der eigentliche Grafikprozessor, die Display Engine, Media Engines, mehrere IF-Links für (L3-Cache inkl. VRAM Datenbus), und der PCIe Endpoint. Der Speichercontroller, welcher den Adressbus und Dinge wie Cell-Refresh steuert, könnte u.U. separat über eine Control-Plane angesteuert sein (ist zumindest bei Ryzen CPUs so).

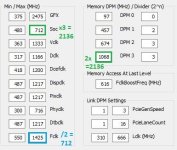

Wenn wir aber nun zur RTX 4070 zurückkehren, die mit 21Gbps GDDR6X daherkommt, hat diese einen realen Speichertakt von 21000/16=1312,5 Mhz (Quad pumped + DDR + PAM4 = 4*2*2 = 16).

Mit dieser Geschwindigkeit laufen auch der Speichercontroller, der Addressbus, und ein Teil des Datenbuses. Im Datenbus sitzt aber noch ein Decoder mit doppelter Taktfrequenz, welcher das PAM4 Signal wieder in eines mit nur 2 Zuständen umwandelt, um es so intern für die GPU nutzbar zu machen.

Bei GDDR6 non-X ergibt sich i.Vgl. ein Umrechanfaktor von 8 (4*2*1) wegen NRZ bzw. PAM2 statt PAM4. 20Gbps entsprechen damit 2500Mhz. Diese liegen am gesamten Datenbus an, und die aufwendige Decodierung des Signals fällt weg. Der Speichercontroller selbst wird aber mit halber Geschwindigkeit angesteuert, also 1250Mhz - das ist, was ich meinte mit "Takt sollte eigentlich gleich bleiben bzw. nicht ansteigen". Für die Bandbreite ist das egal, aber die Latenz leidet darunter (siehe Ryzen CPUs mit UCLK = MCLK/2).

AFAIK läuft der Speichercontroller bei RDNA2 ebenso mit MCLK/2.

GerryB schrieb:

wobei es mich wundert, das NRZ nur +1 und -1 können soll, wenn es außerdem als Mittelwert 0 gibt

(stelle mir die Datenübertragung wie auf einem Oszilloskop vor)

Wie ein analoges Signal auf ein digitales gemapped wird, is willkürlich und wird als Teil des Schaltkreisdesigns festgelegt. Das geistige Bild mit +1 bzw. -1, oder einer Sinuskurve ist in dem Kontext aber etwas verwirrend, weil das Anschauungen für Wechselstrom sind, bei dem sich die Stromrichtung ändert. Das ist bei Gleichstrom aber nicht gegeben.

Bei NRZ (Non-Return-to-Zero) kann zwischen zwei verschiedenen Spannungen unterschieden werden (z.B. 1V und 2V). Auf der Leitung liegt immer(!) einer der beiden Werte an. Ein Zwischenwert entsteht höchstens ganz kurz im Übergang von einem Wert auf den anderen, kann aber nicht als eigenständiger Signalpegel angelegt u. gehalten werden. Hier ist die Unterscheidung noch halbwegs einfach. Eine Spannung größer dem Wert in der Mitte (1+2)/2 = 1,5V kann als logische 1 gewertet werden, eine kleiner als 1,5V als logische 0. Es ergibt sich eine "Spannweite" bzw. ein gültiger Bereich von 0,5V um die jeweiligen Pegel.

Bei PAM4 hast du nicht zwingend einen größeren Spannungsunterschied zwischen dem höchsten, und dem niedrigsten Signalpegel, aber du musst mehr Werte unterbringen, z.B:

00 = 1,00V, 01 = 1,33V, 10=1,66V und 11=2,00V.

Hier erstreckt sich der zulässige Bereich des Pegels für eine gültige 1 nur noch von 1.166V bis 1,500V, womit die Größe des Intervals um den Wert herum auf 0,33V geschrumpft ist. Dementsprechend anfälliger wird das Ganze auch für Störungen. Die Spannungen setzen und messen muss man im Vergleich zu NRZ auch präziser können.