Foxel

Lieutenant

- Registriert

- März 2009

- Beiträge

- 817

@m4rci Naja das mehr an Informationen entsteht durch das jittered subsampling. Das ist wie wenn man die Kamera immer zittern lässt und dabei alle vergangenen Frames zu einem Bild addiert. Gerade bei einem Maschendrahtzaun hätte man bei einer festen Kamera nur die 2 informationen: ich sehe den Draht oder den Hintergrund.

DLSS hat einen ähnlichen effect wie downsampling da werden z.b 4 pixel zu einem verschmolzen. Dafür braucht man aber die 4 Fache Leistung. Bei DLSS macht man das verteilt über mehrere die Frames und das funktioniert so gut, dass man das auch mit einer geringeren Auflösung machen kann.

Wenn Objekte oder deine Kamera sich jetzt bewegt, kommen die Motion Vektoren hinzu um die vergangenen pixel an die neue position zu transformieren damit kein motion blur entsteht.

Und diese Technik so geil sie ist bringt gerade bei Raytracing den Vorteil das man gerade mit wenigen Rays und den krassen Rauschen ein Rauschfreies Bild bekommt. Ich arbeite auch mit einer ähnlichen Technik an meinem Raytracer. hier ist ein video das den Vorgang beschreibt der so auch bei DLSS benutzt wird:

EDIT:

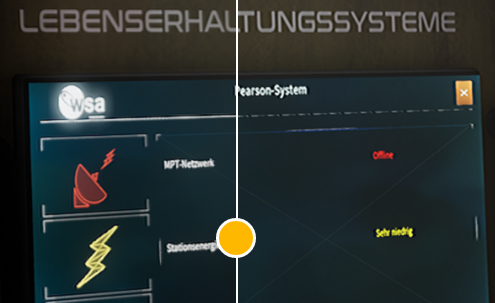

Hier mal ein gutes Beispiel wo man die Linie besser erkennt durch das jittering. Rechts ist nur ein pixel noise. (von Igor)

DLSS hat einen ähnlichen effect wie downsampling da werden z.b 4 pixel zu einem verschmolzen. Dafür braucht man aber die 4 Fache Leistung. Bei DLSS macht man das verteilt über mehrere die Frames und das funktioniert so gut, dass man das auch mit einer geringeren Auflösung machen kann.

Wenn Objekte oder deine Kamera sich jetzt bewegt, kommen die Motion Vektoren hinzu um die vergangenen pixel an die neue position zu transformieren damit kein motion blur entsteht.

Und diese Technik so geil sie ist bringt gerade bei Raytracing den Vorteil das man gerade mit wenigen Rays und den krassen Rauschen ein Rauschfreies Bild bekommt. Ich arbeite auch mit einer ähnlichen Technik an meinem Raytracer. hier ist ein video das den Vorgang beschreibt der so auch bei DLSS benutzt wird:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

EDIT:

Hier mal ein gutes Beispiel wo man die Linie besser erkennt durch das jittering. Rechts ist nur ein pixel noise. (von Igor)

Zuletzt bearbeitet: