aivazi

Commodore

- Registriert

- März 2008

- Beiträge

- 4.200

Xeljaga schrieb:Irgendwie beschleicht mich das Gefühl, dass in der Grafikkartenbranche es auch mal Zeit wäre für einen "Elon Musk", der hier mal aufräumt und anständige Mehrleistung/Preis bringt...

Das Stichwort ist die Architektur.

Radeon 7 ist nichts weiter als ein Re-Re-Refresh von Fiji.

Erst 28 nm, dann 14 nm und jetzt 7 nm.

Ebenso dasselbe bei Nvidia.

Nur dass es sich da schon seit Kepler so hinzieht.

Pascal ist schließlich auch nur der X-te Refresh der Kepler Architektur mit nur minimalen Änderungen.

Und Turing setzt eben noch ein paar Shader Einheiten drauf um zu kaschieren, dass der 12 nm Prozess jetzt keine so großen technischen Sprünge mit sich bringt.

Edit: Vergleicht man Kepler mit Pascal zB. die GTX 680 und die GTX 1080, dann stellt man schnell fest, dass der Leistungszuwachs ziemlich gut mit den zusätzlichen Shadereinheiten und dem höheren Takt zu erklären sind.

In dem Fall sind es 1536 Shader @ 1 GHz gegen 2560 Shader @1,8 GHz , das ist fast 70% Zuwachs nur bei den Shadern und 80% Zuwachs beim Takt.

Rechnet man nun Milchmädchenhaft

Fügt man jetzt noch 80% Takt drauf kommt man auf 306 % Leistung die Pascal in der Theorie haben müsste, wenn man nur die Kepler Architektur auf denselben Takt und dieselbe Shader Anzahl hochskaliert.

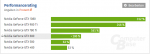

Vergleicht man nun diese theoretischen 306% Leistung mit dem Performancerating der beiden Karten diesem Test:

https://www.computerbase.de/artikel...8206/seite-2#diagramm-the-witcher-3-2560-1440

Dann sieht man in folgender Grafik den Rest selbsterklärend. ich denke auch nicht dass das Zufall ist

Die ziehen alle nur ihre Vorteile aus den Shrinks.

Hoffentlich wird mal Navi was an der Gesamtsituation am Markt verändern...^^

Zuletzt bearbeitet: