dead_brain

Ensign

- Registriert

- Dez. 2010

- Beiträge

- 133

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

Cool Master schrieb:@franklin88

Die HDD ist noch gut, aber klar sie bremst das System aus. --> SSD Einsetzen und die HDD als Datengrab für z.B. Daten (Bilder, Vids, etc.) verwenden.

Die Speicherbausteine heißen NANDs und die halten meist sogar viel mehr als 2000 bis 3000 P/E Zyklen aus, zumindest bei den guten SSD von renomierten Herstellern die diese NANDs entweder selbst herstellen oder die wirklich die hochwertigen NANDs der NAND Hersteller kaufen und verbauen und nicht selbst die Dies aus den Wafern binnen, verpacken und mit dem eigenen Logo versehen._TK_ schrieb:Die mittlerweile fast ausschließlich verwendeten MLC-EEPROMS (MLC-EEPROMS) halten max. 2000-3000 Schreibvorgänge aus, danach ist Schicht im Schacht. Ok, 3000x SSD vollschreiben dauert schon eine ganze Weile, aber wer sagt, daß Wear-Leveling und Fehlerkorrektur ordentlich implementiert sind? Seitdem ich mich intensiv mit dem Thema beschäftige, gehe ich mittlerweile davon aus, daß viele Produkte schnell und lieblos auf den Markt geworfen wurden, und nur selten dem Idealbild entsprechen.

7 Blöcke, NANDs werden immer blockweise ausrangiert._TK_ schrieb:Platte 1 (ST3250410AS):

Platte 2 (SSD): 0x05 /0xC4: 7 Sektoren wurden durch Reservesektoren ersetzt. Das klingt nicht viel, allerdings bin ich bei FLASH-Speichern etwas skeptisch.

Die Sandforce SSD von OCZ haben alle RAISE aktiviert und zeigen alle hohe ECC Korrekturwerte, weil OCZ eben die Eigenschaft des Sandforce auch mit minderwertigen NANDs noch einigermaßen gut über die Runden zu kommen, bisher am intensivsten ausgenutzt hat. Nur deren Sandforce SSD haben auch das Life-Time Throtteling aktiviert und die habe im Dauerschreibtest auf xtremesystems.org alle lange vor dem Erreichen der in der FW hinterlegten Zyklen schlapp gemacht, eine sogar bei 85% verbleibender Zyklen. Die einzige Ausnahme war die zweite Vertex Turbo, die aber nicht aus dem Handel kam, sondern als Ersatz für die erste auf Vermittlung eines OCZ Mitarbeiters in dem Forum dort geliefert wurde._TK_ schrieb:Dort schlägt S.M.A.R.T. gewöhnlich erst Alarm, wenn die sektorinterne Fehlerkorrektur längst am Limit ist.

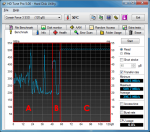

HD Tune ist für SSDs total ungeeignet, vor alle für die mit dem Sandforce Controller wie die Verrtex3, vergiss das Tool also für SSDs._TK_ schrieb:Probier mal bitte, die Lesegeschwindigkeitskurve z.B. mit hdtune zu ermitteln. Sollte dort die Geschwindigkeit merklich einbrechen, ist das ein deutliches Indiz dafür, daß die ECC-Fehlerkorrektur kräftig werkelt.

_TK_ schrieb:-> Regelmäßig Sicherungen anfertigen, und abwarten.

Erstmal die FW aktualisieren, die 2.15 ist schon recht alt und es wurden seidher noch viele Bug entfernt. Dann regelmäßig die Daten sichern, was man immer machen sollte und vor allem bei SSDs, da diese wenn, dann spontan und ohne jede Vorwarnung ausfallen und die Chancen auf Datenrettung minimal bis nicht existent sind.

Erstmal die FW aktualisieren, die 2.15 ist schon recht alt und es wurden seidher noch viele Bug entfernt. Dann regelmäßig die Daten sichern, was man immer machen sollte und vor allem bei SSDs, da diese wenn, dann spontan und ohne jede Vorwarnung ausfallen und die Chancen auf Datenrettung minimal bis nicht existent sind.SSD verwenden nur NAND Flash, also brauchen wir nicht auf Oberbegriffe auszuweichen._TK_ schrieb:Es gibt NAND- und NOR-FLASH

Was ich für Propaganda halte, wenn ich mir einmal das Abschneiden der Intel X25-E und das der X25-V im Dauerschreibtest auf xtremesystems.org ansehe. Aber genaue Zahlen behandeln die NAND Hersteller wie Staatsgeheimnisse._TK_ schrieb:Diese Multi-Level-Cell-EEPROMS halten prinzipbedingt nur etwa 1/10 der Schreibzyklen bei klassischen SLC-Speichern.

Wie viele Zyklen NAND konkret abkönnen, ist vor allem von der Qualitätsstufe abhängig, also davon wie präzise die Fertigung abgelaufen ist. Diese "Endurance-MLC" sind nichts anderes als die MLC der besten Qualitätsstufe und für die waren bei den 25nm von IMFT 30.000 Zyklen garantiert. Eine der m4 im Test hat sogar mehr geschafft, aber da hat man auch keine Rücksicht auf die JEDEC JESD 218 bzgl. Fehlerraten und Data Retention Tie genommen. Diese Anforderungen müssen bis zum Erreichen der garantierten P/E Zyklen eingehalten werden und das gerade die DRT mit steigender Zyklenzahl abfällt, ist das der Punkt an dem sich die NAND Hersteller bei der Bestimmung der garantierten Zyklenzahl vor allem orientieren müssen._TK_ schrieb:Mit zunehmender Miniaturisierung steigt die Empfindlichkeit weiter, d.h. die Haltbarkeit sinkt. Aktuell 3000-2000 Schreibvorgänge je Transistor. Bei "Endurance-MLC" etwas mehr.

Das hängt sehr vom Hersteller und auch vom Modell ab, wie französische Ausfallstatistik zeigt:_TK_ schrieb:Die meistens SSDs, die in freier Wildbahn existieren, sind leider keine Premium-Produkte. Fast alle Kunden schauen nun einmal auf den Preis, und dem müssen sich die Hersteller beugen.

Wobei die schlimmsten SSD schon nicht mehr in der letzten Ausgabe der Statistik enthalten sind, die waren in der vorherigen Ausgabe:

Aber bei HDDs gibt es auch große Unterschiede, die kannst Du auf der Seite davor finden. Man musste also bei SSD von jeher sehr aufpassen, welche man sich kauft. Deshalb haben wir ja auch im SSD Unterforum einen [Sammelthread] Kaufberatung und Fragen zu SSD.

So war es vielleicht mal bei den ersten SSDs, deren Controller bessere USB Stick Controller waren. Wie es heute mit dem Wear-Leveling und dem Mapping auf immer andere Flash Adressen funktioniert, kannDu hier mal nachlesen, da wird nicht mehr viel gelöscht, nur weil die Daten einer Page geändert werden._TK_ schrieb:Prinzipbedingt muß, auch wenn nur ein Bit geändert werden soll, ein gesamter Block ("Page") gelöscht werden, und wird erst dann neu geschrieben. Um die Geschwindigkeit der prizipiell recht lahmen MLC-FLASHs zu kaschieren, werden die Daten über mehrere Speicherchips bzw. Bänke verteilt, sprich man hat ein klassisches RAID-0 eingebaut. Also werden auch bei kleinsten Änderungen in einer Mini-Datei verhältnismäßig viele Sektoren neu geschrieben. Bei fragmentierten Daten steigt diese Anzahl weiter an, daher sollte man auch FLASH-Speicher gelegentlich defragmentieren. Es steigert die Haltbarkeit.

Das ist sehr gut, aber die Erfahrungen von Tests die dem Dauerschreibtest zeigen schon sehr gut, dass die Haltbarkeit von guten SSDs mehr als ausreichend ist, denn so viel schreiben Heimanwender nicht, als dass man die NAND kaputt geschrieben bekommt, da geht vorher was anderes kaputt._TK_ schrieb:Ich glaube nur noch begrenzt den vollmundigen Werbeaussagen.

USB Controller wurden auch kaum weiterentwickelt, die SSD Controller sind dagegen ungleich weiter und arbeiten heute ganz anders als noch die SSD Controller der ersten Generation. Pass also auf, nicht auf alte Informationen reinzufallen, denn da hat sich sehr, sehr viel getan._TK_ schrieb:Seitdem ich mich ernsthaft mit der Materie befasse, sehe ich anhand der Rohdaten aus den Speichern, wieviel die Hersteller kaschieren. Und wie oft das Wear Leveling, insb. bei günstigen USB-Sticks usw., noch nicht einmal ansatzweise existiert.

Was landet denn bei Euch in der Werkstatt? Das dürfte die alten SSDs sein, die alle noch mehr oder weniger gravierende Bug haben, wie der 8MB Bug bei Intel oder die ganzen Sandforce SSDs, die nie empfehlenswert waren, ebenso dürftet ihr da SSD mit dem Indilinx Barefoot bekommen, dessen aggressive Idle-GC die P/E Zyklen regelrecht auffresse und dessen Wear-Leveling unterirdisch schlecht ist._TK_ schrieb:Auch die besten Algorithmen können die Physik nicht überlisten. Tut mir leid, wenn ich hier manchmal etwas Pessimismus verbreite, aber ich sehe nur das, was in meiner Werkstatt landet. Und das ist oft sehr ernüchternd.

Hast Du Links dazu? Bei den 34nm wurden noch 5000 P/E Zyklen angegeben, bei den 25nm dann 3000, wobei Intel die gleichen NAND mit 5000 angegeben hat und für die 20nm NANDs gibt es nur die Aussage, dass man die gleichen Zyklenfestigkeit der 25nm NAND anstrebt, aber ich habe noch kein Datenblatt mit der Information gesehen._TK_ schrieb:Die Zahl der Schreibzyklen je Speicherzelle (nicht auf den gesamten Speicher gerechnet!) stammt aus den offiziellen Datenblättern der Hersteller, z.B. Micron.

Gekippte Bits sind bei NAND ebenso normal wie bei HDD auch, weshalb es ja auch die ECC gibt. Dafür hat jedes NAND auch extra Byte pro Page um diese ECC Daten unterzubringen, hier z.B. 224 Byte pro 4k Page._TK_ schrieb:Das deckt sich auch mit meinen Erfahrungen - gerade bei Profi-Fotografen sind teilweise bei weit über 90% der Sektoren schon Bits gekippt, d.h. die Daten nur noch per ECC-Fehlerkorrektur wiederherzustellen.

Das ist totaler Quatsch! Die ECC wird vom Controller so schnell durchgeführt, das es keine Performance kostet, zumal diese ab dem Neuzustand erfolgt._TK_ schrieb:Das kostet Rechenleistung, sprich Lesezeit. Daher werden die Speicher mit zunehmendem Verschleißgrad auch immer langsamer. Mag sein, daß das die Hersteller das als "Throttling" bezeichnen - absichtlich wird die Datenrate wohl nicht ausgebremst.

Das obliegt bei dem Test von xs.org natürlich dem einzelnen Tester, aber die werden kaum den Cache auf der SSD ausgeschaltet haben, denn das ist unsinnig und geht gewaltig auf die Performance, wenn es nicht wie bei den Sandforce schlicht ignoriert wird. Den Cache von Windows sollte man auch nicht ausschalten, es genügt, wenn der wie folgt eingestellt wird:_TK_ schrieb:Der Test auf xtremesystems.org ist sehr interessant, die c't hatte ja auch mal so etwas gestartet. Diese Tests sind praxisorientiert und arbeiten mit verschieden großen Dateien, und schlecht komprimierbaren Zufallswerten. Das ist ok. Mir fehlen hier aber ein paar wichtige Aussagen:

- wurde der Cache im Betriebssystem ausgeschaltet?

- Wie groß ist der Cache im SSD-Controller? War dieser aktiv oder nicht?

??? Bei xs.org wird ein von dem Anvil entwickeltes Programm dafür verwendet die SSD laufen zu beschreiben, wobei man selbst einstellen kann, wie komprimierbar die Daten sind. Da wurden also keine kleinen Dateien hin- und hergeschoben. Man kann aber wie immer, auch bei den Tests der Haltbarkeit von SSDs eine Menge falsch machen._TK_ schrieb:Solange man relativ kleine Dateien nur oberhalb des eigentlichen FLASH-Speichers hin- und herschiebt, sind solche Tests nur bedingt aussagekräftig.

Findest Du? Dem Sandforce kann ich nichts abgewinnen, der hat für meinen Geschmack zu viele Nachteile und die Vorteile gibt es gerade bei dem nur in der Eigenwerbung._TK_ schrieb:- Ach ja, Sandforce. Ein sehr ausgeklügeltes System. Man sollte aber immer ein aktuelles Backup parat haben, denn bei einen Defekt des Controllers sind die Daten nicht wiederherstellbar. Keine Chance.

Nicht Bänke, Blöcke! NAND ist in Blöcke und Pages unterteilt, die Bezeichnung sollte wir bitte auch beibehalten._TK_ schrieb:- 7 Bänke anstatt 7 Sektoren: Korrekt. Mein Fehler.