Chismon schrieb:

Full HD wird hier zukünftig größtenteils weg gelassen (es sei denn die Spiele sind extrem fordernd oder unterirdisch optimiert und dann wird man um ein zurück rudern evt. nicht herum kommen) und dafür kommen dann K.I. Benchmarks dazu.

Da muss jede/r selber entscheiden, ob die Tests von ComputerBase (CB) an Lese-/Kommentierwert zulegen oder einbüßen werden.

Hier darfst du dann aber nicht vergessen, dass auch eine neue Auflösung hinzu gekommen ist, die es vorher nicht gegeben hat und die bei der CB-Leserschaft mittlerweile häufiger genutzt wird als Full HD. Insgesamt werden mit dem neuen Testparcours mehr Inhalte getestet als zuvor, die AI-Benchmarks haben ja nichts ersetzt, sondern sind noch oben drauf gekommen.

kachiri schrieb:

Was ich btw. interessant finde... Warum testet ihr konsequent die 16 GB Varianten nicht mit? Es wird permanent betont, dass 8 GB bei 1080p kaum mehr reichen - und dann wird halt nicht einmal wenigstens die 7600 XT mit reingenommen, um das auch mal deutlich zu zeigen.

Oder ist es so häufig doch kein Faktor, dass man das gar nicht sehen würde?

Das liegt primär daran, dass die 8-GB-Karten in den Fällen die Standard-Varianten der Grafikkarten und daher deutlich mehr verbreitet sind. Darüber hinaus haben wir die Modelle mit mehr Speicher wie im Falle der RTX 4060 Ti auch nicht unbedingt.

CruellaDE schrieb:

@Wolfgang

Vielen Dank für die ganze Arbeit ! 😊

Ich gehe davon aus, dass Final Fantasy kein UWQHD unterstützt? Vielleicht die Info noch in die Tabelle packen.

Wäre es eigentlich sehr aufwendig, den durchschnittlichen VRAM "Bedarf" zu messen für die verschiedenen Spiele und Auflösungen? Der verhält sich wahrscheinlich nicht ähnlich wie die Leistung?

Also zum Beispiel verliert die 4080 von WQHD auf UWQHD ca. 15% fps, aber der VRAM-Bedarf wird wohl nicht um 15% steigen?

Ja, sowohl FFXVI als auch Lego unterstützen kein WQHD und fallen in den Benchmarks dann entsprechend raus.

Die durchschnittliche VRAM-Allokierung habe ich ohnehin in den Benchmarks-Logs, die Werte sind also ohnehin da. Ich kann hier durchaus wenn die Zeit mal da ist schauen, wie sich die VRAM-Adressierung je Auflösung verhält, ob das aber sinnvoll ist, ist eine andere Frage (man sieht ja wirklich nur die Adressierung und nie das, was wirklich gebraucht wird). Generell wird schon immer mehr VRAM bei höheren Auflösungen verwendet, die Zahl steigt für gewöhnlich aber nur gemächlich an.

Raidr schrieb:

Einige aktuelle Titel reinnehmen schön und gut, aber Cyberpunk und Alan Wake 2 raus und dafür unoptimierte oder nicht relevante Spiele rein (Stalker, Empire of Ants) ist eine komische Entscheidung.

Stalker ist aktuell eines der beliebtesten Spiele - irrerelevant ist das bei weitem nicht, ganz im Gegenteil.

Das Hauptproblem ist da schlicht, dass in den letzten 2 Jahren unglaublich viele technisch interessante Spiele erschienen sind, die potenziell interessant für Grafikkarten-Tests sind und potenziell zeigen, wohin die Reise in der Zukunft geht. Da habe ich mich dann schlicht dazu entschieden, in die Richtung zu gehen, was leider alle anderen Spiele aus dem Parcours rausgeschmissen hat. Optimal finde ich das auch nicht, aber hier muss dann schlicht der Arbeitsaufwand gekürzt werden.

Alan Wake und Cyberpunk werden aber in den RTX-5000-Artikeln als RT- und PT-Benchmarks nochmal zurückkehren

Glyphus schrieb:

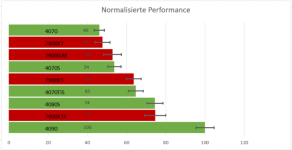

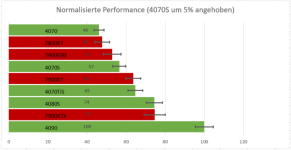

Ist es technisch möglich, bei den Balken Standardabweichungen oder Standardfehler anzugeben? Damit würde man auf den ersten Blick sehen wie gleichmäßig sich eine Karte über die verschiedenen Spiele verhält und ob eine Karte signifikant schneller als eine andere Karte ist.

Theoretisch möglich ist das, aber dazu müssten dann ja die Diagramme größer geändert werden und neben den AVG-FPS und den Perzentil-FPS eine dritte Messreihe aufgemacht werden. Entsprechende Messungen wurden bis jetzt in den Kommentaren aber noch nicht wirklich gefordert - vielleicht bist da gar der erste, der danach fragt. Wenn diesbezüglich mehr Feedback auftaucht, ist das sicherlich eine Überlegung wert.