Valix schrieb:

ein Armuts Zeugnis für so teure Karten wie 1080ti, RX64

keine 60Fps in 4K

Wieso? Und die Frage ist unabhängig von der Optimierung des Spiels.

Mal ganz pauschal gesagt:

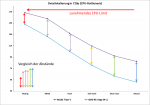

1920×1080 (FHD, Full HD, 2K 1080p) = 2.073.600 Pixel = "vergangene"Grafikkartengeneration

2560×1440 (QHD, WQHD, Quad HD, 1440p) = 3.686.400 Pixel = aktuelle Grafikkartengeneration

3840×2160 (UHD, Ultra HD, 4K, 2160p) = 8.294.400 Pixel = (vielleicht die) kommende Grafikkartengeneration

Und das ist bezogen auf 60 fps+.

Wir haben eine Ver

vierfachung der Pixelanzahl, aber die Grafikkartengenerationen werden nicht entsprechend schneller.

Vor 2010 lag der Durchschnitt bei einer neuen High-End-Geforce im Vergleich zur vorherigen Generation demnach im Schnitt bei 70 Prozent und in manchen Fällen sogar bei 100 Prozent. Beispiele dafür sind die Geforce 6800 Ultra und die Geforce 8800 GTX.

Seit einiger Zeit gibt es mit der Ausnahme der

aber keine Steigerungen über 50 Prozent mehr und der Durchschnitt liegt seit dem Jahr 2010 bei rund 30 Prozent Mehrleistung bei einer neuen Geforce-Generation.

Quelle Gamestar

Gab einen ähnlichen Artikel auf CB (meine ich), finde aber den Link nicht.

Ich spiele in Full HD und lege Wert auf viele Bilder pro Sekunde.

Wenn "weniger" Bilder reichen dann:

Pisaro schrieb:

Ähm.. das schaffen die Karten fast nie in 4K und max Details. Gibt halt noch keine “richtigen“ 4K Karten. Habe meine 1080Ti für 1440p gekauft, dafür ist die Karte perfekt.

Gaspedal schrieb:

1080Ti ist ja auch keine Karte für 60fps/4k, das schafft der kaum ohne an Details runterzuschrauben, es sei denn man spielt alte Spiele oder Spiele ohne grafische Höchstleistungen. Die Hoffnung liegt bei 1180Ti.

Und genau dafür sind die Karten brauchbar!

Grüße