Nach weiteren tiefgründigen Recherchen habe ich noch folgendes herausgefunden:

AMD hat den längsten Balken zwinker zwinker

Ach ja, aber nicht wenn du Quelle Link Folie Screenshot Text vergleichst haha

Waaaas? Dann schau dir doch mal Link Quelle Screenshot Text Folie an haha ha

Na und? Nvdia hat schon immer die bessere Archtitektur gehabt - Benchmark von 2015 auskram höhöhö

Ja aber was interessiert mich den Kram von gestern wir haben 2020 alter hmpf

Und in 2020 stürzt immer noch und jederzeit der Treiber von AMD ab - AMD Bluescreensimulator lach lach

Und die Treiberoberfläche von Nvdia sieht noch so aus wie aus den 90ern - Windows 95er lässt grüßen rofl

Dafür hat Nvdia die geilsten Techniken und ist AMD mindestens Lichtjahre voraus bunga bunga

Und was ist mit AMD Mantle und Freesync? balla balla

Mir doch egal - ich hab GSync - wat soll ich damit? uff tata

Ja, aber AMD macht alles open source und ist Messias of IT heiligenschein aufsetz

Bei Nvdia weiß man was man hat. Nvidia = Qualität. AMD = solala War schon immer so. Bleibt so! Tada

Dafür verbraucht AMD viel weniger Strom yeah yeah peace

Und was ist mit den Grafikkarten anno furry und vega? Voll unökologisch tuff tuff

mir doch egal. nvidia kauft sich überall ein und ist evil. schwup di wup

he nicht ablenken nvidia 3090 läuft auch auf einen Premium 350W Netzteil in voller Auslastung klatsch batsch

Na und? Meine AMD mit undervolting extreme und Wasserkühlung läuft mit viel weniger Watt schüttel schüttel

Dafür macht AMD Smart Access Memory nur für AMD, sollte das mal Intel oder Nvidia machen augenroll

AMD ist immer total fair und gerecht und denen ist Geld egal, siehe Präsentationen der letzten Jahre halleluja

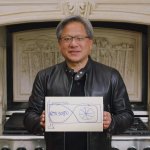

Moment ich suche gerade mal ne Folie wo das nicht stimmt.. Ah hier... oder? hinklatsch

Dafür leuchtet die rote RGB viel besser als die Grüne? häh

Moment? Waaasss?

Ach, lass uns von vorne anfangen...

Sind nur AMD Marketing Folien bla bla

AMD hat bessere Preise hehehe

Raytracing ist Nvdia besser blub blub

...

Vermutlich gibt es noch mehr solcher schönen Geschichten.

Wie schon gesagt, Augen schließen und tief durchatmen.

Beide haben dieses Jahr gute Grafikkarten und lasst die Leute doch kaufen was sie wollen.

Es muss lieferbar sein.

Ich drücke euch die Daumen, dass ihr die Karte eurer Wahl noch vor Weihnachten bekommt.