Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Samsung startet Massenproduktion von DDR4-Speicher

- Ersteller MichaG

- Erstellt am

- Zur News: Samsung startet Massenproduktion von DDR4-Speicher

r4yn3

Admiral

- Registriert

- Mai 2006

- Beiträge

- 7.697

Wichtigster Engpass...Brücke, ich verstehe... https://www.computerbase.de/artikel/prozessoren/welchen-ram-fuer-intel-ivy-bridge-test.1759/seite-4

Bei APUs und deren iGPU mag der Ramtakt durchaus relevant sein. Für den normalen Desktopuser jedoch wohl kaum.

Bei APUs und deren iGPU mag der Ramtakt durchaus relevant sein. Für den normalen Desktopuser jedoch wohl kaum.

Nai

Lt. Commander

- Registriert

- Aug. 2012

- Beiträge

- 1.586

Leider ist in den Zeiten der großen CPU-Caches die Geschwindigkeit von RAM immer weniger relevant. Eine Steigerung um 25% ist beim pc eine Steigerung um 1-2%. Vielleicht wird sich das mit der Huma-Architektur ändern.

Die CPU kann ihre Daten durch mehre Cachebenen, ausreichend schnell bearbeiten. Ein "langsamer" DDR4 Speicher der erst nach einem L1, L2 und L3 Cache an der Reihe ist, liefert dem L3 Cache als letztes die Daten. Aus diesem Grund gab es bei den alten CPUs ohne ausreichend Cache immer große performancegewinne wenn schneller RAM eingesetzt wurde.

Das ganze ist sehr sehr pauschal. Ein Cache kann seine Wirkung nur bei bestimmten Zugriffsmustern auf den DRAM entfalten, also wenn die entsprechenden Speicheradressen bei einem Zugriff auch gecacht sind. Dies ist zB. der Fall wenn man mehrmals kurz nacheinander auf die selben Addressen im DRAM zugreift oder wenn man nur so wenig DRAM benötigt, dass dieser komplett in den Cache passt.

Das Zugriffsmuster ist jedoch im Allgemeinen sehr stark von der entsprechenden Anwendung abhängig. Hat man eine Anwendung deren Zugriffsmuster sehr cachefreundlich ist, so spielt die Performance des DRAMs natürlich keine oder nur eine geringe Rolle. Hierunter fallen zB. die meisten Spiele. Hat man jedoch eine Anwendung, deren Cachezugriffsmuster sehr cacheunfreundlich ist, dann spielen die Zugriffszeiten und die Bandbreite des DRAMs eine große Rolle. Hierunter würde ich zB. Bildbearbeitungsfilter Datenbankanwendungen und Raytracing auf großen Datensätzen einordnen.

Wichtigster Engpass...Brücke, ich verstehe... https://www.computerbase.de/artikel/prozessoren/welchen-ram-fuer-intel-ivy-bridge-test.1759/seite-4

Bei APUs und deren iGPU mag der Ramtakt durchaus relevant sein. Für den normalen Desktopuser jedoch wohl kaum.

Tut mir leid, aber diese Benchmarks aus dem Link sind zum Teil extremer Schrott. Nehmen wir einmal das Bildbearbeitungsbenchmark aus dem Link her: https://www.computerbase.de/artikel/prozessoren/welchen-ram-fuer-intel-ivy-bridge-test.1759/seite-18. Diese dort angewendeten Bildbearbeitungsfilter gehören in der Regel zu denjenigen (Streaming)-Anwendungen, welche extrem Speicherbandbreiten limitiert sind. Bei diesem Benchmark wurde jedoch gemäß Screenshots eine Bildgröße bzw. Problemgröße von 1024x768x32Bit(?) also von 3 MB gewählt. Dadurch sind die Daten bei dem wahrscheinlich verwendeten Double-Buffering 6 MB groß, wodurch sie wiederum komplett in den 8MB großen Cache passen. Aus diesem Grund wird der DRAM bei dem Benchmark überhaupt nicht belastet, weshalb man natürlich keinen Unterschied bei unterschiedlichen Speicherbandbreiten und Speicher-Timings merken wird. Interessant wäre es geworden, wenn man eine wesentlich größere Problemgrößen gewählt hätte, welche eben nicht in den Cache passen würden. Fazit: Diese Problemgröße ist völlig ungeeignet, wenn man den Einfluss der Speicherbandbreite auf die Performance messen will.

Interessant finde ich es hier noch anzumerken, dass man bei Bildbearbeitung meines Wissens nach in der Regel mit wesentlich größeren Bildern (zB. 4000x4000) arbeitet und Profis sogar eine höheren Farbtiefe verwenden. Dadurch ist dieses Benchmark nicht nur für den Einfluss der Speicherbandbreite auf die Performance ungeeignet, sondern entspricht nicht einmal den Alttags-Anwendungsfällen.

Ja, aber wenn die Daten nie in irgendeinem Cache zu finden sind, weil eben jedes Datum nur einmal angefasst wird, dann haste verloren, dann sind deine Caches komplett nutzlos. Sie sind auch komplett nutzlos, wenn das Workingset nicht mehr in den Cache passt. Dann trashst du dir nämlich fröhlich die Cachelines und lädst dann danach wieder die gleichen Werte...sebastian1 schrieb:@[F]L4SH

wieso Schwachsinn?

Die CPU kann ihre Daten durch mehre Cachebenen, ausreichend schnell bearbeiten. Ein "langsamer" DDR4 Speicher der erst nach einem L1, L2 und L3 Cache an der Reihe ist, liefert dem L3 Cache als letztes die Daten. Aus diesem Grund gab es bei den alten CPUs ohne ausreichend Cache immer große performancegewinne wenn schneller RAM eingesetzt wurde.

Gerade Datenbankanwendungen machen so was gern, weil die Datensätze sehr sehr groß sind, und die Zugriffsmuster sehr sehr irregulär. Glaubst du IBM und SPARC verbauen nur so aus Spaß Octa-Channel usw zusätzlich zu gigantischen Caches?

Ein Cache wirkt halt nur, wenn das entsprechende Datum auch enthalten ist.

Nein? Mir schonMit den APUs ist klar da haben Gamer einiges von. Außerhalb des Gamingbereichs fällt mir aber nichts ein wo DDR4 einen merklichen Geschwindigkeitsschub bringen würde. (2-3% Beim zippen und video codieren zählt nicht)

Datenbankanwendungen

Filmrendering

Audiobearbeitung

KI

Wettersimulationen usw usw

Also alles wo man irreguläre Zugriffsmuster auf einem großen Memoryfootprint hat, und damit eben Bandbreitenlimitiert ist, und das ist ziemlich oft der Fall.

Der Witz ist ja, du verkennst die Realität völlig. Speicherbandbreite ist nicht etwa kein Problem mehr, weil man so große Caches hat, sondern man hat heute so große Caches, weil schon IMMER! Speicherbandbreite ein großes Problem war und auch immer bleiben wird....

Caches sind teuer, aber die einzige Alternative, um das Problem zu lösen

Streich mal das "mordern" und setz ein "JEDEM!" dafür ein.Mr.Seymour Buds schrieb:Oh je, gleich der erste Kommentar und dann so ein Käse. Die Geschwindigkeit von RAM ist also "immer weniger relevant". *Faceplam*. So ziemlich alle bekannten Anwendungen werden durch schnelleren RAM profitieren Langsamer RAM ist einer der wichtigsten, wenn nicht sogar der wichtigste Engpass in einem modernen Computer.

Es gab noch nie die Situation, dass der RAM nicht zu langsam war. Das Problem ist in den letzten Jahrzehnten nur immer schlimmer geworden....

Multithread

Ensign

- Registriert

- Juli 2013

- Beiträge

- 220

von Lösen kann keine rede sein, wenn schon ist der L3 Cache eine Symptom Bekämpfung, bzw. Linderung des Problems.Skysnake schrieb:Der Witz ist ja, du verkennst die Realität völlig. Speicherbandbreite ist nicht etwa kein Problem mehr, weil man so große Caches hat, sondern man hat heute so große Caches, weil schon IMMER! Speicherbandbreite ein großes Problem war und auch immer bleiben wird....

Caches sind teuer, aber die einzige Alternative, um das Problem zu lösen

Ich bin auch froh wenn der schnellere RAM Kommt, so als Programmierer ist man da genauso wie die mit den Servern je nach Projekt arg im RAM Bandbreitenlimmit.

E: Auf drölftausend Macrotasten möchte ich auch nicht verzichten, gibt da einfach viele funktionen und dinge die man problemlos als Macro key benutzen kann.

Zuletzt bearbeitet:

Pure Existenz

Banned

- Registriert

- Juli 2013

- Beiträge

- 2.899

Bin mal gespannt, wieviel Mehrleistung es bei Bildbearbeitung usw gibt.

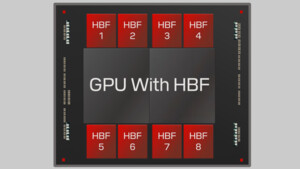

Ich hoffe mal auf eine richtig starke APU von der Leistung einer HD 7750 oder sogar noch etwas höher. Dazu nen "günstigen" DDR4 2666MHZ Ram und die Sache rennt :-)

Ich hoffe mal auf eine richtig starke APU von der Leistung einer HD 7750 oder sogar noch etwas höher. Dazu nen "günstigen" DDR4 2666MHZ Ram und die Sache rennt :-)

Dragon45

Lt. Commander

- Registriert

- Dez. 2009

- Beiträge

- 1.030

Hier würd ich mich auch gern einklingen. Ich finde es immer amüsant wie einige Nerd immer schauen wie neue Sachen in ihren Heimischen PC werken werden obwohl in den News eindeutig Serveranwendungen genannt werden, aber sei es drum.

Skysnake hat das schon richtig gesagt Serveranwendungen: Datenbanken, Filmrendering, Wettersimulationen usw. selbst Server von Google würden von einer höheren Datendurchsatz profitieren.

Mit Datendurchsatz ist auch genau das gemeint viele Daten schnell verarbeiten wie die Timing bzw. Zugriffszeiten aussehen interessiert hier offensichtlich niemand.

Selbstverständlich stimm ich einigen Beiträgen zu in punkto iGPU aber bis das kommt gehen 1-3 Jahre ins Land und dann wartet erstmal gescheite Tests ab und dann entscheidet selber ob euch der geforderte Aufpreis, der 100% für DDR4 kommen wird, für den gebotenen Leistungszuwachs zusagt.

Ansonsten ist alles nur ins blaue diskutiert. wie die Nerds die sich jetz ihren Rechner für BF4 aufrüsten ohne dass das Spiel released ist oder auch nur unabhänige Tests gibt. mMn völlig sinnfrei

EDIT @Yoshi_87

Wau hast Recht mein RAM siehe Sig. hat am 17.1.2013 noch 77€ gekostet jetz sind die schon bei 140€ bei der Mindfactory.

Skysnake hat das schon richtig gesagt Serveranwendungen: Datenbanken, Filmrendering, Wettersimulationen usw. selbst Server von Google würden von einer höheren Datendurchsatz profitieren.

Mit Datendurchsatz ist auch genau das gemeint viele Daten schnell verarbeiten wie die Timing bzw. Zugriffszeiten aussehen interessiert hier offensichtlich niemand.

Selbstverständlich stimm ich einigen Beiträgen zu in punkto iGPU aber bis das kommt gehen 1-3 Jahre ins Land und dann wartet erstmal gescheite Tests ab und dann entscheidet selber ob euch der geforderte Aufpreis, der 100% für DDR4 kommen wird, für den gebotenen Leistungszuwachs zusagt.

Ansonsten ist alles nur ins blaue diskutiert. wie die Nerds die sich jetz ihren Rechner für BF4 aufrüsten ohne dass das Spiel released ist oder auch nur unabhänige Tests gibt. mMn völlig sinnfrei

EDIT @Yoshi_87

Wau hast Recht mein RAM siehe Sig. hat am 17.1.2013 noch 77€ gekostet jetz sind die schon bei 140€ bei der Mindfactory.

Zuletzt bearbeitet:

r4yn3

Admiral

- Registriert

- Mai 2006

- Beiträge

- 7.697

Nai schrieb:Aus diesem Grund wird der DRAM bei dem Benchmark überhaupt nicht belastet, weshalb man natürlich keinen Unterschied bei unterschiedlichen Speicherbandbreiten und Speicher-Timings merken wird. Interessant wäre es geworden, wenn man eine wesentlich größere Problemgrößen gewählt hätte, welche eben nicht in den Cache passen würden. Fazit: Diese Problemgröße ist völlig ungeeignet, wenn man den Einfluss der Speicherbandbreite auf die Performance messen will.

Interessant finde ich es hier noch anzumerken, dass man bei Bildbearbeitung meines Wissens nach in der Regel mit wesentlich größeren Bildern (zB. 4000x4000) arbeitet und Profis sogar eine höheren Farbtiefe verwenden. Dadurch ist dieses Benchmark nicht nur für den Einfluss der Speicherbandbreite auf die Performance ungeeignet, sondern entspricht nicht einmal den Alttags-Anwendungsfällen.

Interessant, gibt es denn Benches/Tests die das auch wirklich belegen?

Ich finde nur einen älteren Anandtech Test, wo Photoshop mit einem 4800x3600 Image unter die Kategorie "macht keinen Unterschied" fällt. http://www.anandtech.com/show/2792/9

Nicht das ich trollen möchte, aber mich würde es nur interessieren.

Mr.Seymour Buds

Commodore

- Registriert

- Feb. 2012

- Beiträge

- 4.353

...und die Behauptung Spiele würden von steigender Speicherbandbreite nicht profitieren, zeugt übrigens von völliger Unkenntnis vom Hardwareaufbau. Denn gerade Spiele brauchen gigantische Speicherbandbreite, nur halt mit Zugriff auf den DRAM der Grafikkarte...

Man nehme sich mal das neuste Nvidia Grafikkarten-Schlachtschiff, den Nvidia GTX Titan. Der rennt mit sage und schreibe 288 GB/s Speicherbandbreite.

Quelle:

http://www.nvidia.de/object/geforce-gtx-titan-de.html#pdpContent=2

http://www.nvidia.de/titan-graphics-card/performance-specs

Und dieser Umstand sollte auch jedem APU Gamer klar sein, denn seine "Grafikkarte" nutzt dann bald DDR4...aus dem selben Grund -> Mehr Bandbreite.

Man nehme sich mal das neuste Nvidia Grafikkarten-Schlachtschiff, den Nvidia GTX Titan. Der rennt mit sage und schreibe 288 GB/s Speicherbandbreite.

Quelle:

http://www.nvidia.de/object/geforce-gtx-titan-de.html#pdpContent=2

http://www.nvidia.de/titan-graphics-card/performance-specs

Und dieser Umstand sollte auch jedem APU Gamer klar sein, denn seine "Grafikkarte" nutzt dann bald DDR4...aus dem selben Grund -> Mehr Bandbreite.

V0rtex

Lt. Junior Grade

- Registriert

- März 2009

- Beiträge

- 502

Mr.Seymour Buds schrieb:Oh je, gleich der erste Kommentar und dann so ein Käse. Die Geschwindigkeit von RAM ist also "immer weniger relevant". *Faceplam*. So ziemlich alle bekannten Anwendungen werden durch schnelleren RAM profitieren Langsamer RAM ist einer der wichtigsten, wenn nicht sogar der wichtigste Engpass in einem modernen Computer.

Vllt noch ein schönes Beispiel für "die Gamer". Die CPU ist heute so etwas, wie eine Fabrik auf einer Insel. Diese Insel ist nur über eine Brücke ans Festland angebunden. Anfangs konnten die Waren von der Fabrik ohne Probleme ans Festland versandt werden, aber dann wurde die Produktionskapazität der Fabrik verdoppelt. Nun stauen sich die Waren vor und auf der Brücke. Selbst wenn man die Fabrik nochmal erweitert, können nicht mehr Waren zum Festland gebracht werden, denn die Kapazität der Brücke ist erschöpft. Jetzt hilft nur noch: Eine 2. Brücke bauen. Und genau so ist das auch bei DDR4 Speicher...

Genial umschrieben

Wann kann man für normal sterbliche DD4 erwarten?

P

Peiper

Gast

Irgendwann 2015.

Außer du willst dir das erwähnte Haswell-E System zulegen dann wahrscheinlich früher.

Und das ist die Krux des ganzen.

Wer will eine Mittelkasse- oder gar eine Einstiegs-APU mit teurem RAM kombinieren?

Außer du willst dir das erwähnte Haswell-E System zulegen dann wahrscheinlich früher.

AMD war hier immer Vorreiter Bis auf wenige Ausnahmen

Ich hoffe mal auf eine richtig starke APU von der Leistung einer HD 7750 oder sogar noch etwas höher. Dazu nen "günstigen" DDR4 2666MHZ Ram und die Sache rennt

Und das ist die Krux des ganzen.

Wer will eine Mittelkasse- oder gar eine Einstiegs-APU mit teurem RAM kombinieren?

Nai

Lt. Commander

- Registriert

- Aug. 2012

- Beiträge

- 1.586

Interessant, gibt es denn Benches/Tests die das auch wirklich belegen?

Ich finde nur einen älteren Anandtech Test, wo Photoshop mit einem 4800x3600 Image unter die Kategorie "macht keinen Unterschied" fällt. http://www.anandtech.com/show/2792/9

Nicht das ich trollen möchte, aber mich würde es nur interessieren.

Dafür reicht einfache Mathematik. Nehmen wir einen separable Gaussian Blur 3x3-Filter (http://de.wikipedia.org/wiki/Gauß-Filter) auf ein SP-Float-Bild. Pro Pixel und Kanal braucht man dann 12 Flops (eigentlich 11 aber das geht nicht so gut auf) und 8 Byte DRAM-Bandbreite, wodurch sich ein Verhältnis von 1.5 zu 1 ergibt. Momentan sind wir bei Haswell bei in etwa 450 SP-Gigaflops (Quelle: http://stackoverflow.com/questions/...le-for-sandy-bridge-and-haswell-sse2-avx-avx2) und 30 Gigabyte DRAM-Bandbreite, was einem Verhältnis von 15:1 entspricht.

Nun zu deinen Benchmarks: Es gibt (Programmier)-Techniken dieses Bandbreiten-Limit zu vermeiden. So kann man bei der Verknüpfung mehrerer Filter - eben das was dieses Benchmark tut - sehr gut Blocking-Algorithmen verwenden: Bei diesen wendet man nicht Filter für Filter auf das gesamte Bild an, da man in diesem Fall das ganze Eingabe- und Ausgabebild mehrmals durch die Caches streamen müsste, sondern man unterteilt das Bild in (Cachegroße)-Blöcke und wendet alle Filter in direkter Folge auf einen solchen Block an. Dadurch wird der Block bei den ersten Filter in den Cache geladen und bei den darauffolgenden Filtern werden nur noch Daten aus dem Cache angefordert. Auf diese Weise kann man einen Großteil der Speicherbandbreite einsparen, wodurch diese wiederum keine Rolle bei der Performane spielt. Ich kann hier zwar nicht in Photoshop "hineinschauen" jedoch würde es mich überraschen wenn ein professionelles Programm wie PS nicht solche einfachen Performanceoptimierungen bei Makros verwenden würde.

Des Weiteren gilt meine Aussage nur bei den relativ einfachen Standard-Filtern. Sobald man komplexere Filter hat ist man sehr schnell wieder nicht im Bandbreiten- sondern am Rechen-Limit. Leider kann aus deinem Linkt nicht folgern was genau für Filter verwendet worden sind.

r4yn3

Admiral

- Registriert

- Mai 2006

- Beiträge

- 7.697

Wenn es so einen erheblichen Unterschied macht, warum macht sich keiner die Mühe das auch nur ansatzweise zu testen? Stattdessen testen die ganzen Seiten alle nur Crap. Wenn es so viel ausmacht, sollte man das doch ziemlich einfach feststellen können, oder etwa nicht?

Mr.Seymour Buds

Commodore

- Registriert

- Feb. 2012

- Beiträge

- 4.353

V0rtex schrieb:Genial umschrieben

Wann kann man für normal sterbliche DD4 erwarten?

Lukii schrieb:Ab wann wird DDR4 für Spieler intressant? Noch 2014, oder erst später?

Also soweit ich weiss, 2014. Vorher auf keinen Fall. Bis die Module wirklich im Massenmarkt ankommen wird es also noch dauern.

r4yn3 schrieb:Wenn es so einen erheblichen Unterschied macht, warum macht sich keiner die Mühe das auch nur ansatzweise zu testen? Stattdessen testen die ganzen Seiten alle nur Crap. Wenn es so viel ausmacht, sollte man das doch ziemlich einfach feststellen können, oder etwa nicht?

Ach, das testen schon genug Seiten, nur keine Gamer-Seiten. Wie gesagt, Games sind im allgemeinen ziemlich gutmütig was Speicher anbelangt. Und bei APUs wird immer gesagt, das schnellerer Speicher viel bringt.

Mr.Seymour Buds

Commodore

- Registriert

- Feb. 2012

- Beiträge

- 4.353

Nai schrieb:

Perfekt erklärt. Genau so macht man das normalerweise bei speicherlimitierten Anwendungen. Ich kenne es vor allem aus dem Bereich Scientific Computation, zB aus dem Bereich CFD. Hier nennt man das Blocking teilweise auch Stencil Operation oder Halo-Grid mit Ghostcells.

r4yn3

Admiral

- Registriert

- Mai 2006

- Beiträge

- 7.697

Ja bitte, zeigen.Skysnake schrieb:Ach, das testen schon genug Seiten...

Nai

Lt. Commander

- Registriert

- Aug. 2012

- Beiträge

- 1.586

Perfekt erklärt. Genau so macht man das normalerweise bei speicherlimitierten Anwendungen. Ich kenne es vor allem aus dem Bereich Scientific Computation, zB aus dem Bereich CFD. Hier nennt man das Blocking teilweise auch Stencil Operation oder Halo-Grid mit Ghostcells.

Danke. Ist ja alles mehr oder wenig programmiertechnisch das selbe: Ob man eine ndimensionale-ODE löst oder ob man einen Filter auf ein ndimensionale-Bild anwendet

Wenn es so einen erheblichen Unterschied macht, warum macht sich keiner die Mühe das auch nur ansatzweise zu testen? Stattdessen testen die ganzen Seiten alle nur Crap. Wenn es so viel ausmacht, sollte man das doch ziemlich einfach feststellen können, oder etwa nicht?

Weil die entsprechenden Redakteure in den meisten Fällen nicht aus den universitäten Bereich kommen, sondern das ganze hobbymäßig ohne entsprechende Ausbildung machen. Da nimmt man dann mangels Hintergrundwissen einfach irgendwelche Standard-Use-Cases ohne sich überhaupt Gedanken zu machen, ob es sinnvoll ist diesen Use-Case als Benchmark für diese oder jene Hardwarekomponente herzunehmen.

Ein weiteres gutes Beispiel, welches ich gefunden habe ist dieses Benchmark: https://www.computerbase.de/artikel/prozessoren/welchen-ram-fuer-intel-ivy-bridge-test.1759/seite-16

Hier konvertiert man eine 700 MB große Audiodatei in eine 30(?)-MB große MP3 Datei und benötigt 37 Sekunden. Das ganze ist eine Streaminganwendung, bei welcher der Workingset höchst wahrscheinlich komplett in den Cache passt. Denn das Konvertieren läuft bei solchen Audioformaten immer in kleinen Blöcken ab, da diese Audioformate, damit man sie streamen kann, ebenfalls in Blöcke unterteilt sind. Dadurch lädt man bei optimalen Caching diese 700 MB genau einmal in den Cache und schreibt die 30-MB genau einmal zurück in den DRAM. So benötigen wir insgesamt 730 MB DRAM-Bandbreite über 37 Sekunden. Bei 30 GB/s DRAM-Bandbreite ergibt das wiederum eine Auslastung der DRAM-Bandbreite von 0.07 Prozent. Hieran merkt man sehr schnell: es ist sinnlos in diesem Anwendungsfall eine (spürbare) Skalierung der Performance mit der Speicherbandbreite zu erwarten.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 126

- Aufrufe

- 8.376

- Antworten

- 48

- Aufrufe

- 13.085

B

- Antworten

- 63

- Aufrufe

- 10.042

- Antworten

- 24

- Aufrufe

- 6.410

- Antworten

- 24

- Aufrufe

- 6.277

Z