- Registriert

- Apr. 2004

- Beiträge

- 188

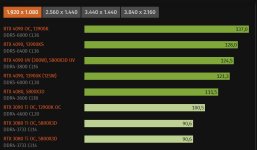

Glaube ich nicht. Derjenige mit der 3080 ti hat einen 5800X3D und ich mit der 3070 nur einen 5600x und deutlich mehr FPS. Auch die anderen 3080 sind deutlich über meiner 3070 und über der gelisteten 3080 ti. Denke irgendwas passt beim User mit der 3080 ti nicht. Vielleicht sehr alte Treiber...habla2k schrieb:Liegt das dann am CPU Limit?

Noch erwähnen sollte ich zu meinen Werten, dass mein Windows 11 eine Neuinstallation von vor ca. 2 Wochen ist ohne jegliche Bloodware oder ähnliches.

Was ich aber interessant finde, dass selbst meine 3070 schneller ist als eine 7900XTX.