.Sentinel. schrieb:

Das Inferencing ist die Auflösung bzw. die Verschaltung hinter der Pixelgewichtung und funktioniert auf Tensorcores extrem schnell. Es ist eine gute Wiedergabepipeline um die antrainierte "Erfahrung" umzusetzen.

Das DL "also Deep Learning" von "DL"SS kommt aber über das Rechenzentrum.

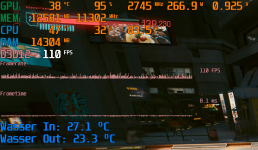

Der Prozess ist mit dem hier zu vergleichen:

Die Logik der Spieler wird am Besipiel oben extern trainiert und das aufwändige Trainingsmodell dann vom PC "wiedergegeben".

Ohne dir zu wiedersprechen. So wie ich es als Laie verstanden habe, wird im Rechenzentrum per Deep Learning bzw. Machine learning (zwei Begriffe, die wohl exakt das selbe beschreiben) anhand eines großen Datensatzes ein neuronales Netzwerk auf eine bestimmte Funktion hin trainiert.

Um dieses trainierte Neuronale Netz oder auch "AI Model" (enthalten in der .dll Datei) auf einem Client auszuführen , wird spezielle Hardware benötigt, die besonders schnell Matrix Multiplikationen durchführen kann. (weil sonst viel zu langsam)

Ist das so korrekt?

Also einerseits ist schon klar, dass der Lernprozess im Rechenzentrum stattfinden muss. Aber andererseits muss das Model ja am Client ausgeführt werden und dann basierend auf dem Input trotzdem in echtzeit "besonders intelligente" Entscheidungen treffen, die nur mit einem solchen AI Model möglich sind. Und genau das ist doch (abgesehen vom Lernprozess im rechenzentrum) nochmal der entscheidende Part.

Wenn man im Rechenzentrum einfach nur nen genialen Algorithmus findet, bräuchte man am Client ja auch keine "spezielle" Hardware, um diesen auszuführen. Man hätte ja praktisch FSR2 dann auch per Deep learning erstellen können.

Der entscheidende Punkt ist aber wie gesagt nach meinem Verständnis, dass am Rechner nicht einfach nur ein klassischer Algorithmus ausgeführt wird, sondern eben ein fertig trainiertes AI Model bzw. Neural Network.

Natürlich könnte man das AI Model nüchtern betrachtet als beliebigen "algorithmus" sehen, der stark auf Matrix Multiplikationen setzt. Aber im Kern ist ja genau das die Besonderheit, die neuronale Netzte nutzbar macht.

Na ja, ich hab ehrlich gesagt keine tiefergehende Ahnung davon, kann auch völliger Unsinn sein, was ich schreibe. Ich versuchs mir auch nur herzuleiten, dennoch kanns ja nicht so schwer sein, zumindest mal die Makro Ebene davon zu verstehen. Du scheinst etwas Ahnung davon zu haben, vielleicht haste ja noch ein, zwei Links Parat