Balikon schrieb:

Das tut doch die normale 3090 auch, sobald man RT aktiviert, oder sehe ich das falsch? Wüsste nicht, dass die 6900XT dieselbe RT-Leistung wie die 3090 hätte.

wenn du die „Leistung“ jetzt ausschließlich auf raytracing begrenzt dann ja.

dabei sind die 3090 und die 6900xt ja eigentlich keine direkten Kontrahente, wenn ich mir die UVP angucke. Eher die 3080ti.

Die 6900xt kommt halt nur erstaunlich oft an die 3090, je nach Auflösung auch gerne dran vorbei. Wenn ich mir die für das flüssige Gaming-Gefühl wichtigen Feametimes angucke, liegt die 6900xt gar immer vor der 3090

Selbst der 4K Thron wird ja immer öfters mal angeknabbert Und da führt die 3090 mit gerade noch 1%

Dazu meist bessere frametimes. Ach und der Verbrauch Ist da ja auch nochmal ne andere Liga.

Dazu gibt es alle paar Treiber nochmal mehr Leistung (mich würde mal ein aktueller vergleich interessieren)

Na und bei Titeln die nicht Nvidia Raytracing exklusiv sind, ist der er Abstand ja auch nicht Mehr so heftig wie anfangs bei Control und cp77 zb.

Also eigentlich ist die 6900xt in allen Belangen außer rt schneller oder gleich gut, mittlerweile selbst in 4K. wenn ich das dann in relation mit dem Verbrauch und Preis setze, hat rt für mich keinerlei Relevanz mehr. Ganz im Gegenteil zu DLSS

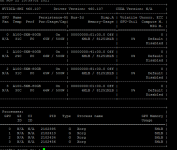

Edit: habe mir gerade mal die letzten drei getreten Games hier auf cb angeguckt, einfach die letzen drei Titel

Forza

Battlefield

cod

Da kann die 6800xt sich ja gar mit der 3090 anlegen