Daedal schrieb:

Das ist technisch falsch. Hast du eine Quelle dafür, dass Adaptive Sync Monitore sich nicht selbst refreshen?

Was verstehst du denn hier unter selbst refreshen?

Natürlich führt die Elektronik des Monitors den refresh durch, allerdings nur, wenn es von außen durch die Grafikkarte getriggert wird und ein neues Bild anliegt.

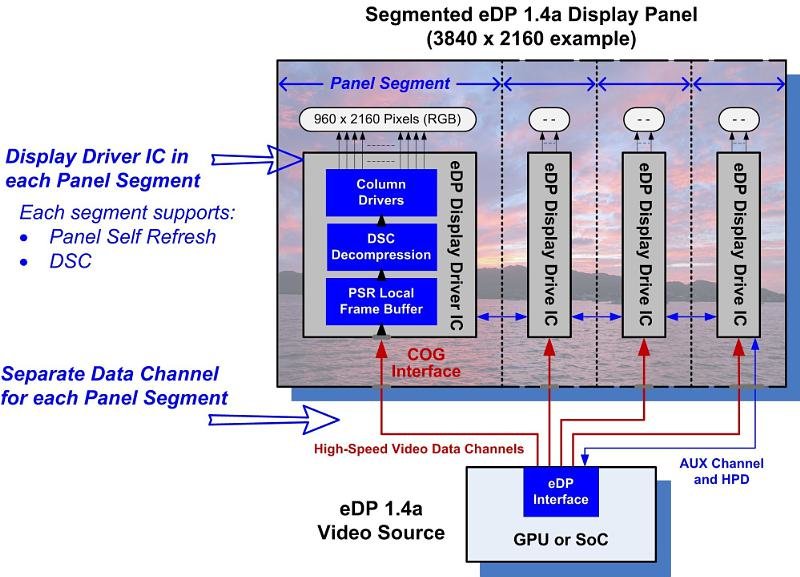

Der Monitor kann nicht selbstständig zu beliebigen Zeitpunkten eigenständige Refreshes durchführen. Das geht definitiv nicht. Das kann nur ein GSync Monitor mit G-Sync Modul, der das Bild in seinem Zwischenpuffer gespeichert hat. Der kann selbst entscheiden, mal zu einem beliebigen Zeitpunkt einen refresh durchzuführen auch wenn noch kein neues Bild von der Grafikkarte vorliegt. Wird unter anderem auch gut in dem Video erklärt.

GSync als grosser Bluff entlarvt - Nvidia nutzt AdaptiveSync der VESA für GSync

Ja klar. Voll der Bluff. Der von mir oben beschriebene Prozess würde ja auch so super funktionieren ohne verbauten Buffer im Monitor. Natürlich kann ich mir vorstellen, dass Gsync auch viele der selben Features nutzt wie Freesync um die synchronisation zu realisieren, aber GSync ist halt deutlich mehr als nur die synchronisation. GSync wäre ansonsten ja genauso kacke wie Freesync und hätte die gleichen Probleme. Hat's aber nicht.

GSync kommt besser mit den Grenzbereichen klar, es hat keine Ruckler beim Überschreiten der Grenzen, es ermöglicht einen ULMB Modus, es nutzt den Framebuffer mit großer Wahrscheinlichkeit für Overdrivetechniken und sorgt für schärfere Bilder, es stellt sich vielleicht noch raus, dass es zu Input-Lag Optimierungen verwendet wird und so weiter und so fort.

Besonders auf Tests zum letzteren Thema bin ich noch gespannt. Der Acer Predator XB270HU hat jedenfalls einen nahezu nicht existierenden Input Lag von lediglich einer viertel ms + Pixelswitching Delay.

Die Verarbeitung der Bilder geschieht also rasend schnell, was durchaus am Gsync Modul liegen könnte.

Daedal schrieb:

Natürlich ist es etwas völlig anderes. Das eine ist die Monitor Frequenz und das andere die Anzahl der Frames, welche die GPU in der selbe Zeit rendert.

Er hat ja auch nie gesagt, dass Hz = FPS sind und die GPU kommt hier ja überhaupt nirgendwo in's Spiel. Er sagte:

Die Grenze bei NVidia ist 30 Hz für alle Monitore, bei 29 Hz wird das bild mit 58Hz dargestellt, also Frames doppelt angezeigt

-- Ein Gsync Monitor stellt sein Bild mit einer variablen Bildwiederholrate dar. Sollte diese unter 30 Hz fallen, dann wird diese verdoppelt und wieder auf 58 Hz angehoben. Jedes Frame aus dem Buffer wird somit auch doppelt dargestellt. --

Das ist sinngemäß das war er gesagt hat und das ist bis auf die Tatsache mit den 30 Hz auch korrekt. Die Verdopplung fängt schon bei 37 Hz an, aber sein Beispiel ist auch so noch gültig.

Und ich habe dir nur gesagt, dass Hz und FPS nicht unbedingt zwei unterschiedliche Einheiten sind. Du kannst sie beide für Bildwiederholraten verwenden. Beides steht für 1/Sekunde. Wenn man also unbedingt möchte, dann kann man durchaus Hz und FPS durcheinanderwürfeln. Macht die Wikipedia Page zum Thema FPS übrigens auch so.

zwischen 20 FPS und 30 FPS liegen 40-60 Hz an (das doppelte der FPS). Da 19 FPS hier wiederum unterhalb der 40 Hz fallen würden wird die Frequenz nun verdreifacht. So liegen hier nun 57 Hz an, für 18 FPS 54 Hz etc... bis eben wieder die 40 Hz Grenze erreicht wird bei 13 FPS (39 Hz) wo es nun zu einer vervierfachung kommt ab hier.

Musst du mir nicht erzählen.

Das steht doch alles so in der von dir verlinkten Quelle von PCper inkl Bildchen, dass man dies sieht. GSync kommt ebenfalls zu keinem Zeitpunkt unter die 40 Hz Monitorfrequenz wie Freesync.

Ja, aber Freesync bleibt bei 40 Hz stehen. Das ist das Problem. Bei 40 Hz Vsync fallen dir die Ruckler extrem stark auf. Noch stärker als bei 60 Hz oder aber 144 Hz.

Und wenn man Vsync deaktviert, dann fallen dir die Tearing-Effekte bei 40 Hz extrem stark auf. Außerdem soll es beim überschreiten der Grenze immer einen spürbaren Ruckler geben, den du bei Gsync nicht spürst.