Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Grafikkarten 2023 im Test: GeForce-, Radeon- & Arc-Benchmarks im neuen Testparcours

T-Horsten

Cadet 4th Year

- Registriert

- Okt. 2020

- Beiträge

- 122

Genau das Gleiche Verhalten kann ich auch bei mir beobachten.No Escape schrieb:Nachdem ich Deinen Beitrag gelesen habe, musste ich natürlich gegen testen und den Gamingrechner hochfahren, ebenfalls 3440x1440, 165 Hz Monitor.

Im Treiber extra auf Standard gestellt, kein UV oder OC, mit folgendem Ergebnis im Leerlauf:

165Hz, meistens 12-13W, max 18W

144Hz, meistens 39-40W

120Hz, meistens 12-13W, max 18W

100Hz, meistens 11-13W, max 19W

75Hz, meistens 11-12W, max 13W

60Hz, meistens 11-12W, max 13W

Bei 165Hz ist der Idle verbrauch geringer als bei 144Hz.

Die Wege von RDNA3 sind unergründlich

Mickey Mouse

Fleet Admiral

- Registriert

- Aug. 2006

- Beiträge

- 10.599

einfach mal ein Lob und meinen Dank an solch einen umfangreichen und meiner Meinung nach wirklich gelungenen "Rundumschlag", Respekt!

Chilisidian

Lt. Commander

- Registriert

- Dez. 2019

- Beiträge

- 1.724

Liegt aber eher nicht an der Farbtiefe. Ob die Pixel nun 8 oder 10bit unterschiedliche Farben anzeigen, sollte im Verbrauch keine Auswirkungen haben. Wird eher daran liegen, dass Windows automatisch bei HDR die Gesamthelligkeit hochdreht. Dies kannst du für SDR Inhalte wie den Desktop in der Einstellungen aber wieder herabsenken.Angiesan schrieb:Tatsache, hatte mich noch gewundert und hatte das auf meinen Monitorwechsel geschoben und die damit etwas höhere Auflösung. Da der neue aber HDR unterstützt wird wenn man es im Windows einschaltet automatisch 10Bit Farbtiefe eingestellt und der Verbrauch geht von 15-16 Watt auf 20-22 Watt hoch.

wtfNow

Lt. Commander

- Registriert

- Dez. 2020

- Beiträge

- 1.412

Hat CB auch so nie behauptet.C4rp3di3m schrieb:Anhang anzeigen 1358414

Also das man bei 144Hz Desktop so viel Verbrauch hätte kann ich nicht bestätigen CB

mfg

Vielleicht nochmal lesen...

"Absolut schockierend ist die Leistungsaufnahme von AMDs neuen RDNA-3-Grafikkarten im High-End-Segment, wenn in Ultra HD 144 statt 60 Hz auf dem Desktop genutzt werden. Aus 17 Watt bei der Radeon RX 7900 XTX werden dann mal eben satte 104 Watt."

Das liegt am RGB der Karte! Bei meiner Gamerock habe ich mit RGB 20 Watt idle. Ohne RGB 5 Watt!SaschaHa schrieb:Danke für den ausführlichen Test!

Etwas verwundert haben mich die Ergebnisse der 4070 Ti im Leerlauf. Dass sie dort teilweise mehr als die 4080 oder gar die 4090 frisst, während die 4070 (non-Ti) durchweg sehr effizient arbeitet, verwundert etwas. Möglicherweise ein Treiberproblem, oder liegt's am Custom-Modell?

C4rp3di3m

Captain

- Registriert

- Jan. 2008

- Beiträge

- 3.175

Nee, die 6950 steht auch sehr weit oben mit 51WwtfNow schrieb:Hat CB auch so nie behauptet.

Vielleicht nochmal lesen...

mfg

- Registriert

- März 2009

- Beiträge

- 2.978

Snakeeater schrieb:Holprige Formulierung, erst der nächste Absatz bringt etwas Licht ins Dunkel. Mglw. liegts aber auch an mir.

Anhang anzeigen 1358382

Ich finde es unglaublich schwer diese Grafik zu deuten. Ist eine 7900XT nun besser als eine XTX oder nicht?

Die XTX ist etwas mehr im schlechterem Berreich, also ist die XT in dem Fall leicht besser

Zuletzt bearbeitet:

Wie schon gesagt, bei mir sinds in UHD@ 144Hz idle Desktop ~15.wtfNow schrieb:Hat CB auch so nie behauptet.

Vielleicht nochmal lesen...

"Absolut schockierend ist die Leistungsaufnahme von AMDs neuen RDNA-3-Grafikkarten im High-End-Segment, wenn in Ultra HD 144 statt 60 Hz auf dem Desktop genutzt werden. Aus 17 Watt bei der Radeon RX 7900 XTX werden dann mal eben satte 104 Watt."

Verwunderlicherweise werden es bei 120Hz mehr Watt und bei 100Hz nochmal mehr und dann wieder weniger bei 60Hz (~13W).

Wie schon erwähnt, Systemabhängig (auch Treiberabhängig), in irgendwelchen threads hatte ich schon mal Bilder angefügt, oder ergänze diese, falls Zweifel bestehen.

MfG

eLdroZe

Lt. Commander

- Registriert

- Jan. 2007

- Beiträge

- 1.467

Warum wollen denn so viele Leute Vergleiche zu noch älteren Karten? Ist doch logisch dass eine 1080 langsamer wie eine 2080 ist und eine 2080 langsamer wie eine 3080 oder gar 4080 ist.

Um wie viel spielt doch dann keine Rolle, in jedem Fall ist die Leistung um ein mehrfaches gestiegen.

Irgendwann muss man die alten Generationen vernachlässigen. Kann doch keiner Verlangen dass hier 40-50 Grafikkarten getestet werden... Die Arbeit bezahlt einem doch keiner.

In den tiefen des Internets gibt es Leute die solche Vergleiche ziehen, wenn man sucht. Aber hier ist es doch verständlich dass man sich auf aktuellere Hardware beziehen muss.

Es sind allgemeine Tests und keine spezifischen! Spezifische gibt es im Netz zu finden. Dafür muss man nur ein Paar Buchstaben in Google eintippen.

Um wie viel spielt doch dann keine Rolle, in jedem Fall ist die Leistung um ein mehrfaches gestiegen.

Irgendwann muss man die alten Generationen vernachlässigen. Kann doch keiner Verlangen dass hier 40-50 Grafikkarten getestet werden... Die Arbeit bezahlt einem doch keiner.

In den tiefen des Internets gibt es Leute die solche Vergleiche ziehen, wenn man sucht. Aber hier ist es doch verständlich dass man sich auf aktuellere Hardware beziehen muss.

Es sind allgemeine Tests und keine spezifischen! Spezifische gibt es im Netz zu finden. Dafür muss man nur ein Paar Buchstaben in Google eintippen.

Zuletzt bearbeitet:

Grundgütiger

Lieutenant

- Registriert

- Aug. 2017

- Beiträge

- 1.017

Vor allem ist es ja der selbe Chip bei 4070/4070ti, spätestens da hätte ich das Ergebnis vorerst nicht in die Liste aufgenommen.Experte18 schrieb:Das liegt am RGB der Karte! Bei meiner Gamerock habe ich mit RGB 20 Watt idle. Ohne RGB 5 Watt!

Bei Palit zB. Fällt RGB beim Verbrauch kaum auf, leider fällt deren Qualität (Plastik und Wärme) generell auch kaum auf.

Bei RDNA3 mit dem hohen idle verbrauch das selbe. Zumal es ja anscheinend auch ohne den hohen Verbrauch geht.

GerryB

Commodore

- Registriert

- Sep. 2016

- Beiträge

- 4.505

Vllt. hängt DAS mit Freesync zusammen?Cleanor schrieb:Wie schon gesagt, bei mir sinds in UHD@ 144Hz idle Desktop ~15.

Verwunderlicherweise werden es bei 120Hz mehr Watt und bei 100Hz nochmal mehr und dann wieder weniger bei 60Hz (~13W).

Falls AMD das LFC benutzt, wäre vllt. 72Hz auf nem 144Hz-Moni auch OK, weils sich dann noch verdoppeln lässt,

während 100Hz einfach net zu 144Hz passen.(da würde ja netmal Faktor 1,5 gehen)

edit: weiss net genau, ob überhaupt Faktor 1,5 vom Treiber genutzt werden kann auf dem Desktop, das wären

dann 96Hz, falls sich Sowas einstellen liesse.(als neue Custom-Resi)

btw.

Auf dem Desktop ne CustomResi zu nutzen, und fürs Gamen umzuschalten ist auch easy.

Ich nehme dafür das HRC-Tool, weil mir Windows-Eigenschaften zu umständlich ist.

https://funk.eu/hrc/

Die CustomResi lässt sich im Treiber-Paneel erstellen.

Zuletzt bearbeitet:

Mcr-King

Admiral

- Registriert

- Juli 2016

- Beiträge

- 7.268

glaube dass könnte sein

Ergänzung ()

also ich würde von den keine Karte mehr kaufen nur Teuer E-Schrot.Grundgütiger schrieb:Bei Palit zB. Fällt RGB beim Verbrauch kaum auf, leider fällt deren Qualität (Plastik und Wärme) generell auch kaum auf.

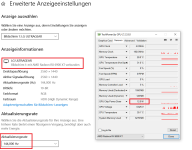

Zu dem hohen idle-Verbrauch bei RDNA3 kann man als Workaround eine benutzerdefinierte Auflösung einstellen bzw. nur die Refreshrate. Bei manchen halbiert sich der Verbrauch wenn man von 144 Hz auf 120 Hz geht. Wenn man jetzt noch "krumme" Werte einstellt, kann der Verbrauch bei 90-120 Hz teils auf unter 20 W gedrückt werden (muss man ausprobieren, bei manchen klappts schon 118 Hz, bei anderen 97 Hz usw.)

Für mich klingt das ganze nach irgendwelchen Resonanzproblemen innerhalb der Hardware und definitiv nicht nach irgendwelchen falsch hinterlegten LowPowerStates bzw. an deren Schwellwerten (wäre sonst ein Leichtes für AMD, das zu beheben).

Zum Test bzw. Parcour kann ich wieder nur sagen: Hut ab vor eurer Arbeit und der Armada an Daten, die ihr aufgenommen habt. Würde mir wünschen, dass exemplarisch auch alte Leistungsklassen bzw. zugehörige GPUs rein auf rechnerischer Basis mit in die Charts aufgenommen werden. Ihr müsst die ja nicht neu testen, sondern nur die alten Werte projizieren, was ihr dann mit nem Hinweis klarmachen könntet.

Mal abgesehen von der 4090 ist mir irgendwie immer die 6800 XT ins Auge gestoßen. Ich finde, dass die frühen Käufer dieser Karte, sofern der Preis dazumal nicht allzu überteuert war, alles richtig gemacht haben und die Karte hat weiterhin sehr gute Chancen in der Zukunft.

Für mich klingt das ganze nach irgendwelchen Resonanzproblemen innerhalb der Hardware und definitiv nicht nach irgendwelchen falsch hinterlegten LowPowerStates bzw. an deren Schwellwerten (wäre sonst ein Leichtes für AMD, das zu beheben).

Zum Test bzw. Parcour kann ich wieder nur sagen: Hut ab vor eurer Arbeit und der Armada an Daten, die ihr aufgenommen habt. Würde mir wünschen, dass exemplarisch auch alte Leistungsklassen bzw. zugehörige GPUs rein auf rechnerischer Basis mit in die Charts aufgenommen werden. Ihr müsst die ja nicht neu testen, sondern nur die alten Werte projizieren, was ihr dann mit nem Hinweis klarmachen könntet.

Mal abgesehen von der 4090 ist mir irgendwie immer die 6800 XT ins Auge gestoßen. Ich finde, dass die frühen Käufer dieser Karte, sofern der Preis dazumal nicht allzu überteuert war, alles richtig gemacht haben und die Karte hat weiterhin sehr gute Chancen in der Zukunft.

jo, wenn de aber auch mal zocken willsteMcr-King schrieb:Dann am besten zur ARC 380A oder eine Intel CPU mit xe iGPU benutzen reicht dicke aus

und was ist wenn du zocken und streamen willst etc. etc. bevor man sowas sagt, vielleicht einfach mal inne halten, und nicht direkt einen halbgaren kommt los schießen.

- Registriert

- Nov. 2009

- Beiträge

- 6.526

Ich kann zumindest für meine RX 6600 den Anstieg der Desktop-Idle-Leistungsaufnahme für 4K bei Wechsel von 60 Hz zu 144 Hz nicht bestätigen. Der Chip bleibt bei 4-6 Watt und die Takte sind sowohl bei GPU als auch VRAM nur zweistellig, also sehr niedrig. Ich weiß nicht, ob es da einen deutlichen Unterschied zwischen RX 6600 und RX 6650 XT gibt, oder ob es an einem neuen Treiber liegt. Ich bin da konservativ und noch auf Adrenalin 22.11.1.

Ähnliche Themen

- Antworten

- 178

- Aufrufe

- 11.934

- Antworten

- 469

- Aufrufe

- 42.138

- Antworten

- 356

- Aufrufe

- 115.651

- Antworten

- 368

- Aufrufe

- 51.285

- Antworten

- 877

- Aufrufe

- 280.018