Burfi

Commander

- Registriert

- Aug. 2008

- Beiträge

- 2.130

Ich finde die Verbesserungen durch DLSS in Kombination mit den Hardware Unboxed Optimized Settings sind extrem gut.

Ich hatte vorher auch den TAA Matsch in 4K und der Schärfefilter im Treiber hat mir überhaupt nicht gefallen. Dieser hat schon bei 10% viel zu stark nachgezeichnet mit deutlichen Verlusten in der Bildqualität.

Ich habe jetzt mit meiner 3080 (@ UV) etwa 85-90 FPS @ 4K HDR und das Bild ist deutlich klarer und ruhiger. Was das angeht bin ich also zufrieden.

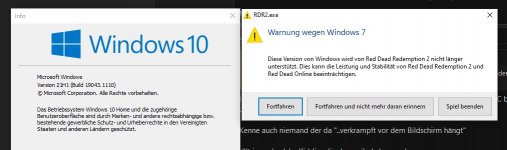

Davon ab habe ich seit der Neuinstallation dauerhaft Abstürze und Bugs. Genauso auch die Spikes in der Frametime sind mir direkt beim Spielen aufgefallen. Rockstar hat es immer noch nicht geschafft, das Spiel endlich einmal stabil zum Laufen zu bringen.

(Frisch aufgesetzt System mit neusten Treibern...)

Ich hatte vorher auch den TAA Matsch in 4K und der Schärfefilter im Treiber hat mir überhaupt nicht gefallen. Dieser hat schon bei 10% viel zu stark nachgezeichnet mit deutlichen Verlusten in der Bildqualität.

Ich habe jetzt mit meiner 3080 (@ UV) etwa 85-90 FPS @ 4K HDR und das Bild ist deutlich klarer und ruhiger. Was das angeht bin ich also zufrieden.

Davon ab habe ich seit der Neuinstallation dauerhaft Abstürze und Bugs. Genauso auch die Spikes in der Frametime sind mir direkt beim Spielen aufgefallen. Rockstar hat es immer noch nicht geschafft, das Spiel endlich einmal stabil zum Laufen zu bringen.

(Frisch aufgesetzt System mit neusten Treibern...)